Introduction

Dieses Repository beinhaltet diverse Zusammenfassungen des Studiengangs 2021 in Informatik an der ZHAW.

Helpers

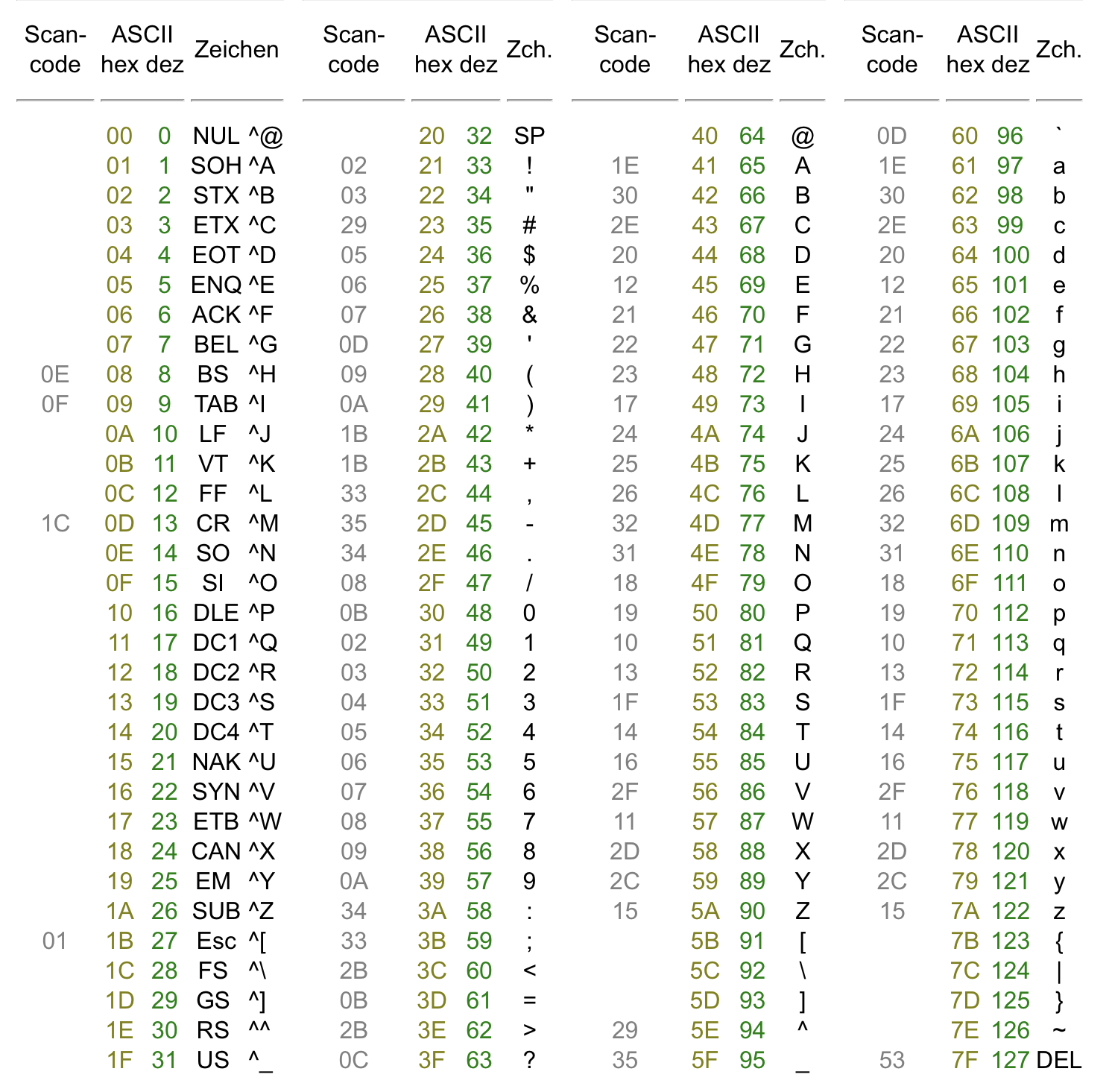

Hex Helpers

Dec to Hex

decimal = 1 print (f"Hex: {hex(decimal)}") print (f"Octal: {oct(decimal)}")

Hex to Int

hexadecimal = 0xFF print(f"Dec: {int(hexadecimal)}") print(f"Octal: {oct(hexadecimal)}")

Readme

| Begriff | Bedeutung | Notwendigkeit |

|---|---|---|

| MMU | Memory Management Unit | Laufen lassen von mehreren Anwendungen |

| BSP | Board Support Package | Benötigt, um auf das Board zuzugreifen |

| GPL | Gnu Public License | |

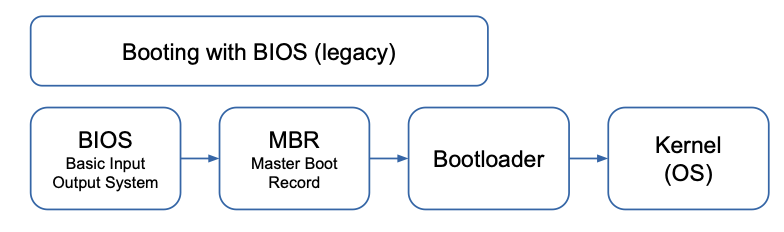

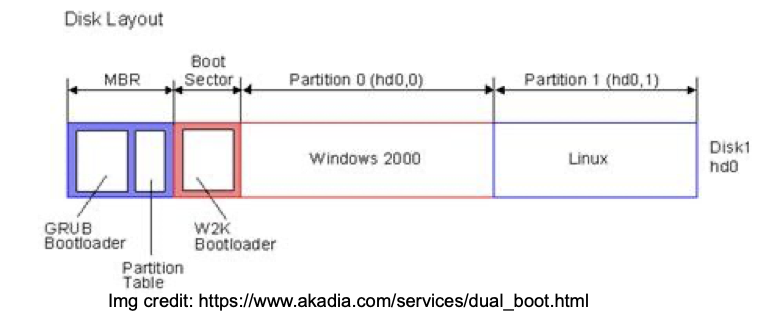

| MBR | Master Boot Record | Minimale Boot-Informationen, benötigt zum booten |

| TTY | Teletype | |

| NFS | Network File System |

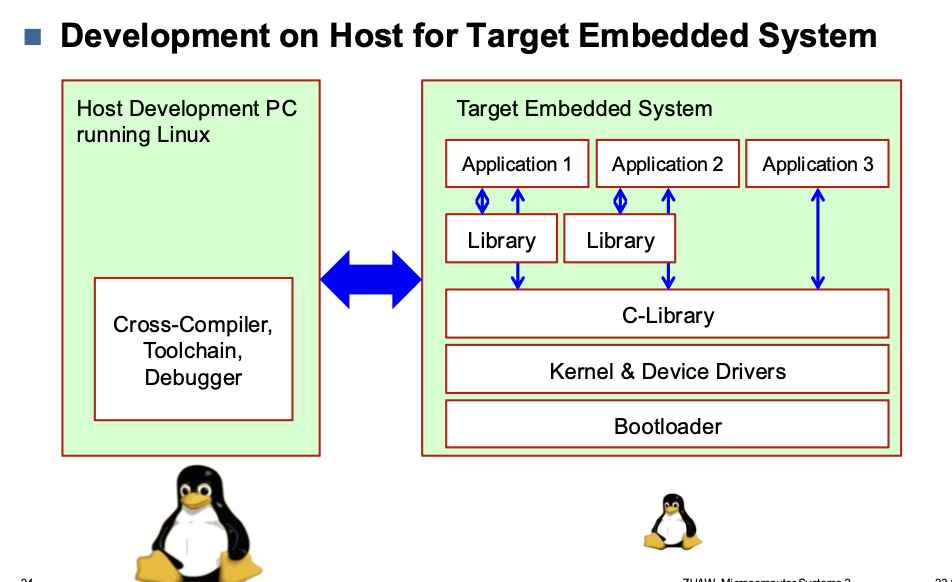

Toolchain

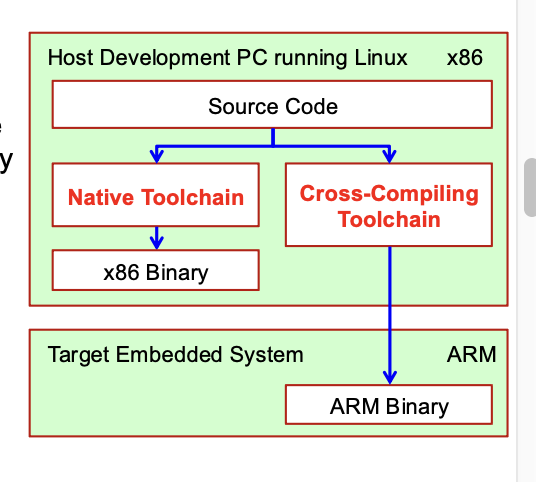

Cross Compilation toolchain

- Compiler that runs on the development machine, but generates code for the target

- Development machine is much faster than target

C library

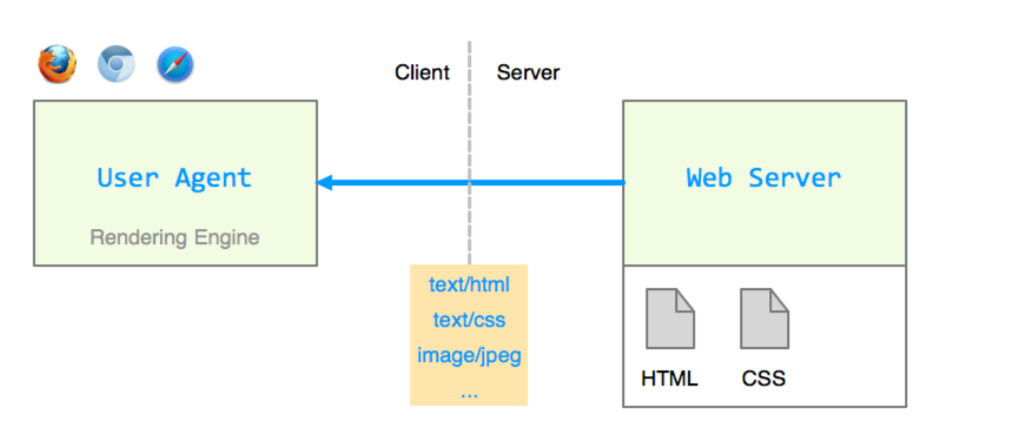

- Interface between the kernel and the user space applications

Kernel & Device Drivers

- Contains the process and memory management, network stack, device drivers and provides services to user space applications

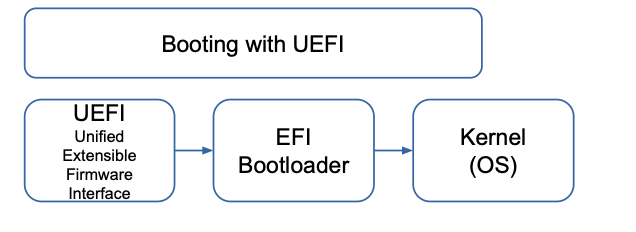

Bootloader

- Started by the hardware, responsible for basic initialization, loading and executing the kernel

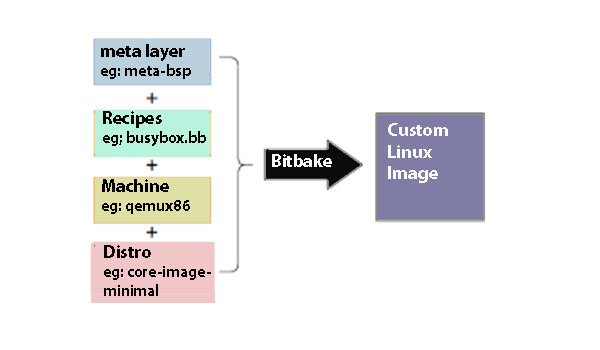

Recipes

A Bitbake recipe is a set of instructions that the Bitbake build engine takes as input to generate packages. The .bb extension is used for recipe files in the Yocto Project. Inside the Poky directory, many meta-layers contain recipe files, each associated with a particular software package.

Yocto recipe provides the following information to Bitbake.

Bitbake reads the recipe files and executes tasks defined in the recipe files and classes (.bbclass files) to generate the package.

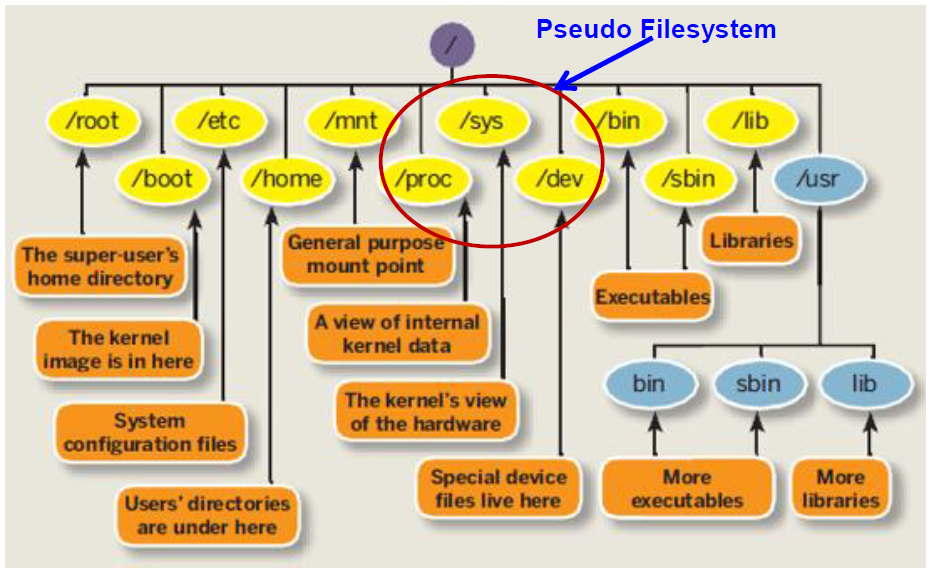

Linux Root Filesystem

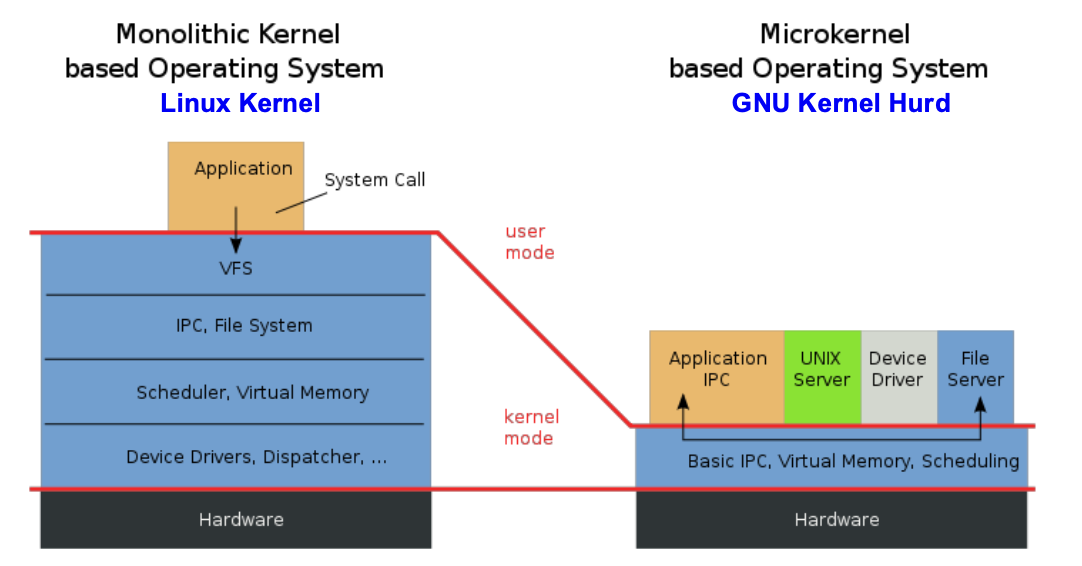

Kernel Architectures

- Monolithic Kernels are easier to program and debug

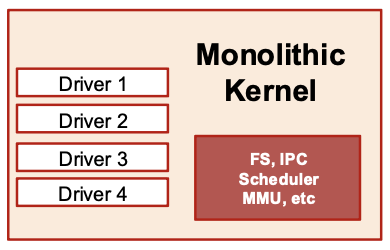

Monolithic Kernel

- Single executable file

- All Drivers are part of the Kernel

- Adding Driver to existing kernel: -> Recompile complete Kernel

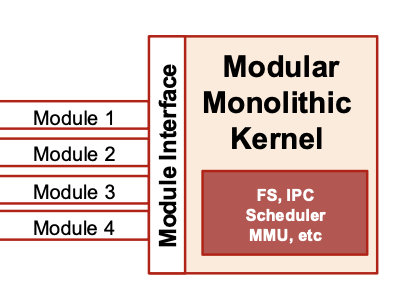

Modular Kernel

- A Monolithic Kernel with an interface for Kernel Modules

- Modular Kernels provide Module Interface

- Adding a Driver as a Module at run-time -> Without Recompiling Kernel

System Calls

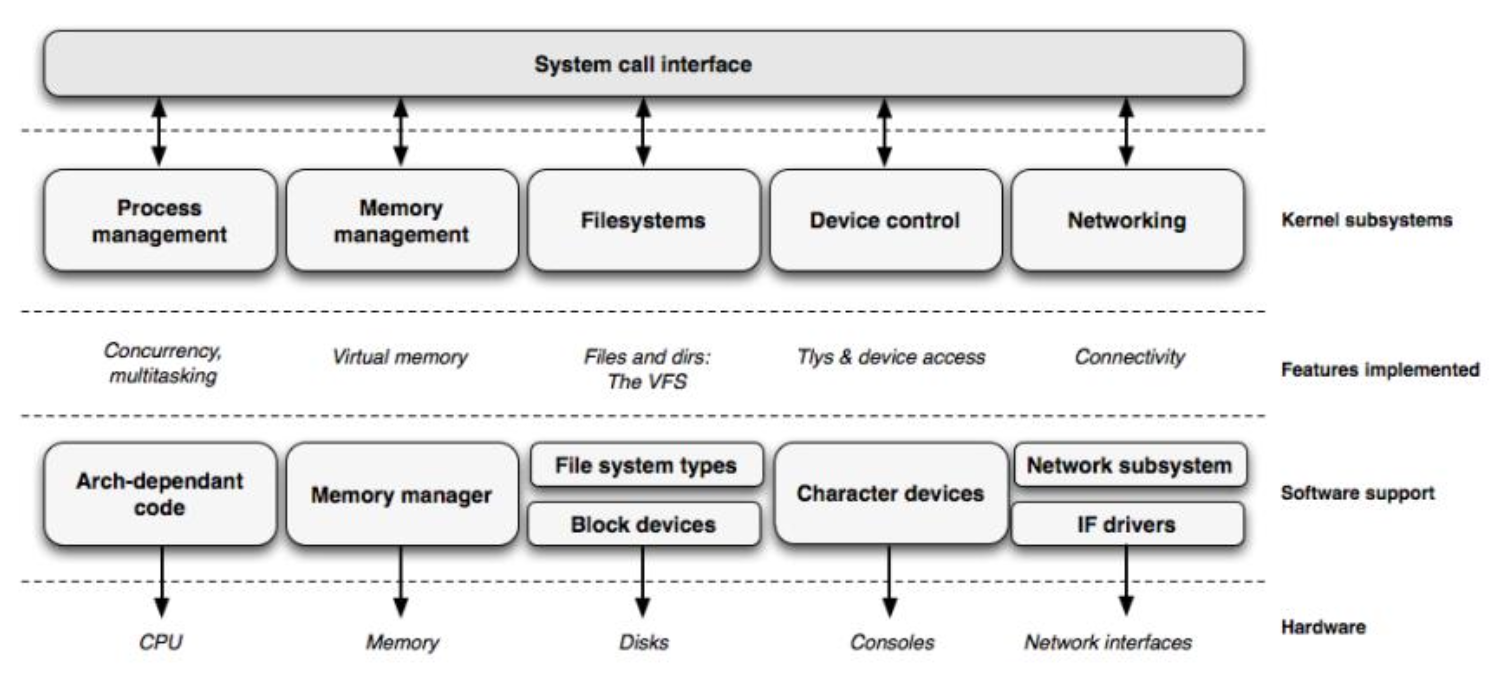

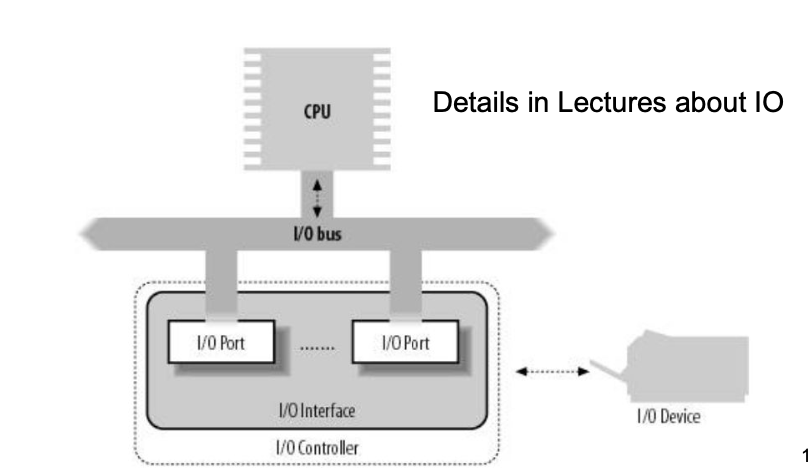

Kernel Main Roles

- Manage all the hardware resources

- CPU

- Memory

- I/O

- Manage task scheduling

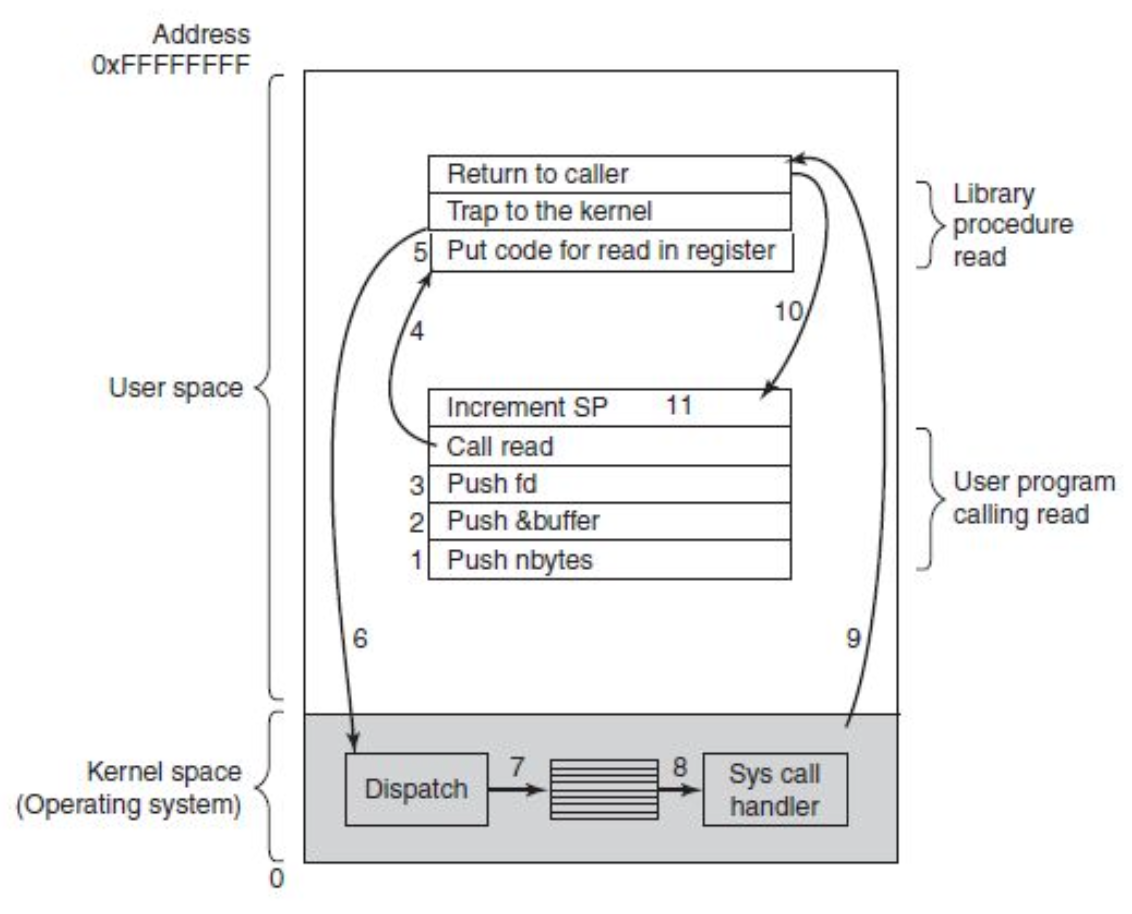

System Calls

- Main interface between kernel and user space

- About 300 system calls for min kernel services

- file and device operations

- networking

- inter-process communication (IPC)

- process management

- memory mapping

- timers

- threads

- synchronization primitives

- etc

- system calls wrapped by the C-library (no direct access)

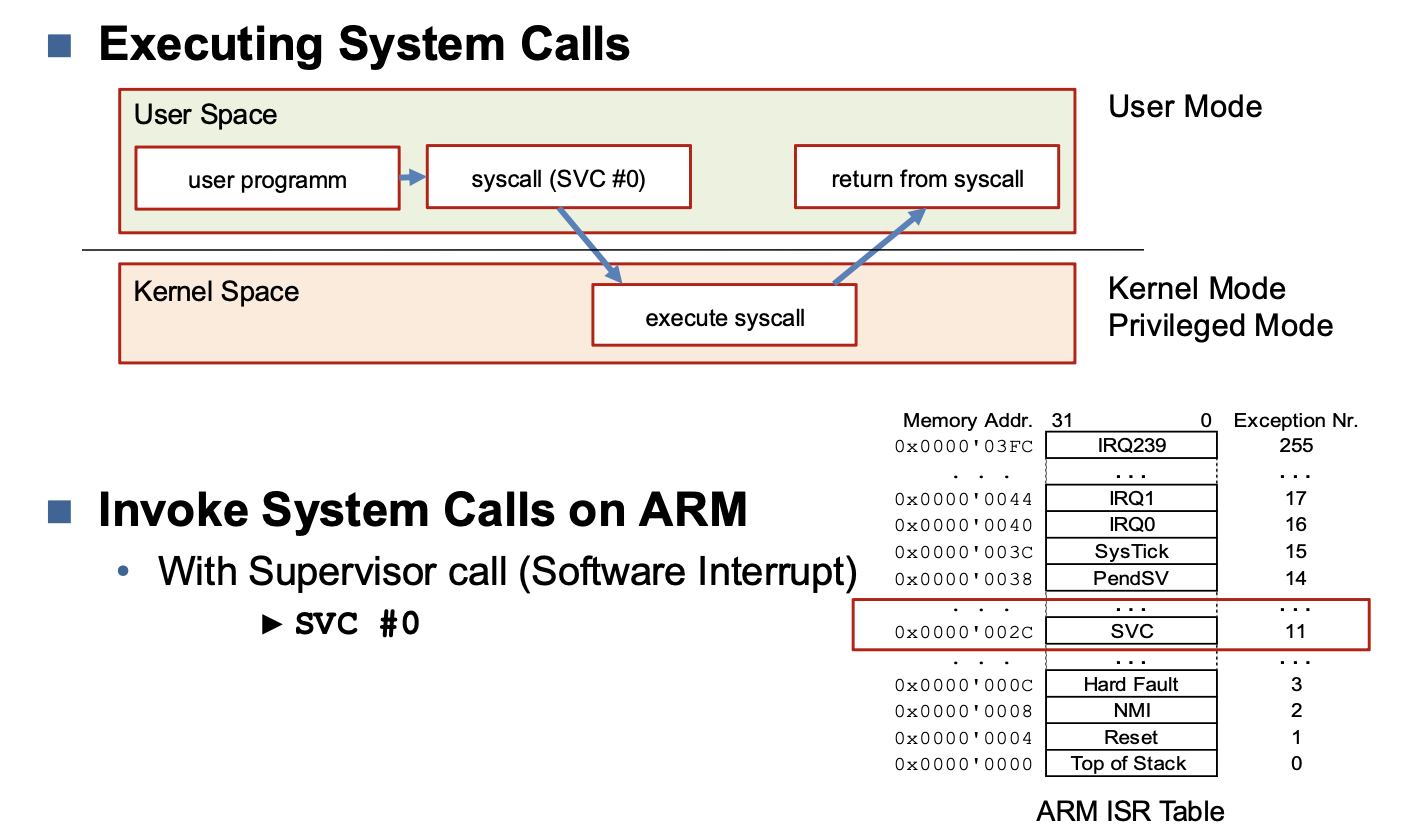

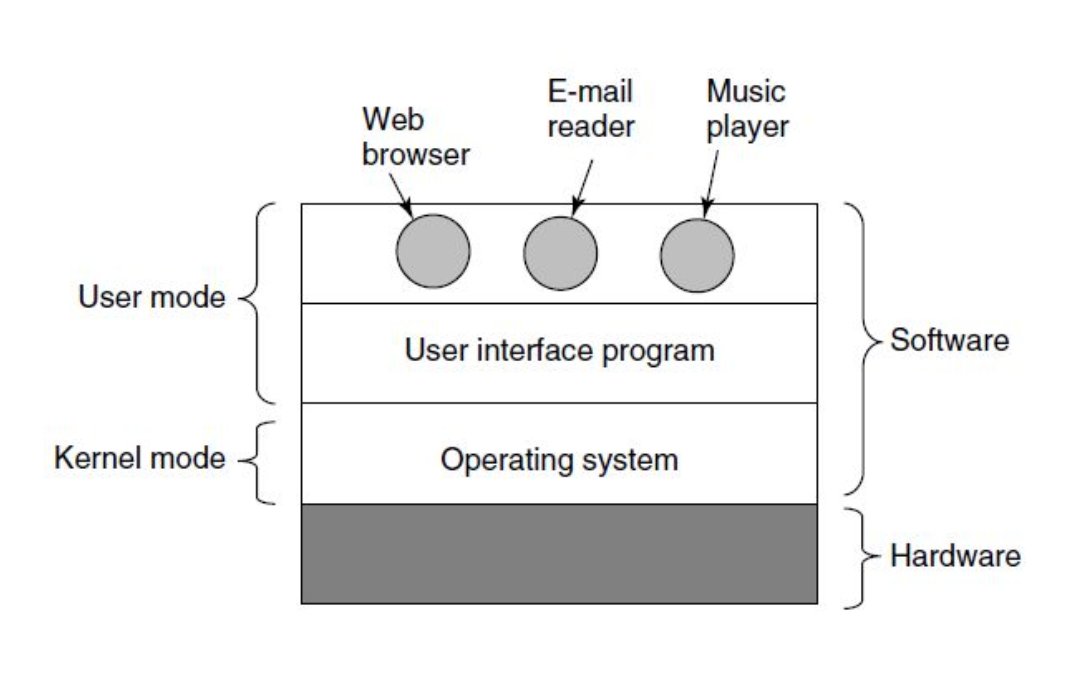

Kernel Mode (Privileged Mode)

- Complete and unrestricted access to underlying hardware

- Can execute any CPU instruction and access any memory address

- Kernel mode is reserved for the lowest-level most trusted functions of the operating system

- crashes in kernel mode also crash the system

User Mode

- No ability to directly access hardware or reference memory

- access to hardware or memory delegated through system calls

- crashes in user mode are recoverable

- most of the code should be executed in user mode

Executing system calls

Embedded Linux

- Smallest possible linux

- Some open source addons

Key Advantages

- Ability to re-use componentes

- Many components exist already

- No-one should re-develop yet another operation system kernel, TCP/IP stack, USB stack or another graphical tooklit value

-> Focus on the added value of the product

Build system

- Adds dependencies to a minimal kernel

- Automatic creation of linux systems

- Repeatability

Yocto

- Build system

- Allows creation custom linux embedded distributions

Layers

bblayers.conf

BBLAYERS ?= " \

/home/mc2/poky-mickledore/meta \

/home/mc2/poky-mickledore/meta-poky \

/home/mc2/poky-mickledore/meta-yocto-bsp \

/home/mc2/rpi64/meta-openembedded/meta-oe \

/home/mc2/rpi64/meta-raspberrypi \

/home/mc2/rpi64/meta-mc2 \

/home/mc2/rpi64/meta-student \

"

| Symbol | Description |

|---|---|

| = | when using the variable, value is expand |

| := | immediately expand the value |

| ?= | assign if no other value was previously assigned |

| ??= | same as previous, with a lower precedence |

Linking

Static linking

- Linker holt aus der library alle Dateien, die benötigt werden

- Library ist nicht notwendig

- Kann nicht kopiert werden

Dynamic linking

- dll unter windnows, .so unter linux

Linux Licenses

GNU General Public License

General “Four Freedoms”:

0. The freedom to run the program, for any purpose.

- The freedom to study how the program works, and modify it so it does your computing as you wish.

- The freedom to redistribute copies so you can help your others.

- The freedom to distribute copies of your modified versions to others.

Condition

- The source code needs to be available!

GNU is a recursive acronym: "GNU's Not Unix!"

- GPL a copyleft license:

→ Changes have to be released under the same license - Programs linked with a library released under the GPL must also be released under the GPL

Linux Kernel sources are Free Software released under the GNU General Public License version 2 (GPLv2).

=>

- When you receive or buy a device with Linux on it, you must

→ receive the Linux sources, with the

→ right to study, modify and redistribute them. - When you produce Linux based devices, you must

→ release the sources to the recipient, with the same rights, with no restriction.

GPL Redistribution

Providing source code?

- If software isn't distributed -> no need to provide source code

=> Modification can be kept secret until delivery - If software is distributed -> following options:

- Release binary with

a) copy of the source on a physical medium

b) with the network address of a location pointing to source code

c) with a written offer valid for 3 years that indicates how to fetch the source code

- Release binary with

If you don’t want to provide Source Code, compile with LGPL (Lesser GPL)

Lesser General Public License

- LGPL also a copyleft license:

→ Changes have to be released under the same license

Programs linked against a library under the LGPL do not need to be released under the LGPL and can be kept proprietary.

User must keep the ability to update the library independently from the program.

→ Dynamic linking is the easiest solution.

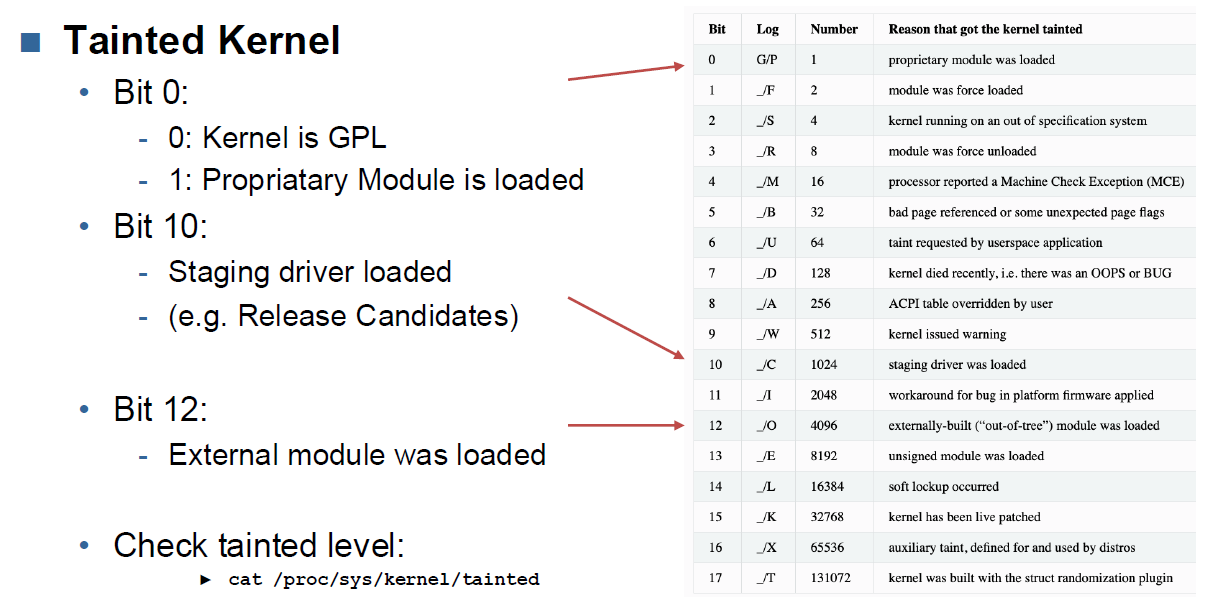

Tainted Kernel

MODULE_LICENSE: If this macro is not set to some sort of GPL license tag, then the kernel will become “tainted” when you load your module.

Tainted Status

- G: All modules loaded were licensed under the GPL or a license compatible with the GPL.

- P: The kernel has a proprietary license loaded. (Module or Kernel)

Decode tainted level on Bitlevel:

for i in $(seq 18); do echo $(($i-1)) $(($(cat /proc/sys/kernel/tainted)>>($i-1)&1));done

Permissive Licenses

MIT and BSD:

Common for both: “Permitted to do whatever the user wants without any

legal obligation to the owner.”

- Permits use

- Permits redistribution

- Permits redistribution with modification

- Provision to retain the copyright notice and warranty disclaimer

- Not required that source code is distributed

- Only requirement: Include a copy of the license

In addition, the MIT license also explicitly allows:

- merging

- publishing

- sublicensing

- selling

Mozilla Public License

- Development of the Netscape Public License which was created with the publication of the Netscape source code in 1998.

- Copyleft license: It grants liberal copyright and patent licenses allowing for free use, modification, distribution, and exploitation of the work

- Modifications of MPL code must again be MPL

Comparison of open licenses

https://choosealicense.com/licenses/

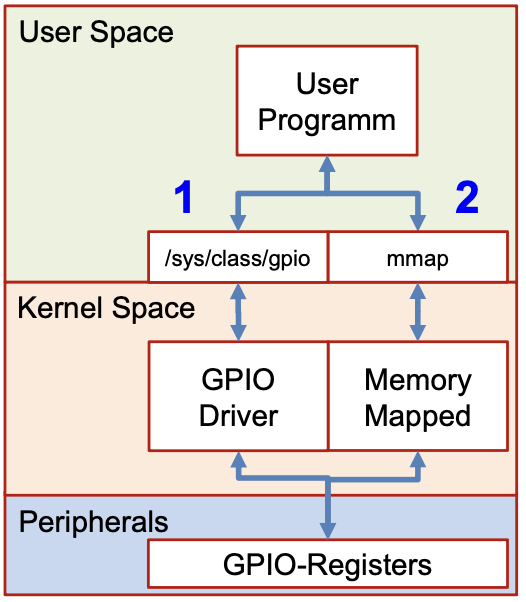

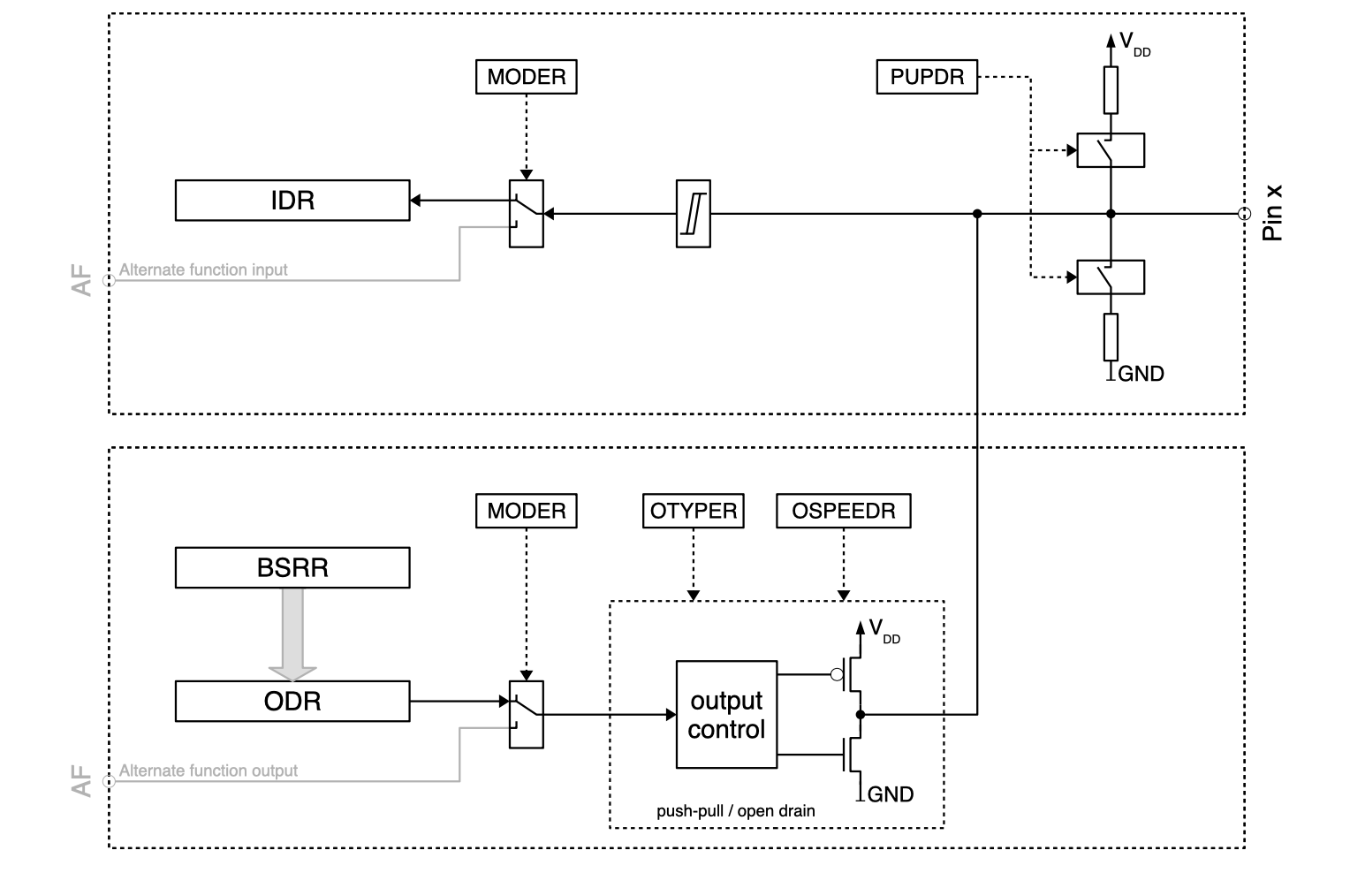

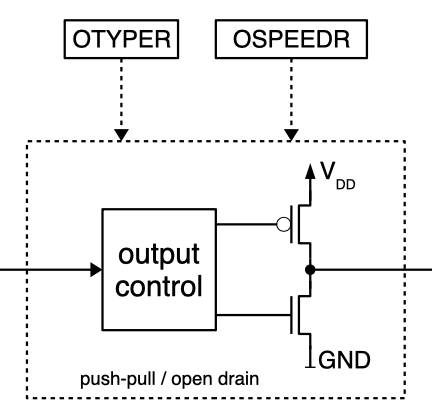

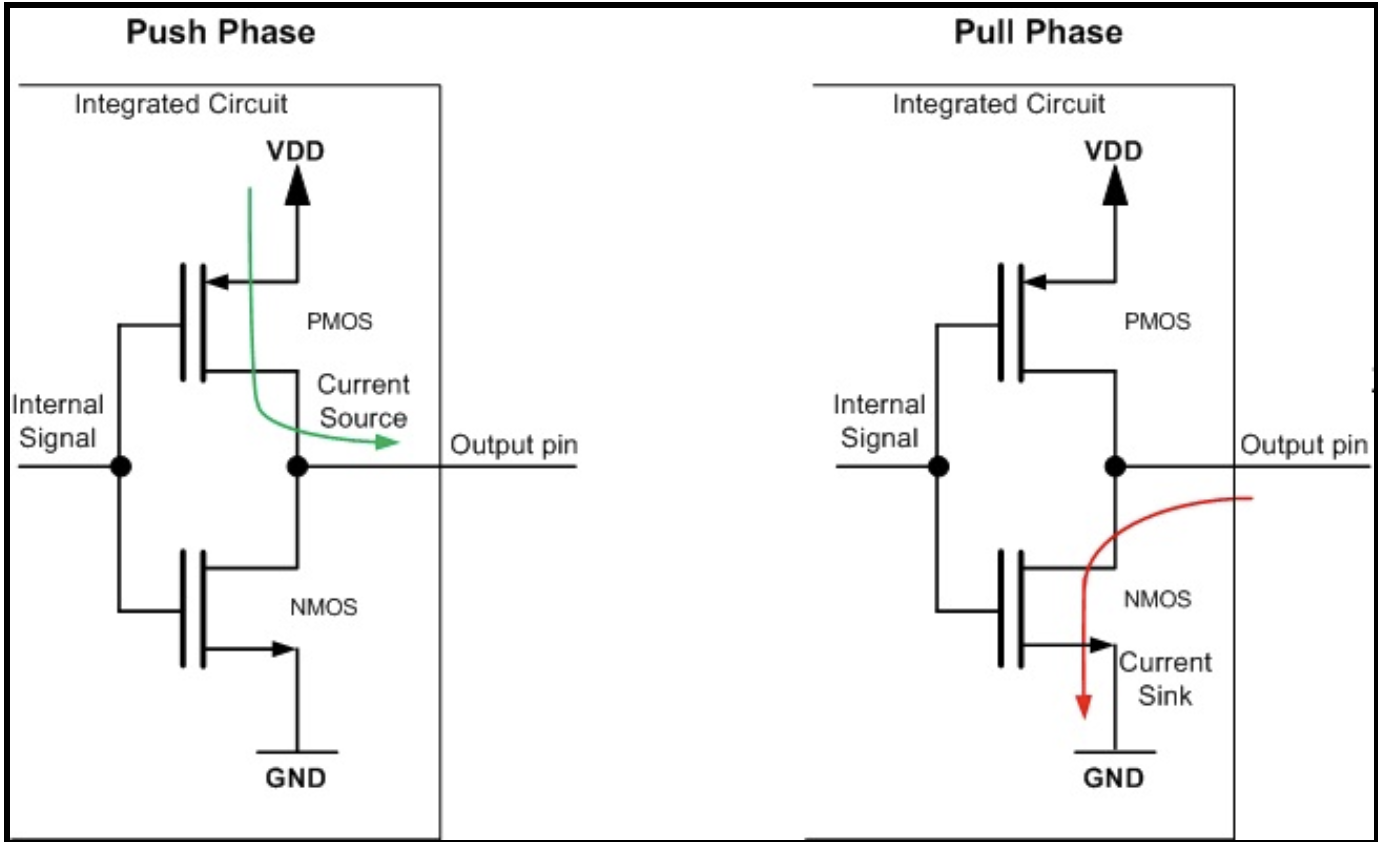

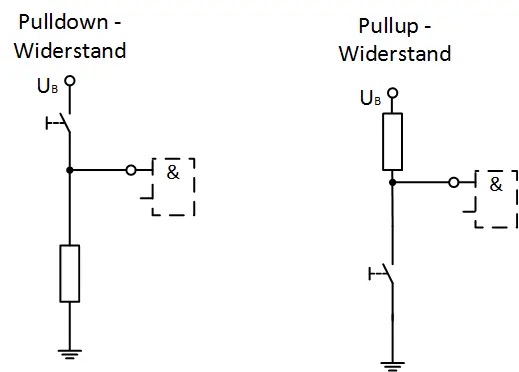

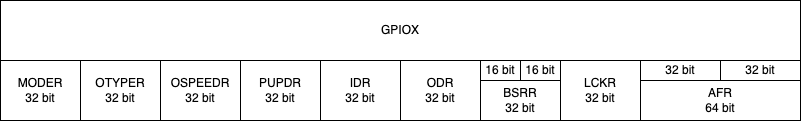

GPIO

A GPIO may have multiple functions. The active function can be selected using the GPFSEL register.

Base Address>: 0x7e20'0000

Can be found in the PDF on section 5.2 (Register View)

Register

| Register | Anwendung | Bits |

|---|---|---|

| GPFSEL | Function selection for GPIO | 3 |

| GPSET | Set Value for GPIO | 1 |

| GPCLR | Clear Value for GPIO (Set to 0x00) | 1 |

| GPLEV | Read Pin Level | 1 |

Access

Kommandozeilen Befehl um die GPIOChip Nummern für Zugriff über pseudo Filesystem

ls gpiochip*/device/driver

Pseudo Filesystem

GPIO can be accessed using the pseudo file system mapped at "/sys/class/gpio"

- Requires driver for GPIO

- Portable to other HW, works everywere

- Less hassle with addressses

Enable GPIO

echo <gpio-pin> > /sys/class/gpio/export

Set Direction of GPIO

| Direction | Value to Write |

|---|---|

| Read pin | in |

| set pin | out |

XX => GPIO-PIN-Number

echo "direction" >> /sys/class/gpio/gpioXX/direction

Value of GPIO

| State | Value to Write |

|---|---|

| HIGH | 1 |

| LOW | 0 |

Set Value

echo "1" >> /sys/class/gpio/gpioXX/value

Read Value

cat /sys/class/gpio/gpioXX/value

C-Code

Export GPIO

FILE *fp;

fp = fopen("/sys/class/gpio/export", "w");

if (fp == NULL) {

printf("Error opening file in gpio_init %s\n", str);

return 1;

}

fprintf(fp, "%i", gpio);

fflush(fp);

fclose(fp);

Set Value

void fs_gpio_set (int gpio, int val)

{

FILE *fp;

char str[100];

sprintf(str, "/sys/class/gpio/gpio%i/value", gpio);

fp = fopen(str, "w");

if (fp== NULL) {

printf("Error opening file in gpio_set %s\n", str);

return -1;

}

fprintf(fp, "%i", val);

fflush(fp);

fclose(fp);

}

Read Value

int fs_gpio_get (int gpio)

{

FILE *fp;

char str[100];

int ret;

sprintf(str, "/sys/class/gpio/gpio%i/value", gpio);

fp = fopen(str, "r");

if (fp == NULL) {

printf("Error opening file in gpio_read %s\n", str);

return -1;

}

fread(str, 101, 1, fp);

sscanf(str, "%i", &ret);

fclose(fp);

return ret;

}

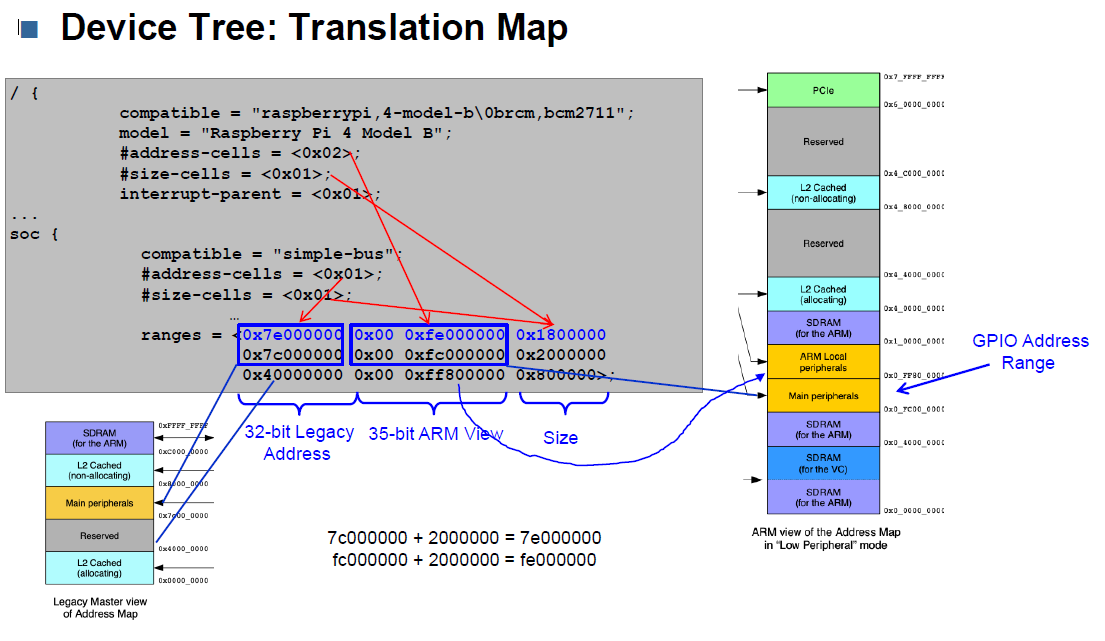

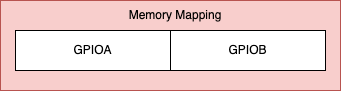

Memory Mapped

When using Memory Mapped / DMA (Direct Memory Access), the gpio location must be translated to the memory address.

The Physical Address is 35bit!

void *virtual_gpio_base; //define global pointer

int mmap_virtual_base()

{

int m_mfd;

if ((m_mfd = open("/dev/mem", O_RDWR)) < 0)

{

printf("FAIL by open /dev/mem\n");

return m_mfd;

}

virtual_gpio_base = (void*) mmap(NULL, sysconf(_SC_PAGE_SIZE),

PROT_READ|PROT_WRITE, MAP_SHARED, m_mfd, GPIO_BASE_ADDR);

close(m_mfd);

if (virtual_gpio_base == MAP_FAILED) {

return errno;

}

return 0;

}

Setting and clearing of single gpio pins

#define GPIO_SET0 (0x0000001c) // GPIOSET0 offset

#define GPIO_CLR0 (0x00000028) // GPIOCLR0 offset

void *virtual_gpio_base; //define global pointer

static void mmap_gpio_set(int gpio, int value)

{

uint32_t *gpio_reg;

if (value == 1){

gpio_reg = (uint32_t *) (virtual_gpio_base + GPIO_SET0);

}

else {

gpio_reg = (uint32_t *) (virtual_gpio_base + GPIO_CLR0);

}

*gpio_reg = (0x1 << gpio);

}

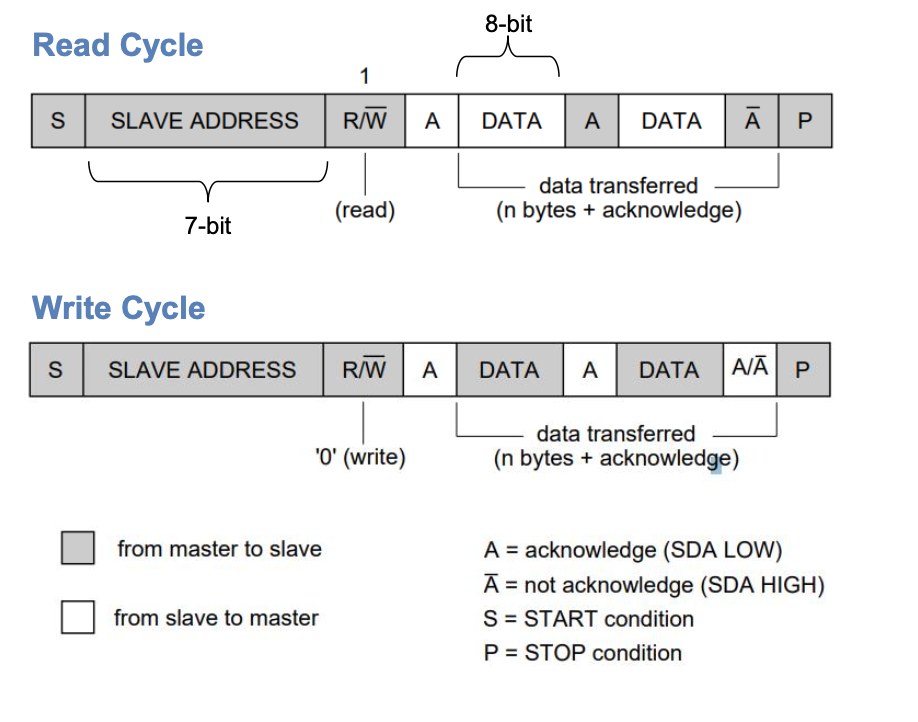

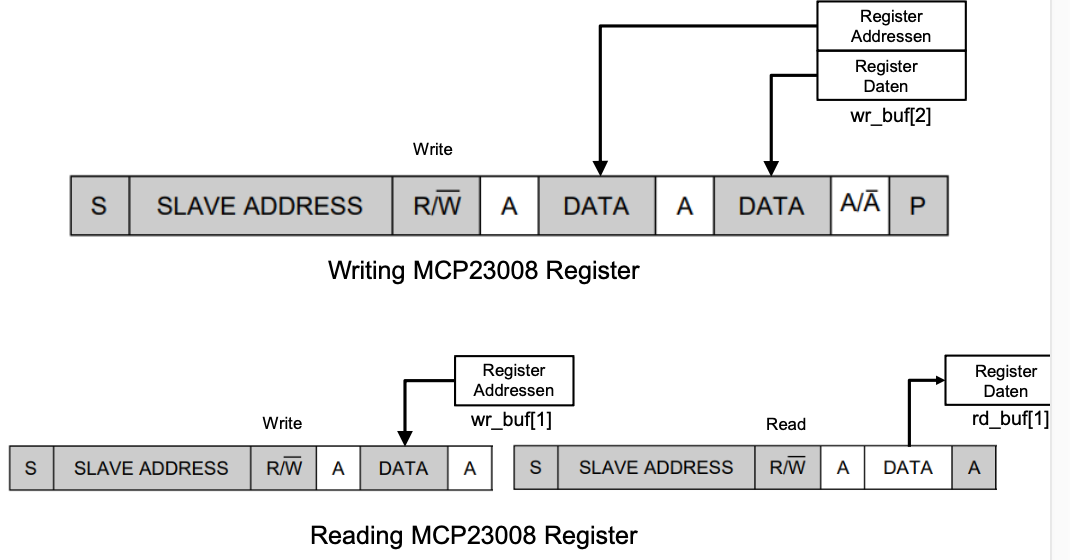

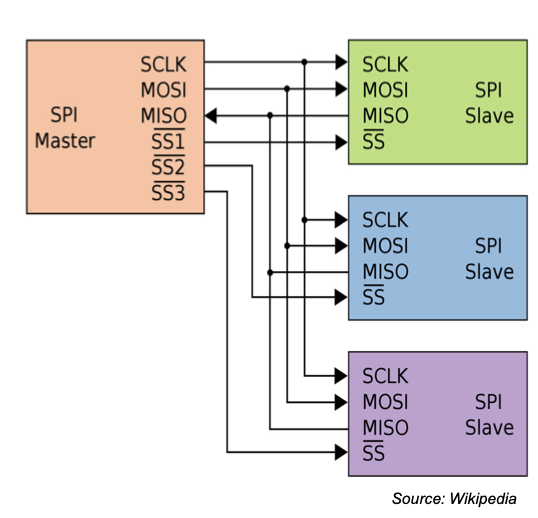

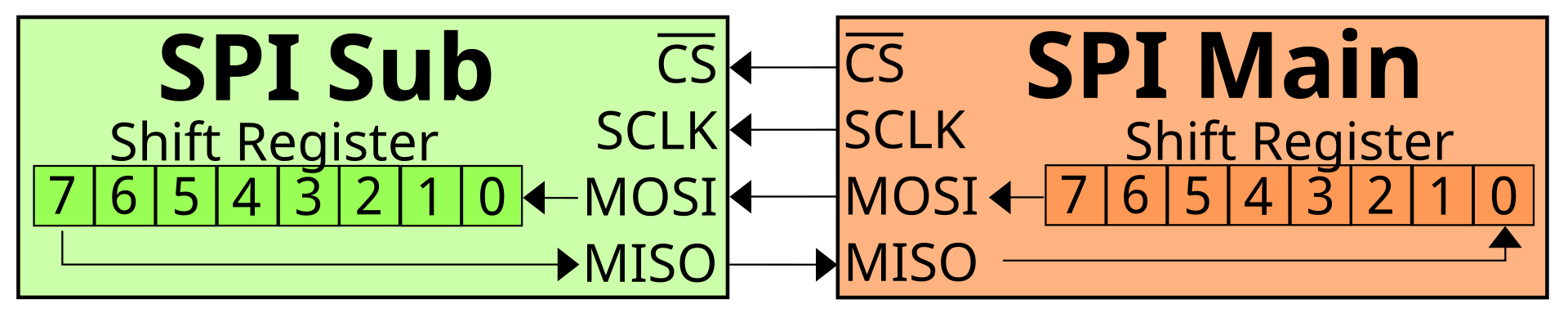

I2C

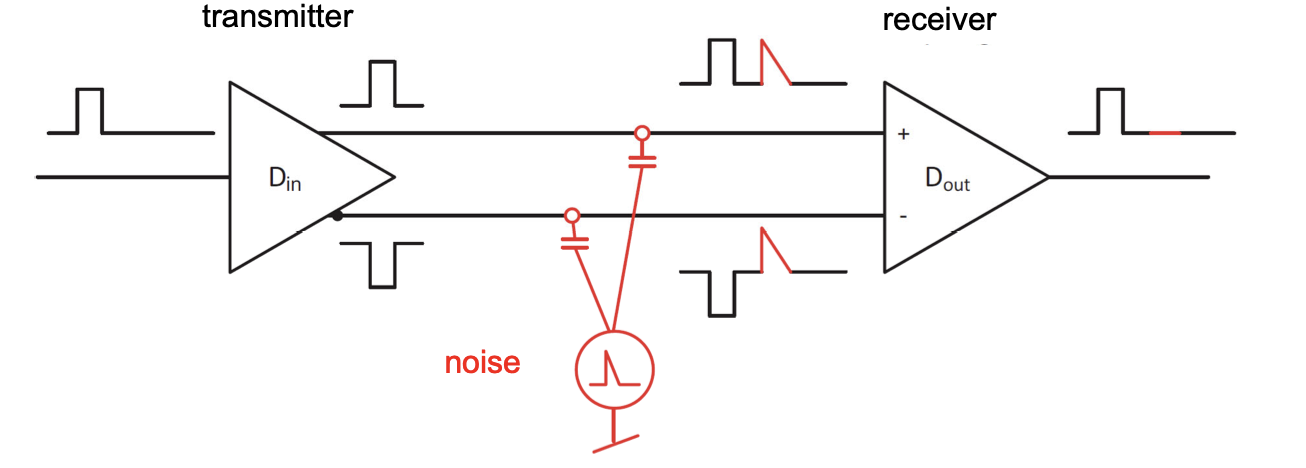

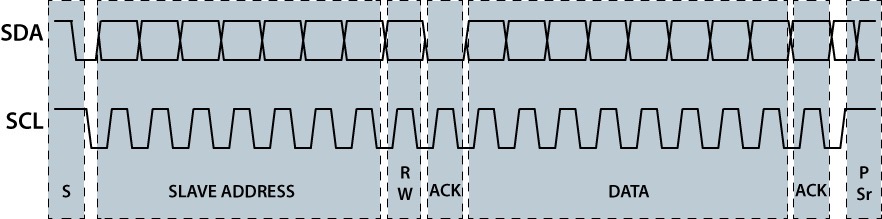

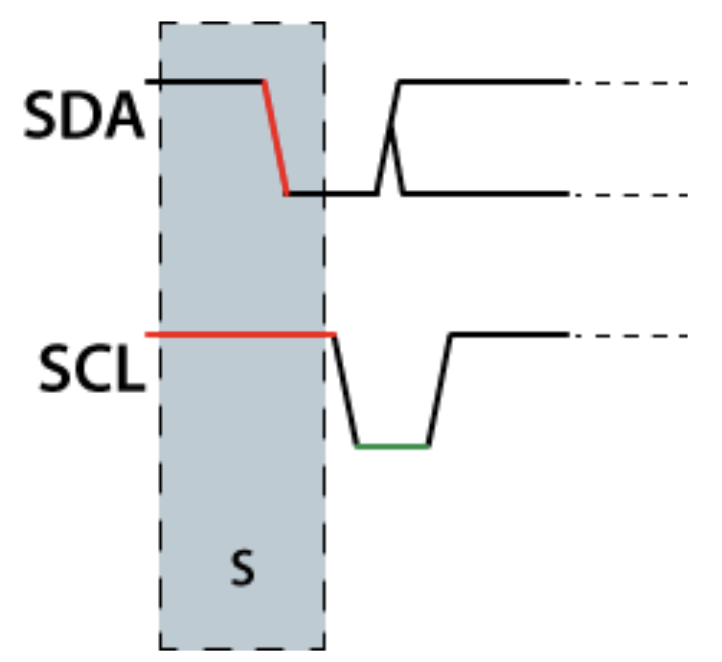

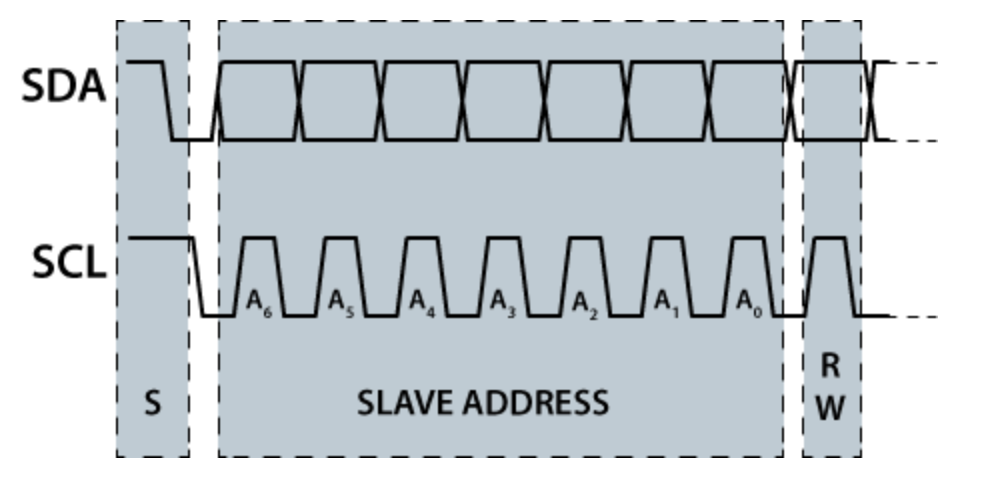

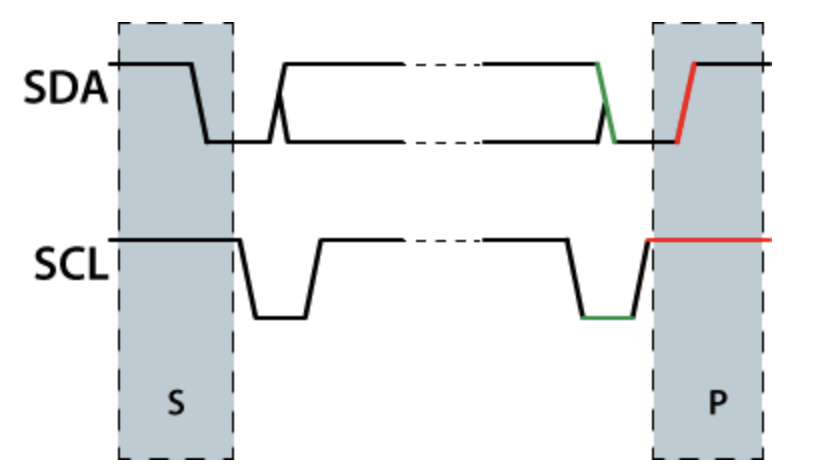

Read / Write Cycle

Writing / Reading Data

-

For more details checkout CT2 I2C

-

Only one driver can open the bus

#include <linux/i2c-dev.h>

#include <sys/ioctl.h>

int fd;

char *filename = "/dev/i2c-1";

if ((fd = open(filename, O_RDWR)) < 0) {

/* ERROR HANDLING: you can check errno to see what went wrong */

perror("Failed to open the i2c bus");

exit(1);

}

// Sets up the I2C controller with I2C-bus mode and I2C slave address

int addr = 0x20;

if ( ioctl(fd, I2C_SLAVE, addr ) < 0) {

printf("Failed to acquire I2C bus access and/or talk to slave.\n");

exit(1);

}

// WRITE

uint8_t wr_buf[2];

wr_buf[0] = register_address;

wr_buf[1] = register_data;

if ( write(fd, wr_buf, 2) != 2 ) {

printf("Failed to write to the i2c bus.\n");

}

//READ

uint8_t data = 0;

uint8_t wr_buf[1];

uint8_t rd_buf[1];

wr_buf[0] = register_addr;

if ( write(fd, wr_buf, 1) != 1 ) {

printf("Failed to write to the i2c bus.\n");

}

if ( read(fd, rd_buf, 1) != 1 ) {

printf("Failed to read from the i2c bus.\n");

} else {

data = rd_buf[0];

}

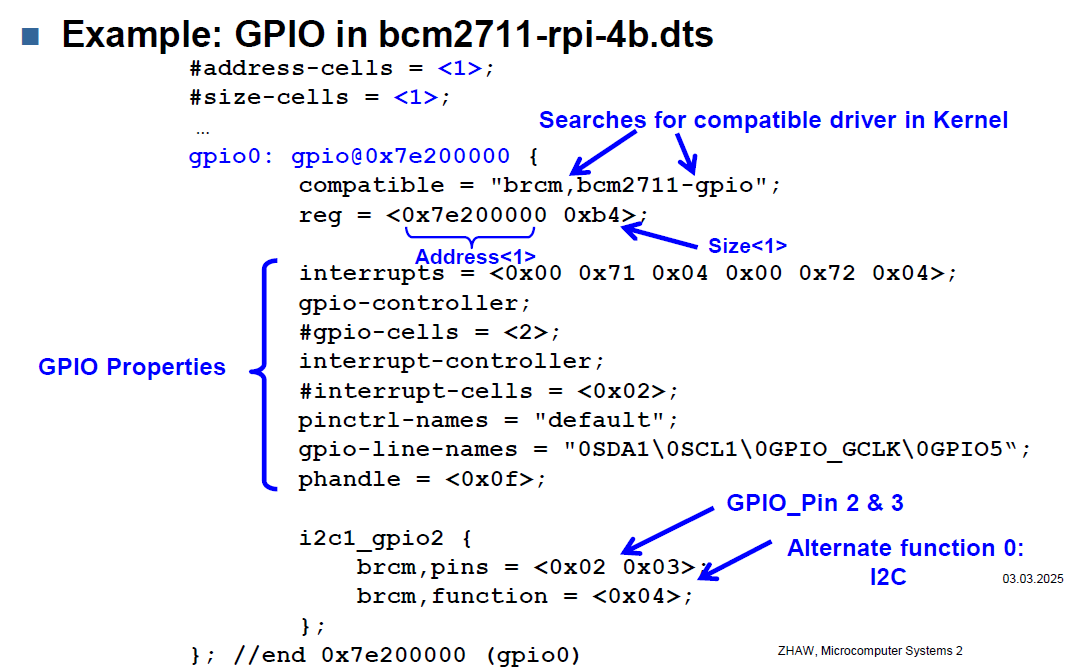

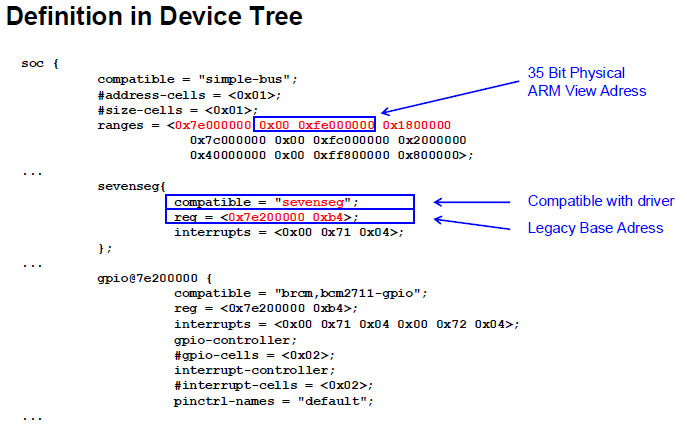

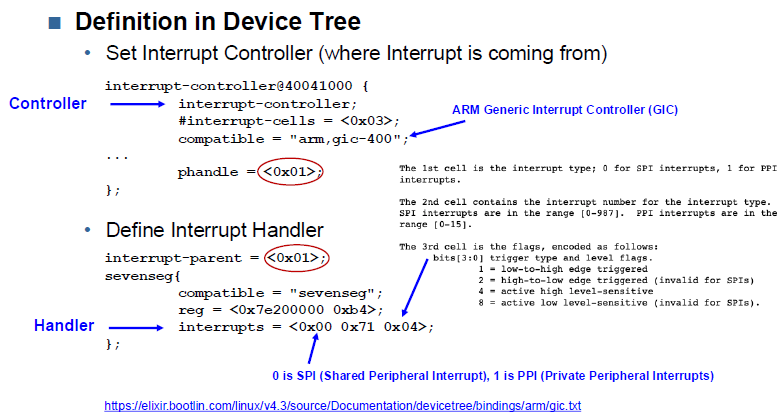

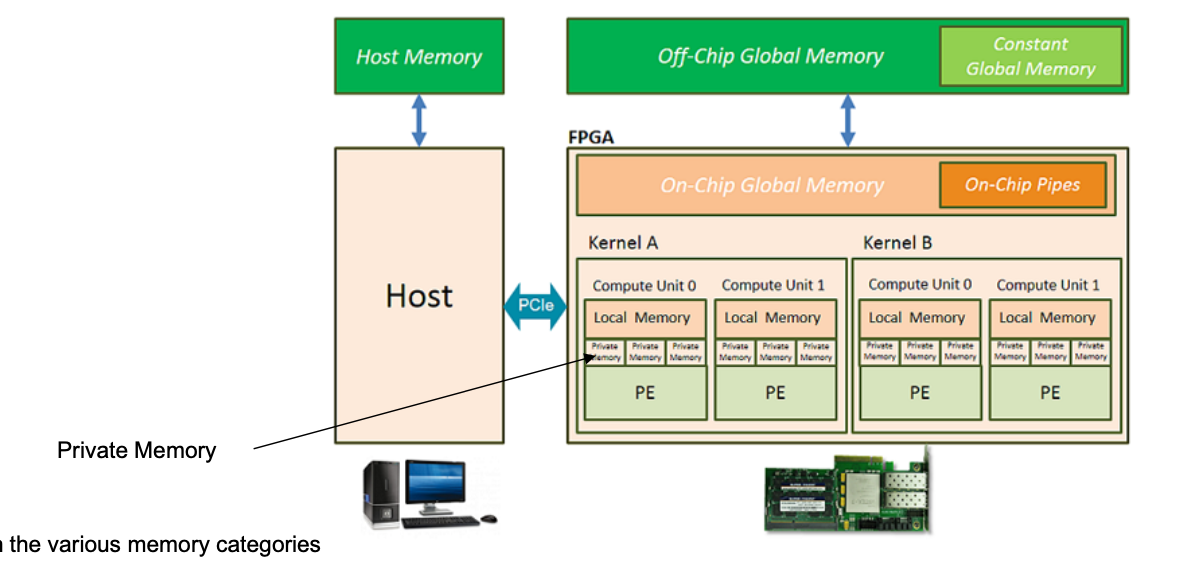

Device Tree

Purpose

- Informs the Linux about the hardware

- At which (physical) addresses memory blocks are found and their size

- The address where the registers of the peripherals are and the range

- Where the interrupts of the peripherals are connected to

- Where the GPIO or peripherals pins are connected to the outside

- What alternate functions must be selected to connect the peripheral

- Which driver has to be loaded for which peripheral

- Enabling the driver

Mechanism

- Device Tree is parsed

- Compatible Driver in Kernel is searched and started

- Driver gets additional properties from Device Tree

{

node@ {

a-string-property = "A string";

a-string-list-property = "first string", "second string";

a-byte-data-property = [0x01 0x23 0x34 0x56]

child-node@ {

first-child-property;

second-child-property = <1>;

a-reference-to-something = <&node1>;

};

child-node@1 {

};

};

node1: node@1 {

an-empty-property;

a-cell-property = <1 2 3 4>;

child-node@0 {

};

};

};

Is ARM or Legacy?

| Bit count | |

|---|---|

| 32 bit | legacy |

| 35 bit | arm |

def hex_to_bits(hex_num): # Convert the hex number to an integer decimal_num = int(hex_num, 16) # Convert the integer to binary and remove the "0b" prefix binary_num = bin(decimal_num)[2:] # Return the binary number (padded to 4 bits for each hex digit if needed) return binary_num.zfill(len(hex_num) * 4) # Example usage hex_num = "0x7e804000" hex_num = hex_num.replace('0x', '') binary_rep = hex_to_bits(hex_num) print(f"Hex: {hex_num} -> Bits: {len(binary_rep)}") if len(binary_rep) == 32: print ("LEGACY") else: print ("ARM")

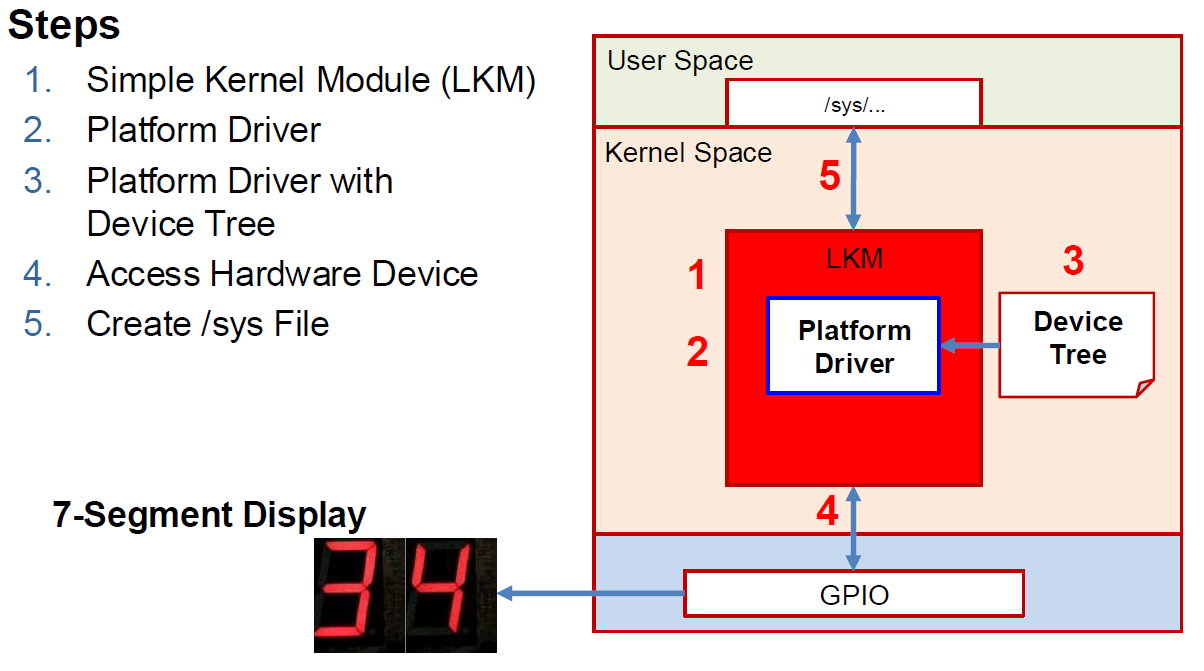

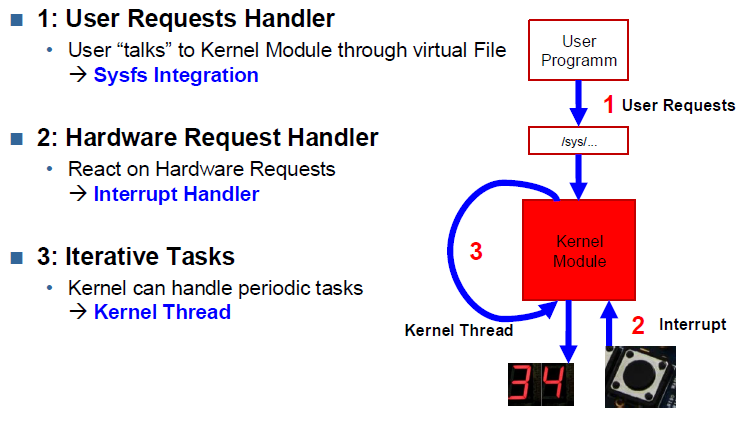

Kernel Modules

Basics:

- A programming module with interfaces

- Communication Medium between application/user and hardware → lives in Kernel Space + used for hardware access with minimal functionality

- can be hot loaded/unloaded - only possible with

rootprivileges → actual name "Loadable Kernel Module" - Gateway to User Space through File Interface with a virtual File (

/sys/..)

Types:

- Device Drivers

- Filesystem Drivers

- Network Drivers

LKM Utilities Commands:

# Insert an LKM into the kernel

sudo insmod <module.ko>

# Remove an LKM from the kernel

sudo rmmod <module>

# List currently loaded LKMs

sudo lsmod

# Display information of LKM object file

sudo modinfo <module.ko>

# Insert or remove an LKM, when in /lib/modules

sudo modprobe

Discoverable Hardware

- PCI/USB devices are discoverable.

- When connecting a device to a bus, it receives a unique identification used for communication with the CPU.

- PCI/USB devices tell the system what sort of device they are

Non-discoverable Hardware

- Simple Interfaces (I2c or SPI) are not discoverable

- Such hardware has to be explicitly defined → in Device Tree

- Kernel Modules communicating with the Device Tree are called → Platform Drivers

Concept

1. Simple LKM

Minimal viable LKM:

#include <linux/kernel.h>

#include <linux/module.h>

// init function

static int __init my_module_init(void) {

...

}

// exit function

static void __exit my_module_exit(void) {

...

}

/*

* The next calls are mandatory -- they identify the initialization

* and the cleanup function (as above).

*/

module_init(my_module_init);

module_exit(my_module_exit);

/* Kernel module description */

MODULE_LICENSE("GPL");

MODULE_AUTHOR("Vladimir Lenin");

MODULE_DESCRIPTION("A desc.");

MODULE_VERSION("1.0");

C does not have namespace-functionality → naming conflicts/pollition possible

Avoid Kernel namespace pollution: always use static for global vars. to give it file internal linkage

2. Platform Driver

- Defines a data structure that keeps track of device state.

- Implements a set of helper functions, interrupt handlers, etc.

- Defines a

probe()method - Similarly defines a corresponding

remove()method - Registersthe device to the Kernel in the

__initmethod - Similarly unregisters the device in the

__exitmethod

Probe:

Input: a structure describing the device:

int driver_probe(struct platform_driver *pdev)

- Initializes device

- Maps I/O memory

- Registers Interrupt Handlers

- Starts Kernel Threads

- Registers device to proper kernel framework

Remove

Input: a structure describing the device:

int driver_remove(struct platform_driver *pdev)

- No general responsibilities → open to implementation

Registration

Put everything together with LKM:

- define

probeandremovefunctions - declare them in Platform Driver Definition

- Un-/Register Platform Driver Definition using

__exitand__initmethods

#include <linux/platform_device.h>

#include <linux/mod_devicetable.h>

// Example struct device desc.

struct platform_driver {

int (*probe) (structplatform_device *);

int (*remove) (structplatform_device *);

void (*shutdown) (structplatform_device *);

int( *suspend) (structplatform_device *, pm_message_tstate);

int (*resume) (structplatform_device *);

struct device_driverdriver;

const struct platform_device_id *id_table;

};

// Initialization Platform Driver Definition

static struct platform_driver sevenseg_driver = {

.driver = {.name = "sevenseg",

.owner = THIS_MODULE,

.of_match_table = sevenseg_device_tree_ids, // see point "3. Platform Driver with Device Tree"

},

.probe = sevenseg_probe, // Declare probe function

.remove = sevenseg_remove // Declare remove function

};

static int sevenseg_probe(struct platform_device *pdev) {

...

}

static int sevenseg_remove(struct platform_device *pdev) {

...

}

// registration

static int __init sevenseg_init(void) {

platform_driver_register(&sevenseg_driver);

return 0;

}

static void __exit sevenseg_exit(void) {

platform_driver_unregister(&sevenseg_driver);

}

3. Platform Driver with Device Tree

Platform Driver has to be linked somehow to the correct device node in the Device Tree

In Device Tree:

sevenseg {

compatible = "sevenseg"; //<---- searched string

}

In Platform Driver:

...

static const struct of_device_id sevenseg_device_tree_ids[] = {

{

.compatible = "sevenseg",

},

{}};

MODULE_DEVICE_TABLE(of, sevenseg_device_tree_ids);

static struct platform_driver sevenseg_driver = {

.driver = {.name = "sevenseg",

.owner = THIS_MODULE,

.of_match_table = sevenseg_device_tree_ids, // <----- look here

},

.probe = sevenseg_probe, // Declare probe function

.remove = sevenseg_remove // Declare remove function

};

....

4. Access Hardware Device

- Use global data structure for information exchange between methods

- Use

probfunction to allocate memory and registerstruct

...

/*

* Type definitions and global variables for kernel module

*/

typedef struct sevenseg_platform_data {

struct device* dev;

int counter;

int mode;

void __iomem* base_addr;

int irq;

struct task_struct* kthread_sevenseg;

} sevenseg_platform_data;

...

static int sevenseg_probe(struct platform_device *pdev) {

struct sevenseg_platform_data* pdata;

...

pdata = devm_kzalloc(&pdev->dev, sizeof(pdata), GFP_KERNEL); // allocate memory

platform_set_drvdata(pdev, pdata); // register bzw. set struct as "driver data"

...

}

How to get resource and virtual address from Device Tree, implement in prob function:

static int sevenseg_probe(struct platform_device* pdev) {

struct sevenseg_platform_data* pdata;

struct resource* res;

...

res = platform_get_resource(pdev, IORESOURCE_MEM, 0); // <-------- get resource from Device Tree

if(res == NULL) {

pr_err("platform_get_resource() failed! \n");

return -1;

}

pr_info("Info: 35Bit ARM Address: 0x%x \n", res->start);

pdata->base_addr = devm_ioremap_resource(&pdev->dev, res); // <-------- get virtual address

if(IS_ERR(pdata->base_addr)) {

pr_err("Error: devm_ioremap_resource() failed! \n");

return PTR_ERR(pdata->base_addr);

}

pr_info("Info: Virtual Address: 0x%x \n", pdata->base_addr);

...

return 0;

}

Write to Peripheral: void iowrite{$X$}(u{$X$} value, void* addr);

Read from Peripheral: void ioread{$X$}(void* addr);

With {$X$} = 8 or 16 or 32

Example usage in device setup:

static int sevenseg_probe(struct platform_device* pdev) {

struct sevenseg_platform_data* pdata;

struct resource* res;

...

// Configure different GPIOs

// Setup keys as GPIO_IN

init_gpio(pdata, keys[1], GPIO_IN); // <----- uses iowrite32 & ioread32

set_trigger_gpio(pdata, keys[1], GPIO_EDGE_FALLING); // <----- uses iowrite32 & ioread32

init_gpio(pdata, keys[0], GPIO_IN); // <----- uses iowrite32 & ioread32

set_trigger_gpio(pdata, keys[0], GPIO_EDGE_FALLING); // <----- uses iowrite32 & ioread32

// Setup the two sevenseg's to GPIO_OUT

for(i = 0; i < 8; i++) {

init_gpio(pdata, sevensegs[0][i], GPIO_OUT); // <----- uses iowrite32 & ioread32

init_gpio(pdata, sevensegs[1][i], GPIO_OUT); // <----- uses iowrite32 & ioread32

}

// Initialize the sevenseg with the first number

sevenseg_write(pdata, pdata->counter); // <----- uses iowrite32

dev_info(&pdev->dev, "Info: Finished initializing sevenseg \n");

...

return 0;

}

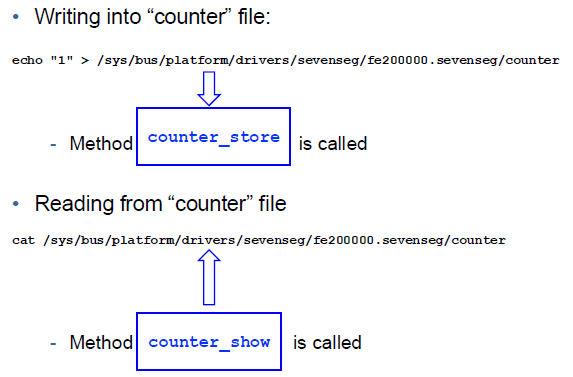

5. Create /sys File

Platform Dreiver needs to:

- provide

storeandshowfunctions - "register" their function pointers

- create virtual file in /sys that will be writen to/read from → in

probeandremovefunctions

- and 2.

// user writes to file "counter"

static ssize_t counter_store(struct device* dev,

struct device_attribute* attr,

const char* buf,

size_t count) {

...

}

// user reads from file "counter"

static ssize_t counter_show(struct device* dev,

struct device_attribute* attr,

char* buf) {

...

}

// Macro to define counter and show/store Function

DEVICE_ATTR(counter, 0644, counter_show, counter_store);

Location of „File“: /sys/bus/platform/drivers/sevenseg/fe200000.sevenseg/counter

static int sevenseg_probe(struct platform_device* pdev) {

struct sevenseg_platform_data* pdata;

struct resource* res;

...

// Create File "counter"

ret = device_create_file(&pdev->dev, &dev_attr_counter); //<----- create

if(ret != 0) {

pr_err("device_create_file() failed with: %d() \n", ret);

return -1;

}

...

return 0;

}

static int sevenseg_remove(struct platform_device* pdev) {

struct sevenseg_platform_data* pdata = platform_get_drvdata(pdev);

device_remove_file(&pdev->dev, &dev_attr_counter); //<----- remove

kthread_stop(pdata->kthread_sevenseg);

return 0;

}

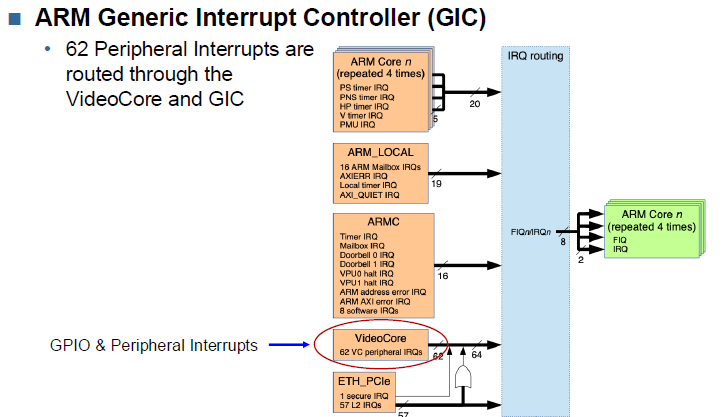

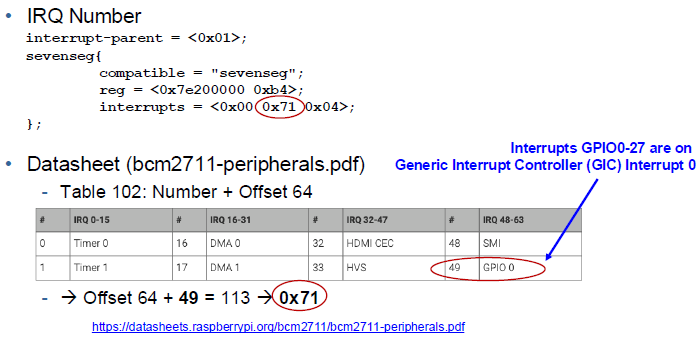

Interrupts

Device Tree Interrupt Definition:

Interupt Controler: Interupt Handling Device

<------Device Tree------>

HW that "initiates" interrupt Hardware that "reacts" to interupt → i.e. where ISR is implemented

Definition in Device Tree:

Code Example

static irqreturn_t irq_handler(int this_irq, void* data) {

... // interrupt logic here

// clear Interrupt

iowrite32(0x1 << keys[1], pdata->base_addr + GPEDSX_OFFSET(keys[1]));

iowrite32(0x1 << keys[0], pdata->base_addr + GPEDSX_OFFSET(keys[0]));

// ^ GPIO Pin Event Detect Status Register

return IRQ_HANDLED;

}

static int sevenseg_probe(struct platform_device* pdev) {

...

pdata->irq = irq_of_parse_and_map(pdata->dev->of_node, 0); // <------ Parse Device Tree for Interrupt

if(pdata->irq != 0) {

if(devm_request_irq(pdata->dev, pdata->irq, irq_handler,

IRQF_TRIGGER_NONE, "sevenseg", pdata)) { // <------ Register Interrupt Handler

pr_err("Error: Could not request IRQ\n");

return -ENODEV;

}

}

...

return 0;

}

Interrupt Handler using GIC

static void set_trigger_gpio(struct sevenseg_platform_data *pdata,

int gpio, int mode) {

switch(mode) {

case GPIO_EDGE_FALLING:

offset = GPFENX_OFFSET(gpio);

break;

}

...

rdval = ioread32(pdata->base_addr + offset);

rdval |= (0x1 << gpio);

iowrite32(rdval, pdata->base_addr + offset);

}

static int sevenseg_probe(struct platform_device *pdev) {

....

// Initialize GPIO and set trigger

init_gpio(pdata, keys[1], GPIO_IN);

set_trigger_gpio(pdata, keys[1], GPIO_EDGE_FALLING);

return 0;

}

Threads

kthread_run(threadfn, data, namefmt);

Create a new thread and run it

- Threadfn: Function name to run

- Data: Pointer to function arguments, given when started

- Namefmt: The name of the thread (visible in ps)

- Returns a task_struct

kthread_should_stop(); // Check, if thread needs to stop

kthread_stop(struct task_struct *thread); // stops thread

Example from out sevenseg implementation:

static int thread_fn(void* data) {

struct sevenseg_platform_data* pdata = (struct sevenseg_platform_data*)data;

int i = 0;

pr_info("Info: Thread entered\n");

while(!kthread_should_stop()) {

if(pdata->mode == COUNTING) {

pdata->counter = pdata->counter == 0 ? 99 : --pdata->counter;

}

sevenseg_write(pdata, pdata->counter);

msleep(500);

}

return 0;

}

static int sevenseg_probe(struct platform_device *pdev) {

....

pdata->kthread_sevenseg = kthread_run(thread_fn, pdata, "kthread_7seg");

return 0;

}

static int sevenseg_remove(struct platform_device* pdev) {

....

kthread_stop(pdata->kthread_sevenseg);

return 0;

}

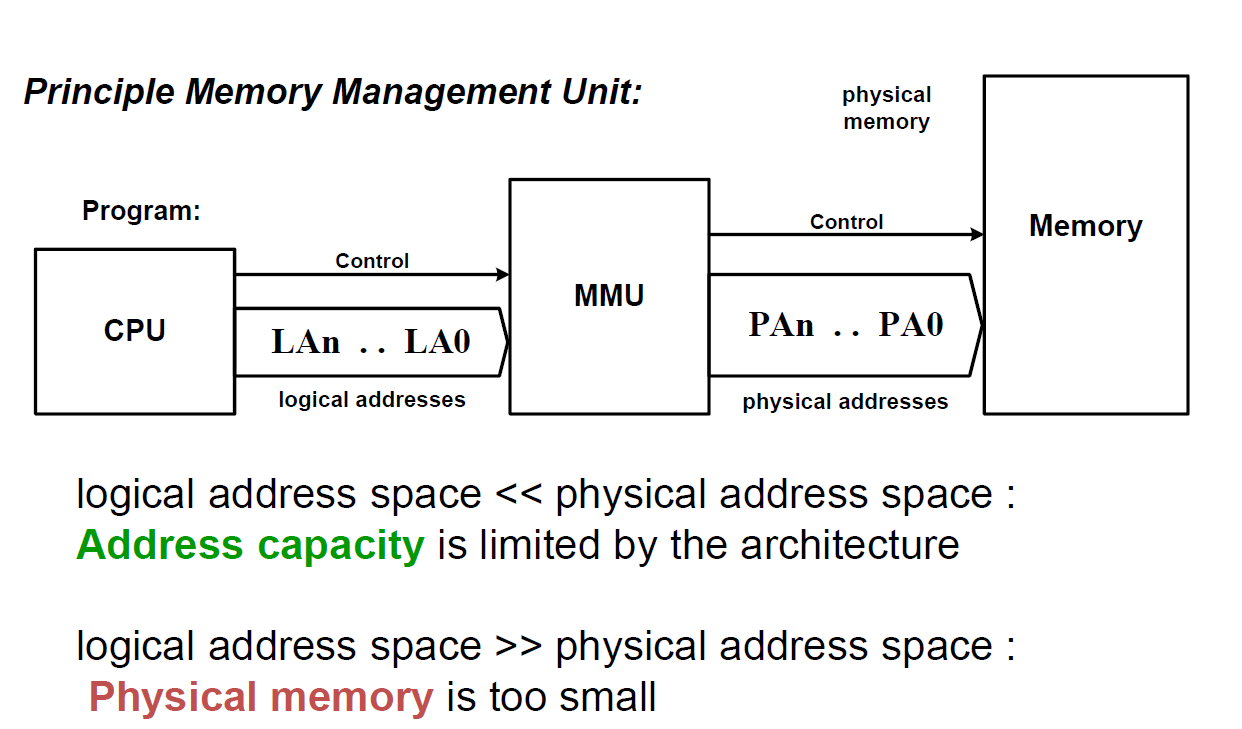

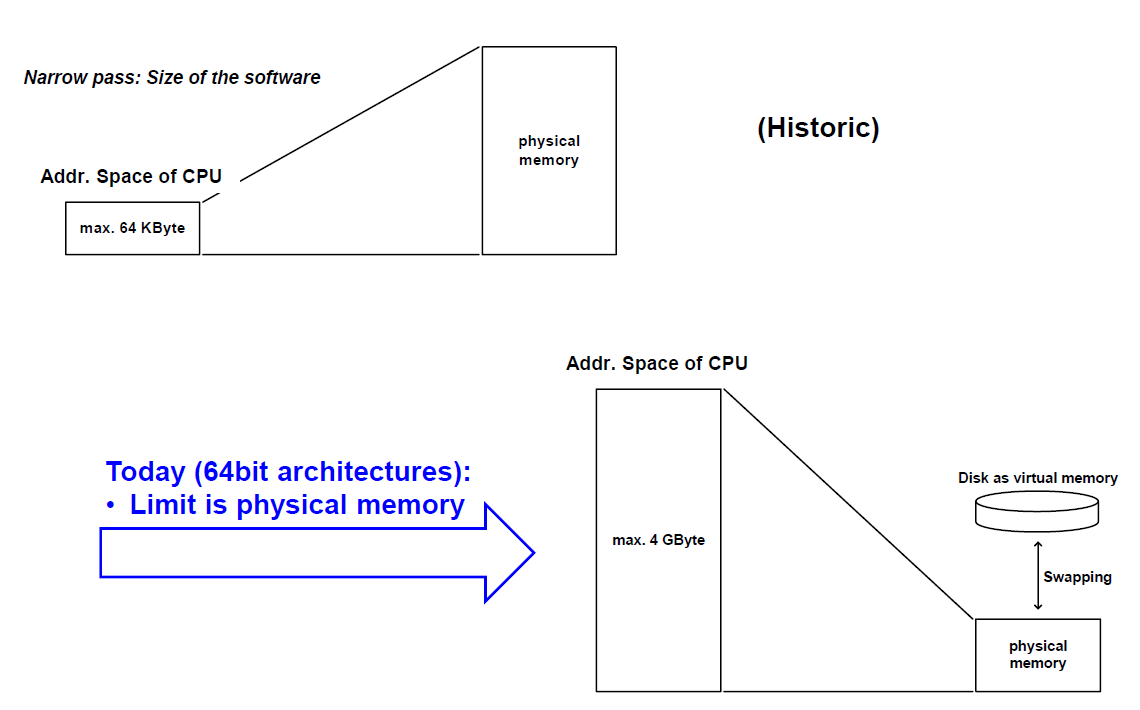

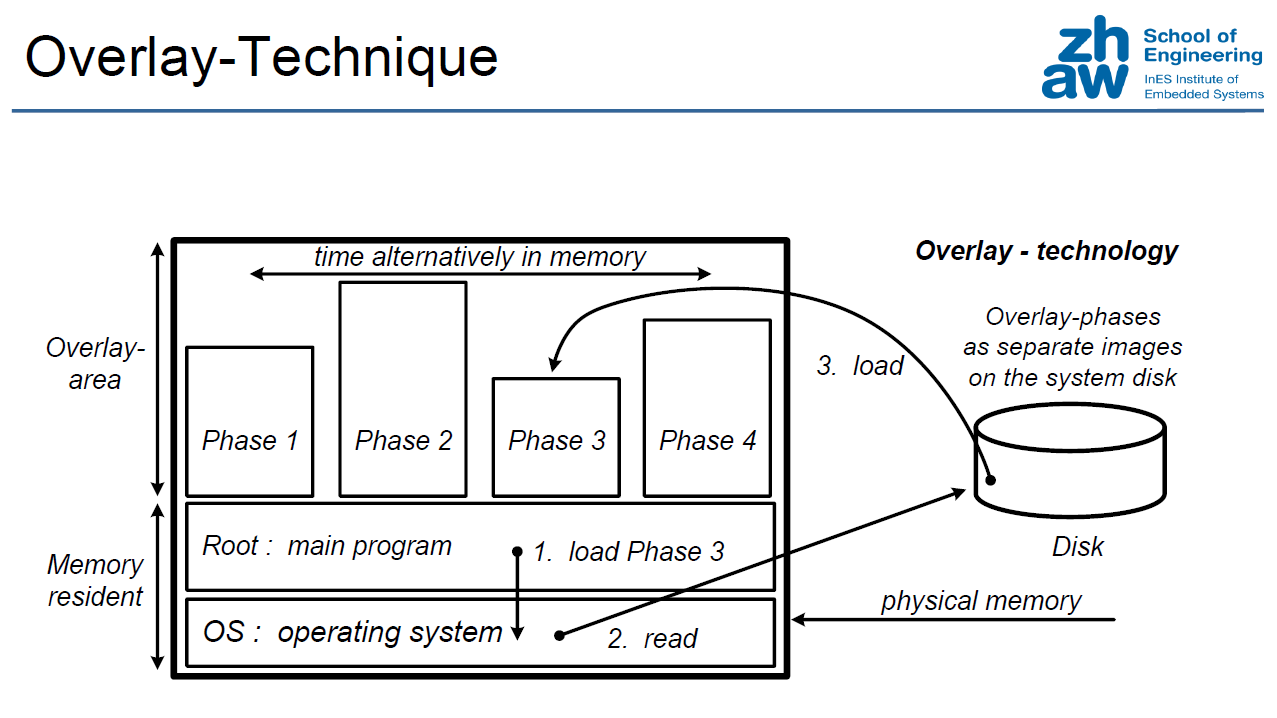

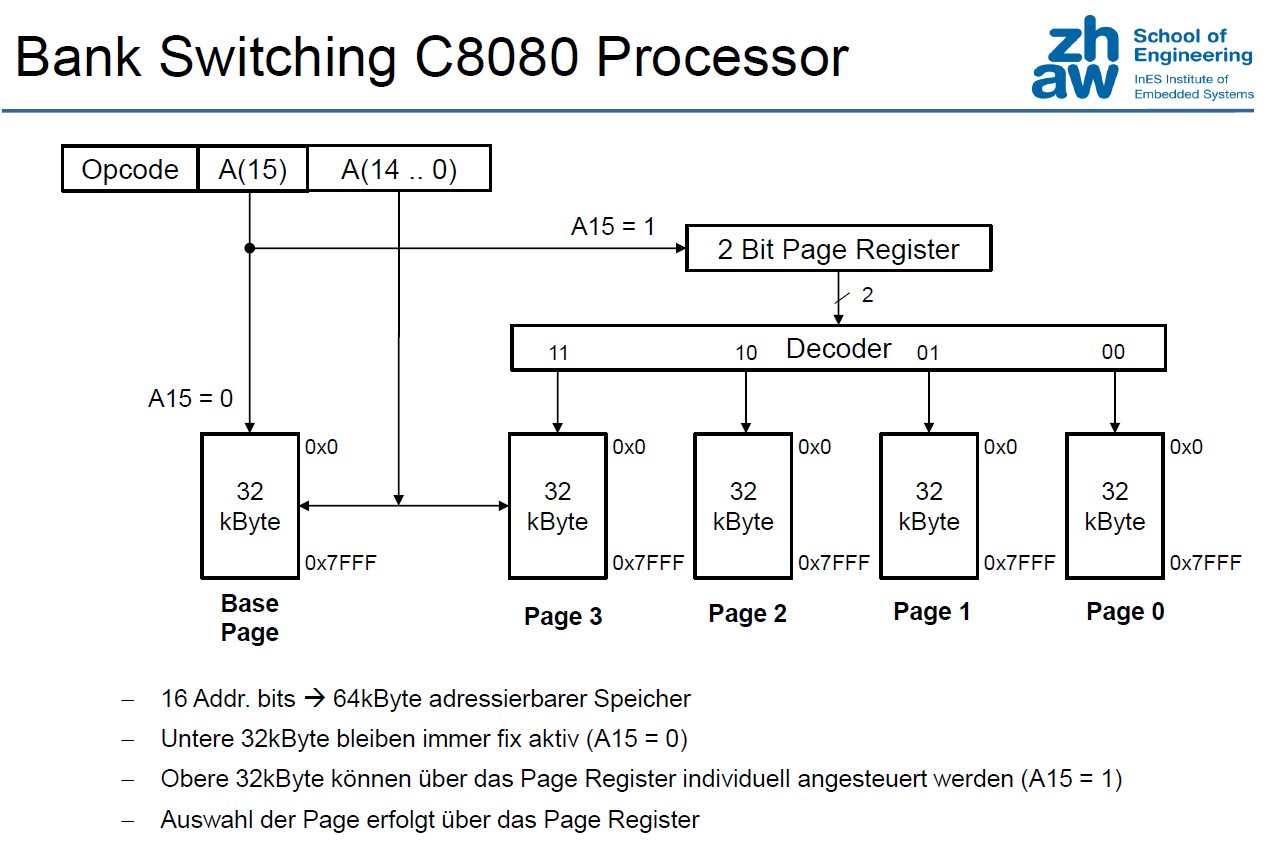

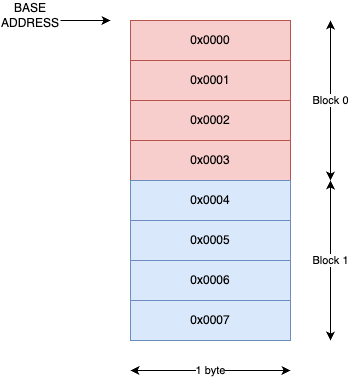

MMU

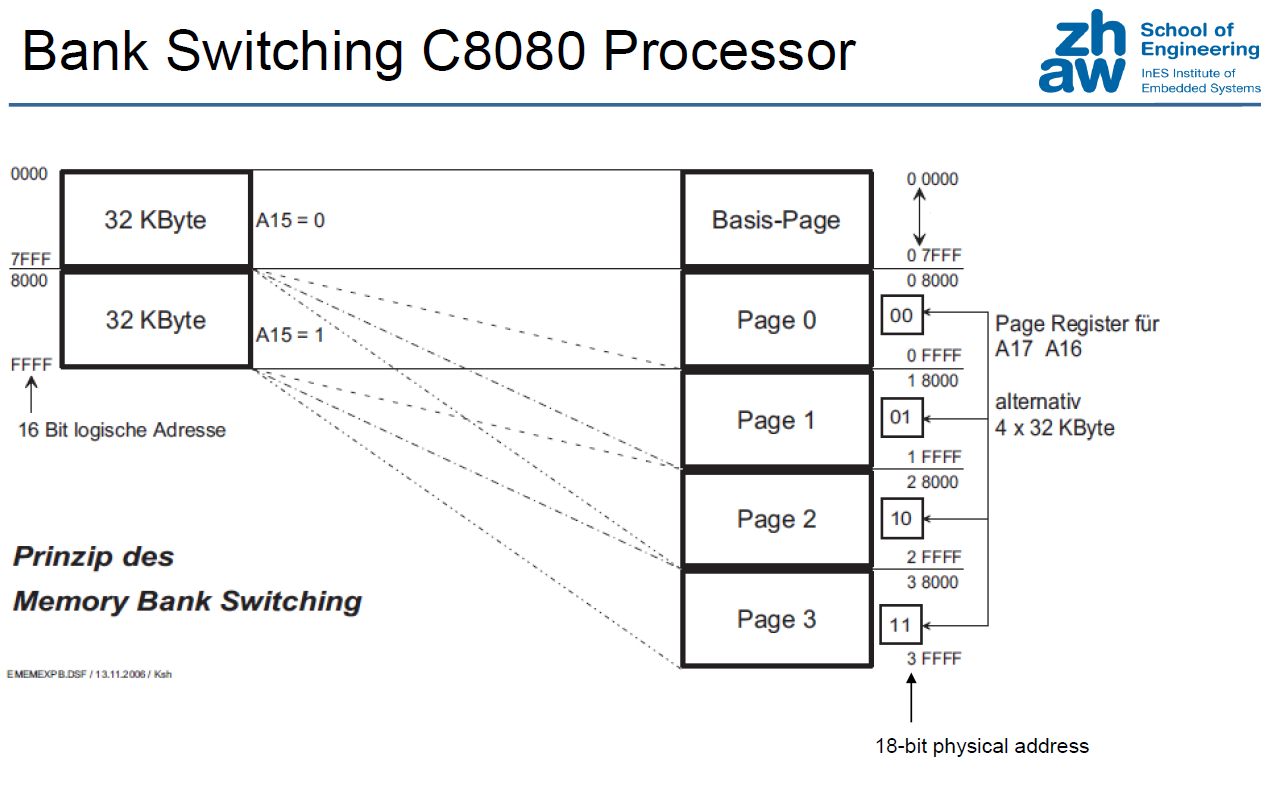

Expanding Address Space (Historical)

"Expanding" Physical memory

MEMORY MANAGEMENT USING SEGMENTATION

See presentation pages 19-22.

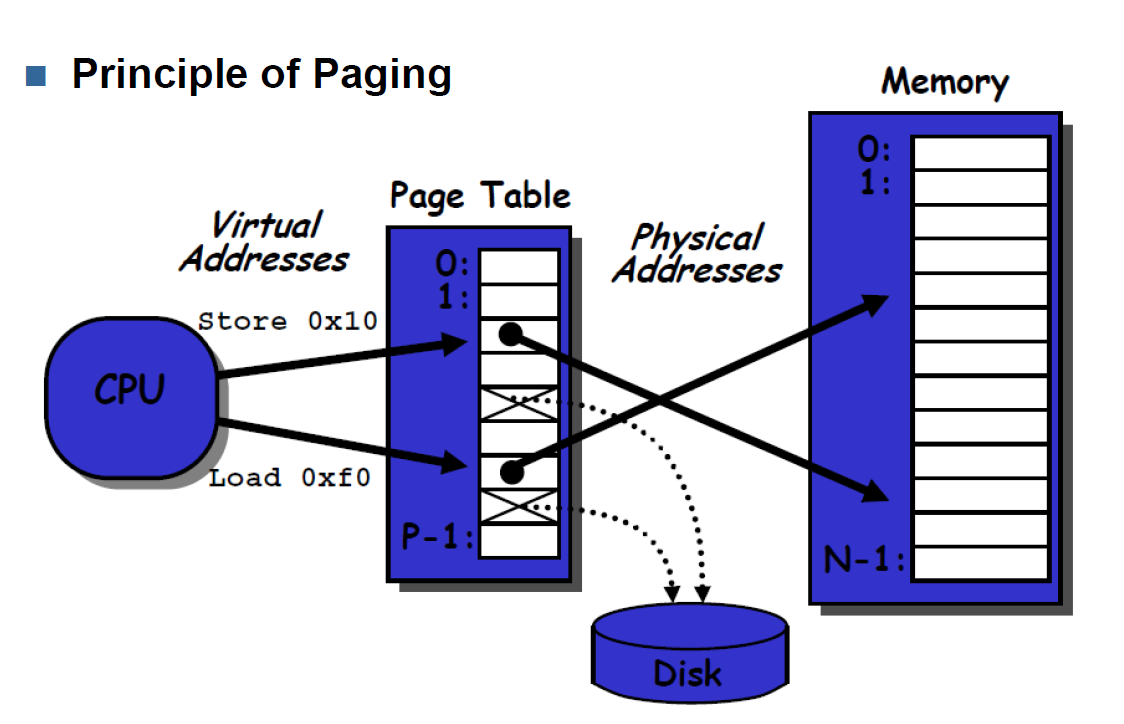

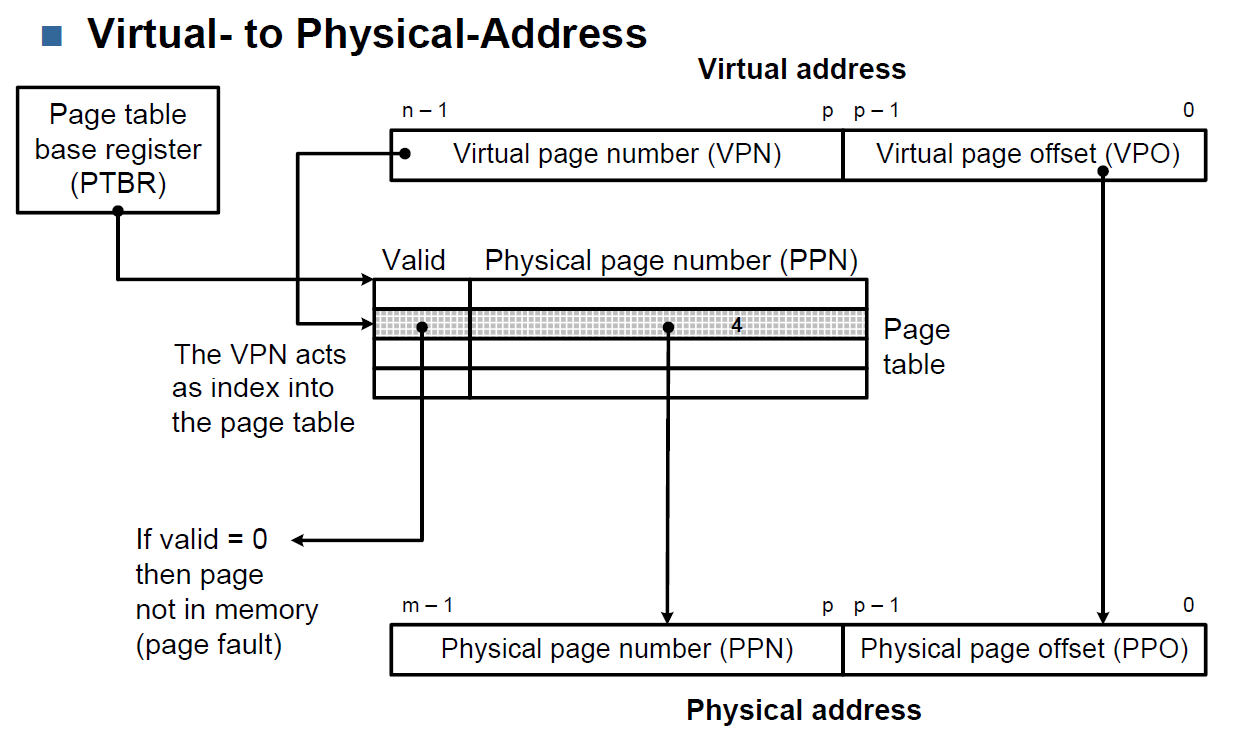

MEMORY MANAGEMENT BY PAGING

For more detail on Paging see slides pages 27ff.

Loading the pages using the DMA - See page 50.

Segmenting vs. Paging

| Paging | Segmentation | |

|---|---|---|

| Advantages |

|

|

| Disadvantages |

|

|

Cache and Translation Look Aside Buffer

See presentation pages 60-66.

Calculate Number of Page Entries, VPN, VPO, PPN, PPO

import math def n_page_entries(vir_addr_space, page_size, phy_memory_size): # Determine virtual page offset (VPO) size vpo_size = round(math.log(page_size, 2)) # Determine virtual page number (VPN) size vpn_size = vir_addr_space - vpo_size # Determine DRAM n_Address_Lines <=> physical address size # => also physical page number (PPN) & physical page offset (PPO) n_phy_addr_lines = round(math.log(phy_memory_size, 2)) ppn_size = n_phy_addr_lines - vpo_size ppo_size = vpo_size # Return number of possible page entries, vpn_size, vpo_ize, n_phy_addr_lines return 2 ** vpn_size, vpn_size, vpo_size, n_phy_addr_lines, ppn_size, ppo_size # Example usage vir_addr_space = 16 # in bits page_size = 4000 # in byte # phy_memory_size != n_phy_addr_lines # if n_phy_addr_lines is given -> phy_memory_size = (2^n_phy_addr_lines) phy_memory_size = 16e3 # in bytes n_pages, vpn_size, vpo_size, n_phy_addr_lines, ppn_size, ppo_size \ = n_page_entries(vir_addr_space, page_size, phy_memory_size) print(f'Physical Memory Size: {phy_memory_size} Bytes results in Physical Address Space: {n_phy_addr_lines}') print(f'PPN Size: {ppn_size}-Bits & PPO Size: {ppo_size}-bit\n') print(f'Virtual Address Space: {vir_addr_space} with a Page Size of {page_size} results in:') print(f'n Pages: {n_pages} & VPN Size: {vpn_size}-Bits & VPO Size: {vpo_size}-bit')

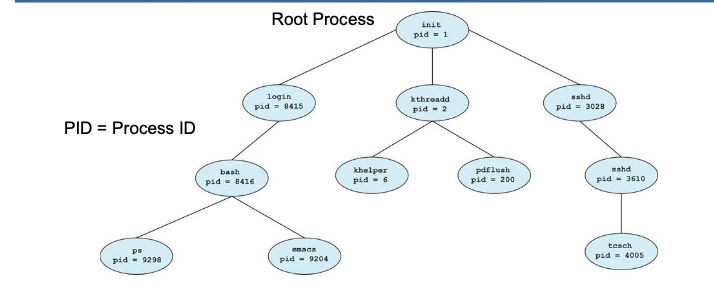

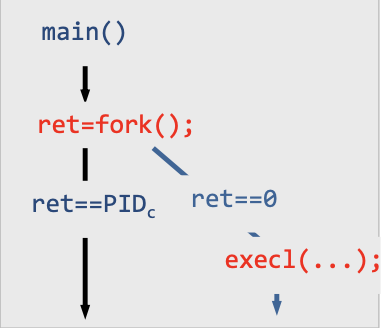

Scheduling

Process Tree

- OS starts with a single root proces

- Root process starts further processes in the OS (e.g. login, sshd, b-shell, etc)

- these processes can create further processes

Process

- A process is a program during execution

- A process runs if it were the only program running

- In fact only one process per CPU is running at any time

- MAkes it seem like all processes are running at the same time

- On multicore systems, processes may be distributed over multiple cores

- Each process has got its own reserved address space

- inter process communication takes special mechanism

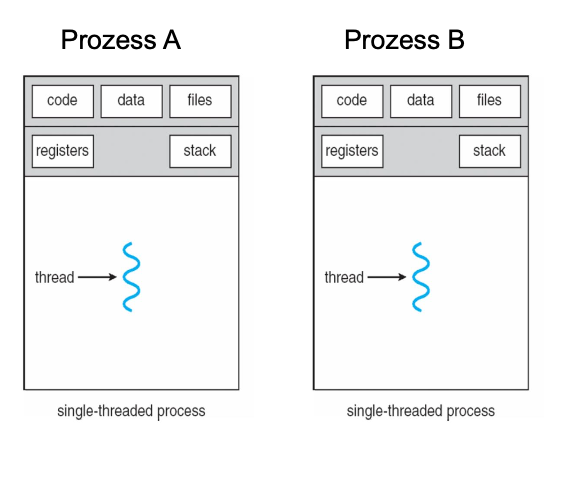

Single threaded process (default)

- Besides processes there are also threads. Threads are the little sisters of processes.

- A process has at least one thread

- A process has several management components (Code segment, executable, read-only, Data, stack, shared memory, PID, priorities, users)

- Stack segment with local variables

- Process have this overhead

- Communication between processes is expensive

- That’s the motivation for several threads within one process

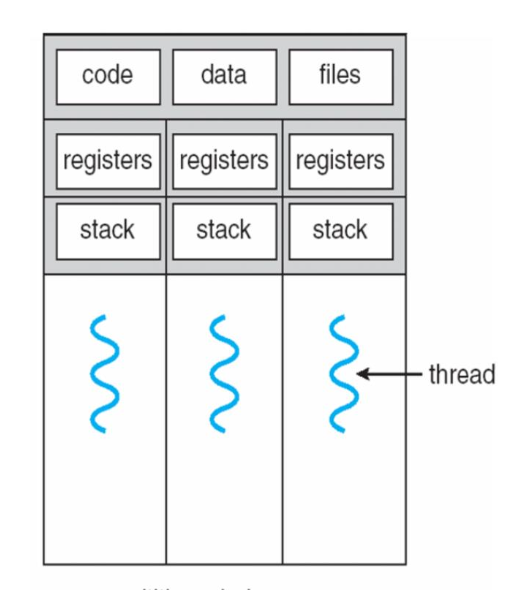

Multithreaded processes

Like processes, threads are an independent sequence of commands that execute a specific function

- A process can have many threads (but has at least one)

- Threads of one process are sharing the memory space of their process

- Each thread however gets its own stack and local variables

- Inter thread communication is simpler than inter process communication since threads are sharing the same memory space

- Unlike in the case of processes, there is however no protection of one threads memory space against manipulation from another thread

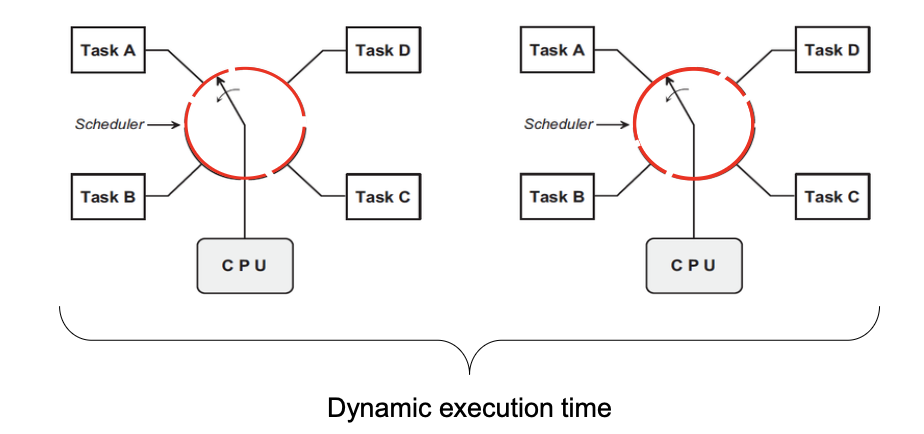

Task Scheduling

- Tasks mostly have variable timeslots and different priorities

- Which task runss next and how long is a decision of the task scheduler

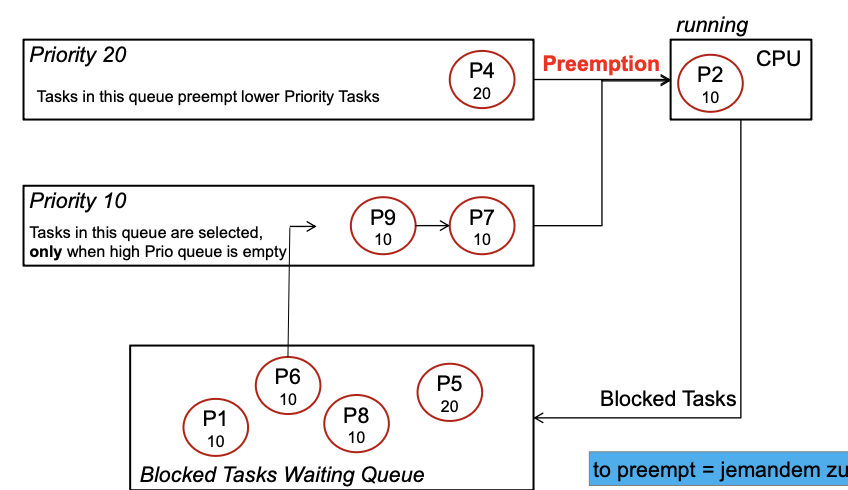

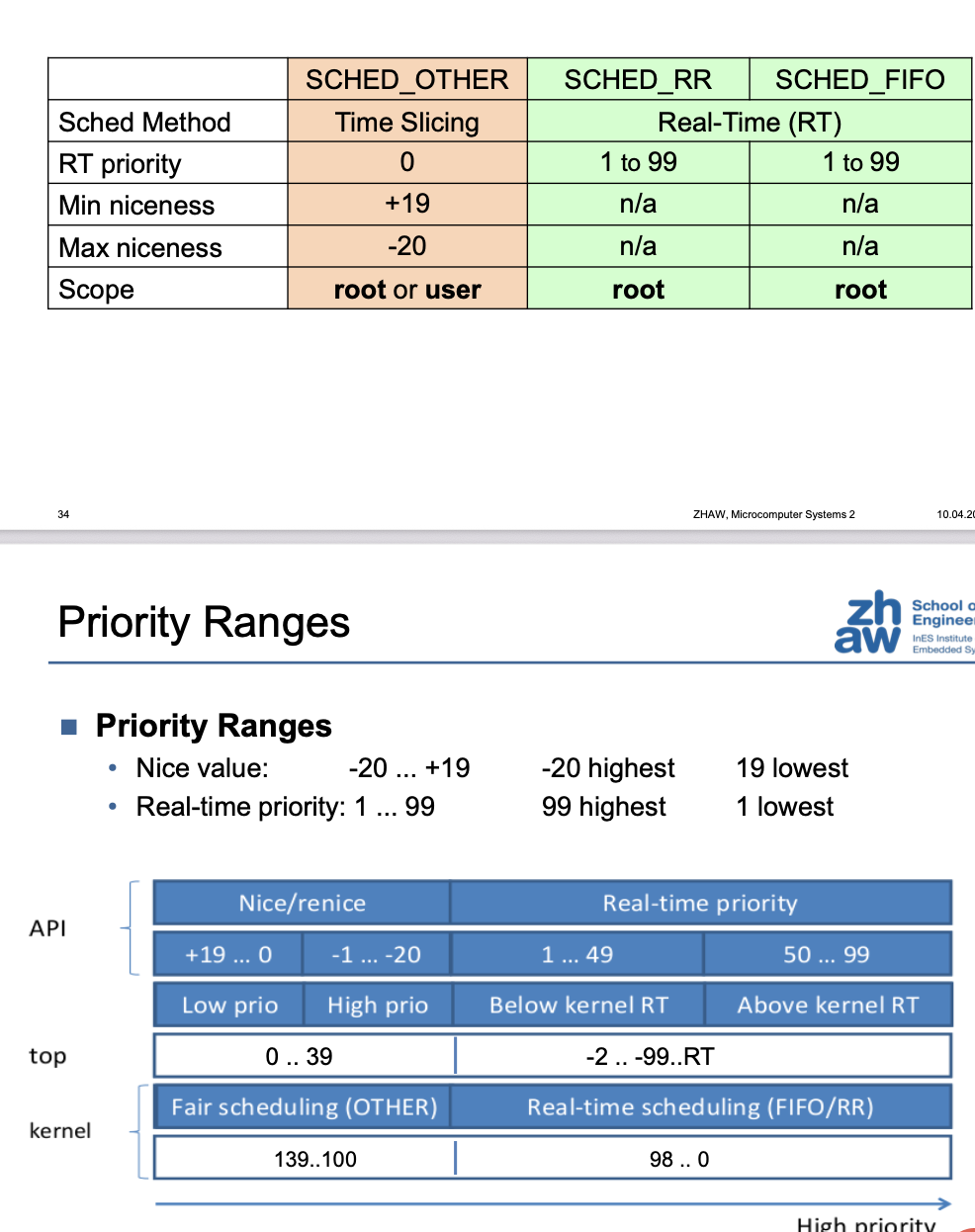

Scheduling Policies

- Preemption means, a task is interrupted in favour of another task

| Algorithm | Name | Real Time |

|---|---|---|

| Completely Fair Scheduler | SCHED_OTHER (SCHED_NORMAL) | No |

| Preemptive Scheduling | SCHED_FIFO | Yes |

| Round Robin Scheduling | SCHD_RR | Yes |

| Batch Scheduling (may not preemt SCHED_OTHER) | SCHED_BATCH | No |

| Executed when no other task | SCHED_IDLE | No |

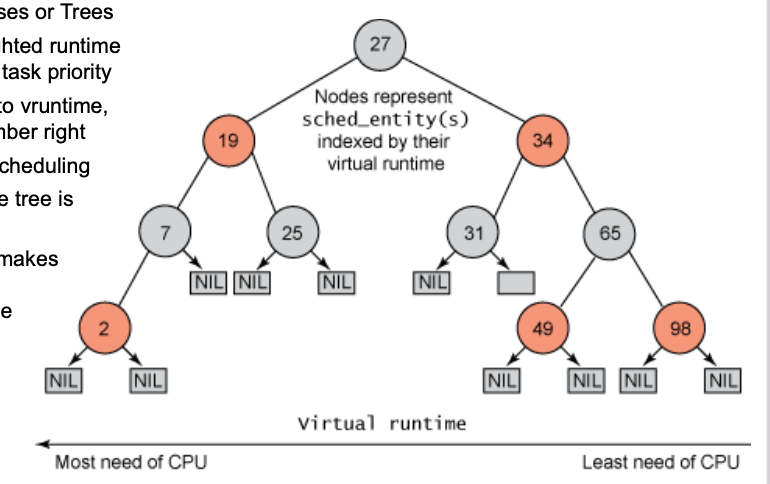

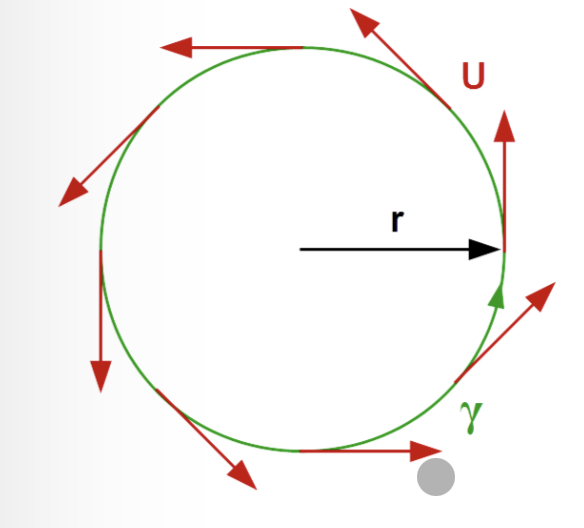

Completely Fair Scheduler (CFS)

- Each process should get a fair share of the processor

- If a process falls out of balance, it gets more time for execution next time

- An "ideal scheduler" distributes the computing power equally among all processes

- Circles represent Processes or Trees Numbers circles are weighted runtime (vruntime) – weighted by task priority

- Tree is sorted according to vruntime, low number left, high number right

- Left tasks get priority in scheduling

- After each scheduling, the tree is updated

- The balancing algorithm makes sure all tasks get a fair amount of processing time

- CFS is not suitable for real-time because run time is unpredictable

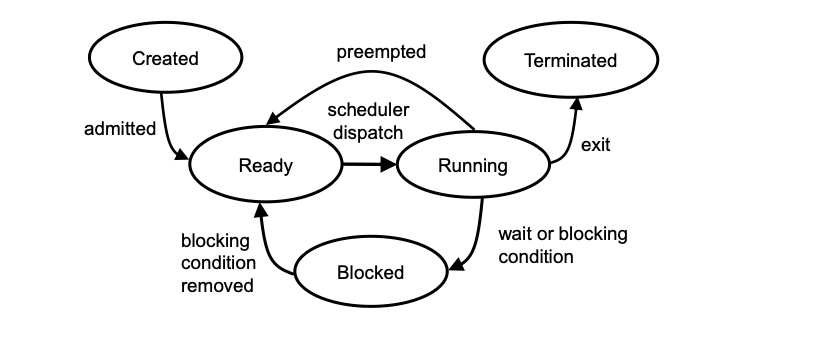

Task States

| State | Description |

|---|---|

| Running | Program in thread is executed |

| Blocking | Program in the thread is stopped – a blocking condition is preventing its further execution |

| Ready | Running condition of the thread is given, the thread waits in a queue for its turn. |

| Preempted | A higher priority thread interrupts the running thread. Since the condition of the thread is still given, the thread goes into Ready. |

| Created | The thread is initialized and waits until its run conditions are met. Then it goes into Ready and waits in the queue for execution. |

| Terminated | the task is set inactive |

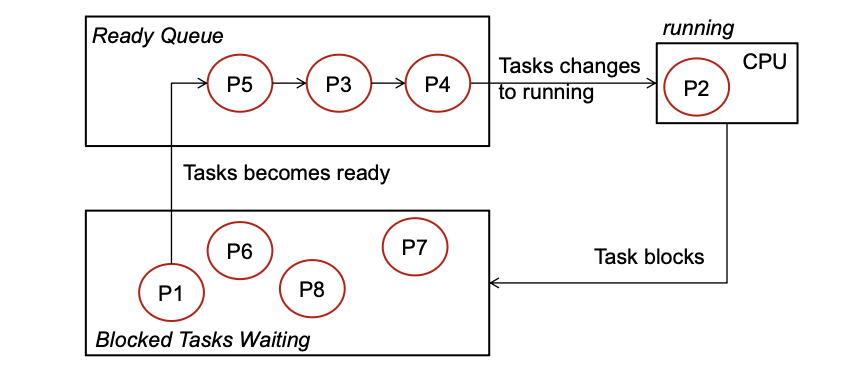

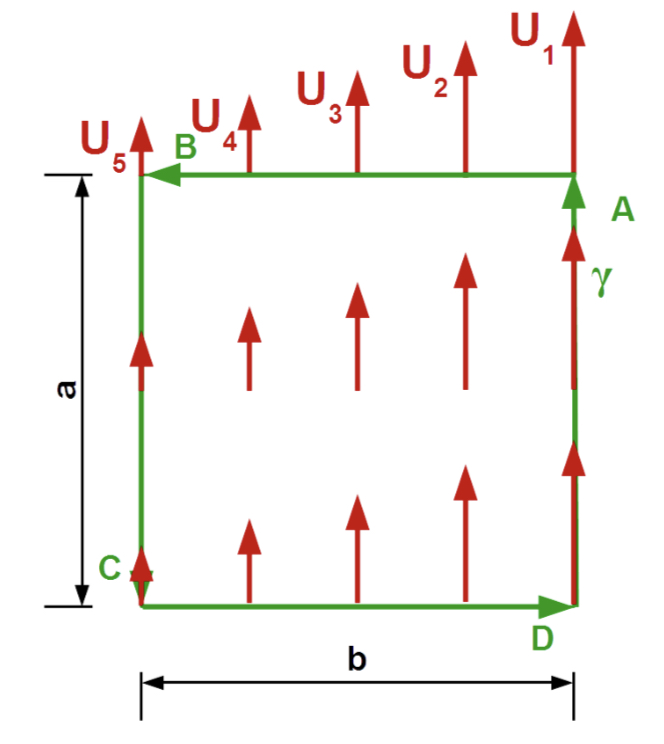

FIFO

All having the same priority

- Tasks in the „Blocked“ container wait until the condition to get active is fulfilled

- The first task in the „Ready Queue“ assumes running state as soon as the currently running task has completed or encounters a block condition

- Running tasks continue until they terminate or encounter a blocking condition

Different priorities (Priority QUEUE)

- Ready queues of different priority

- Higher priority task can be preempting

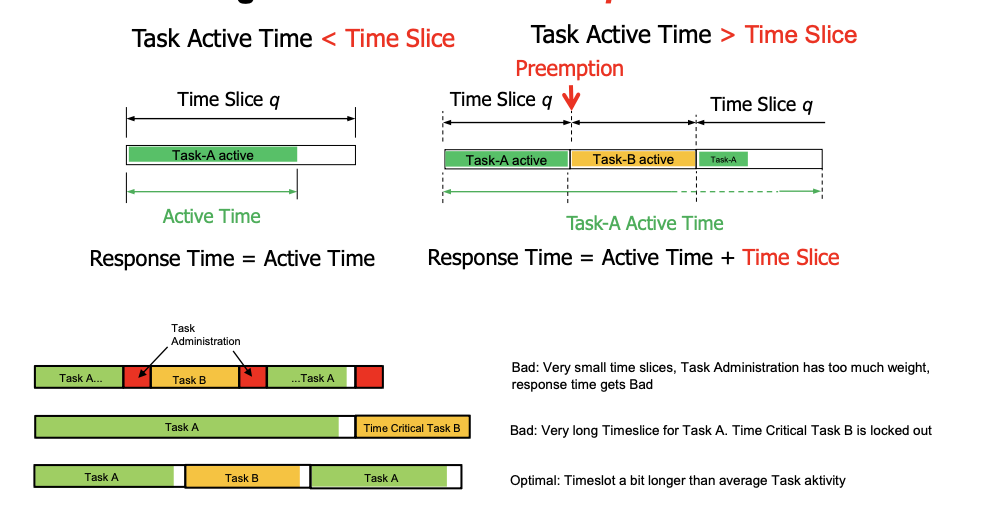

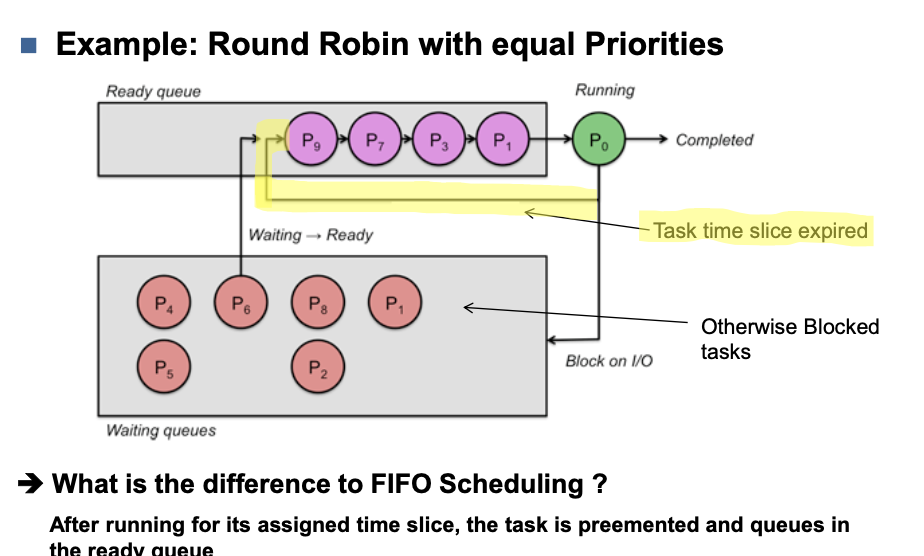

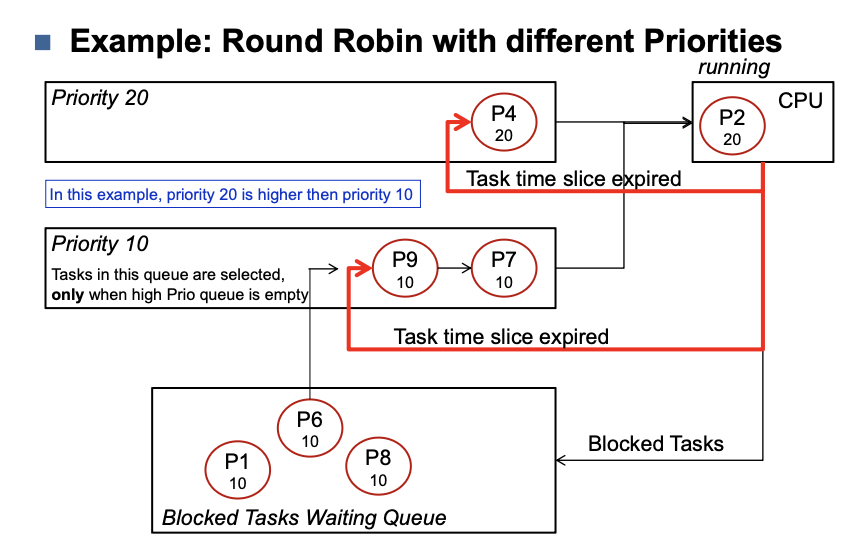

Round Robin (RR)

- Each task has a fixed time slice (sched_rr_timeslice_ms)

- Task runs for a configured timeslice or until it is blocked

How long should the time slice q be

Equal Priorities

Different priorities

Priority Ranges

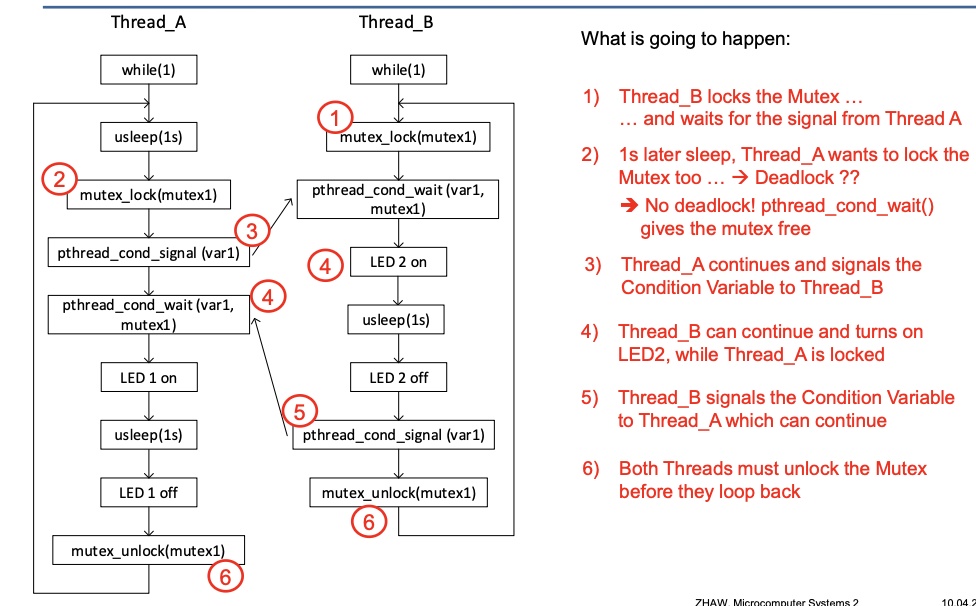

Condition Variables

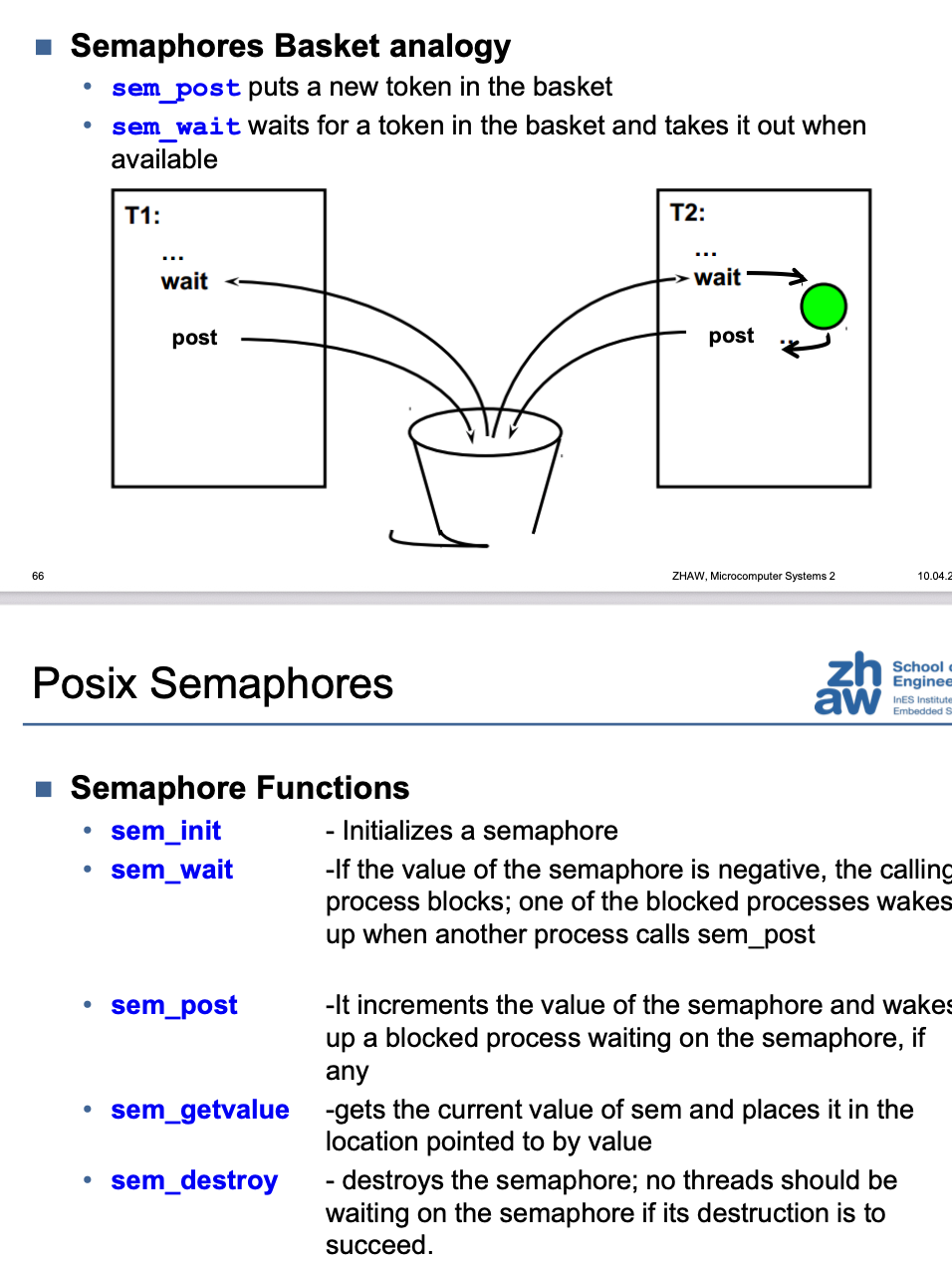

Semaphores

Semaphore Functions

| Funktion | Beschreibung |

|---|---|

| sem_init | Initializes a semaphore |

| sem_wait | If the value of the semaphore is negative, the calling process blocks; one of the blocked processes wakes up when another process calls sem_post |

| sem_post | It increments the value of the semaphore and wakes up a blocked process waiting on the semaphore, if any |

| sem_getvalue | gets the current value of sem and places it in the location pointed to by value |

| sem_destroy | destroys the semaphore; no threads should be waiting on the semaphore if its destruction is to succeed. |

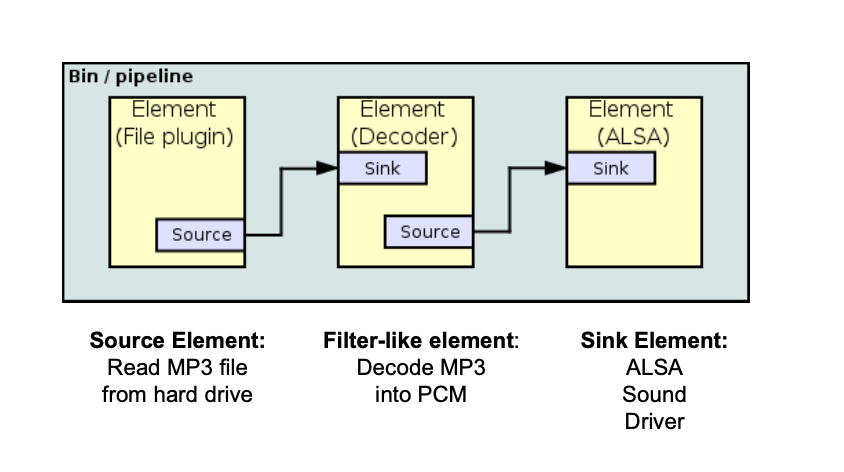

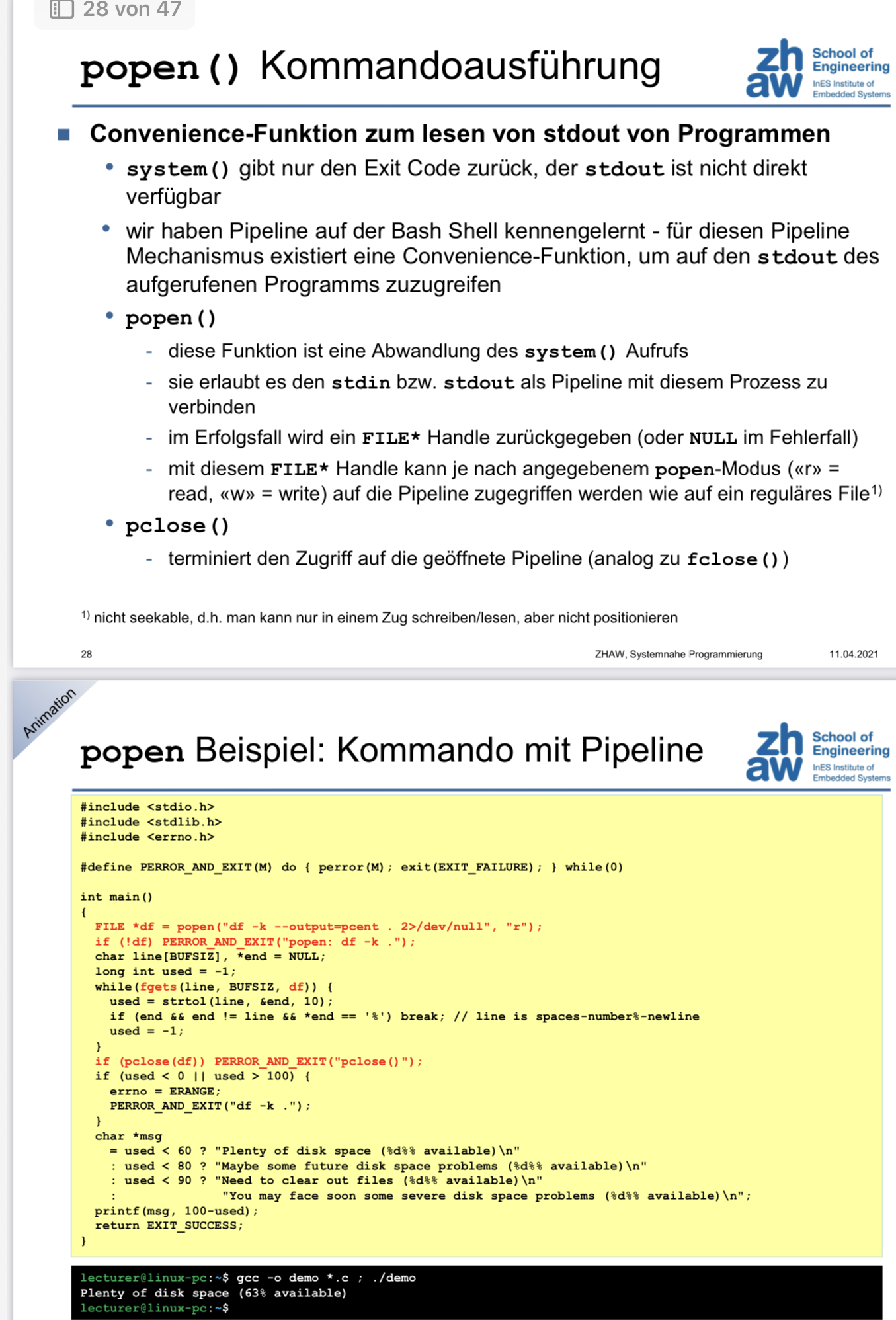

Gstreamer

Gstreamer uses a Bin / Pipeline architecture, where data from a source is pushed into a sink

The commands can be merged together using the pipe symbol

gst-launch-1.0 videotestsrc ! videoconvert ! autovideosink

Plugin-Documentation can be found here

C Pipeline using gst.h

/* GStreamer

* MC2-Lab6-Aufg. 1 - Loesung

* Written by Hans-Joachim Gelke

* You should have received a copy of the GNU Library General Public

* License along with this library; if not, write to the

* Free Software Foundation, Inc., 51 Franklin St, Fifth Floor,

* Boston, MA 02110-1301, USA.

*/

#include <gst/gst.h>

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

int main(int argc, char* argv[]) {

GstElement* bin;

GstElement* src;

GstElement* parser;

GstElement* resample;

GstElement* conv2;

GstElement* sink;

GMainLoop* loop;

gst_init(&argc, &argv);

bin = gst_pipeline_new("bin");

// Quelle: WAV-Datei über filesrc und wavparse

src = gst_element_factory_make("filesrc", "src");

g_object_set(G_OBJECT(src), "location", "./sound_files/coconut.wav", NULL);

parser = gst_element_factory_make("wavparse", "parser");

resample = gst_element_factory_make("audioresample", "resample");

conv2 = gst_element_factory_make("audioconvert", "inst_audioconvert2");

sink = gst_element_factory_make("alsasink", "sink");

g_object_set(G_OBJECT(sink), "device", "hw:1,0", NULL);

gst_bin_add_many(GST_BIN(bin), src, parser, resample, conv2, sink, NULL);

if(!gst_element_link_many(src, parser, resample, conv2, sink, NULL)) {

g_printerr("Elemente konnten nicht verlinkt werden.\n");

gst_object_unref(bin);

return -1;

}

gst_element_set_state(bin, GST_STATE_PLAYING);

/* we need to run a GLib main loop to get the messages */

loop = g_main_loop_new(NULL, FALSE);

/* Runs a main loop until g_main_loop_quit() is called on the loop */

g_print("Running_x_...\n");

g_main_loop_run(loop);

/* Out of the main loop, clean up nicely */

g_print("Returned, stopping playback\n");

gst_element_set_state(bin, GST_STATE_NULL);

g_print("Deleting pipeline\n");

gst_object_unref(bin);

return 0;

}

C using gst_launch

/* GStreamer

* MC2-Lab6-Aufg. 1 - Loesung

* Written by Hans-Joachim Gelke

* You should have received a copy of the GNU Library General Public

* License along with this library; if not, write to the

* Free Software Foundation, Inc., 51 Franklin St, Fifth Floor,

* Boston, MA 02110-1301, USA.

*/

#include <gst/gst.h>

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

int main(int argc, char* argv[]) {

GstElement* pipeline;

GstBus* bus;

GstMessage* msg;

gst_init(&argc, &argv);

// Definiere die Pipeline als String

gchar* pipeline_desc =

"filesrc location=./sound_files/music.mp3 ! mpegaudioparse ! "

"mpg123audiodec ! "

"audioconvert ! audioresample ! autoaudiosink";

// Erstelle die Pipeline mit gst_parse_launch

GError* error = NULL;

pipeline = gst_parse_launch(pipeline_desc, &error);

if(!pipeline) {

g_printerr("Fehler beim Erstellen der Pipeline: %s\n", error->message);

g_clear_error(&error);

return -1;

}

// Starte die Wiedergabe

gst_element_set_state(pipeline, GST_STATE_PLAYING);

// Warte auf EOS (End of Stream) oder Fehler

bus = gst_element_get_bus(pipeline);

msg = gst_bus_timed_pop_filtered(bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

if(msg != NULL) {

gst_message_unref(msg);

}

gst_object_unref(bus);

// Stoppe die Pipeline und gebe die Ressourcen frei

gst_element_set_state(pipeline, GST_STATE_NULL);

gst_object_unref(pipeline);

return 0;

}

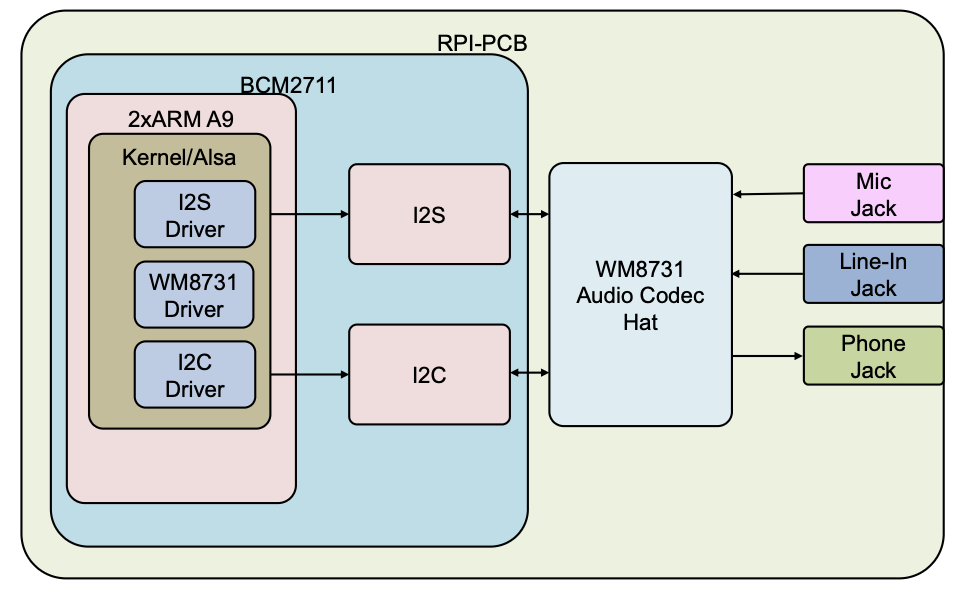

Advanced Linux Sound Architecture (ASLA)

- Automatic configuration of sound hardware and easy handling of multiple sound devices in one system

- Released under GPL and LGPL

- Written by Jaroslav Kysela, in Linux Kernel since v 2.5

- Replaced Open Sound System (OSS) in v 2.6

- Official ALSA Web Site: http://www.alsa-project.org

Video for Linux

v4l2-ctl --list-devices

Hier ist eine Zusammenfassung zum Thema „Einführung & Yocto Projekt“ aus dem Modul Microcomputer Systems 2 (MC2):

📦 Einführung & Yocto-Projekt

🔍 Was ist Embedded Linux?

-

Embedded Linux: Nutzung des Linux-Kernels in eingebetteten Systemen (Router, TVs, Steuergeräte).

-

Kombiniert Kernel mit Open-Source-Komponenten (glibc, busybox, etc.).

-

Vorteile:

- Keine Lizenzkosten

- Wiederverwendbarkeit von Komponenten

- Große Community-Unterstützung

- Viele verfügbare Bibliotheken und Treiber

💡 Warum ein Build-System?

Ohne Build-System:

- Manuelles Bauen jeder Komponente

- Abhängigkeiten müssen händisch aufgelöst werden

- Schwer wart- und reproduzierbar

Mit Build-System:

- Automatisierter Download, Konfiguration, Kompilierung

- Bessere Wartbarkeit und Anpassbarkeit

- Reproduzierbare Builds

🧰 Bekannte Build-Systeme:

| Name | Eigenschaften |

|---|---|

| Buildroot | Einfach, für kleine Systeme geeignet |

| PTXdist | Von Pengutronix, für Industrieeinsatz |

| OpenWRT | Ursprunglich für Router, sehr flexibel |

| Yocto | Sehr anpassbar, Layer-basiert, Standard bei Industrieprojekten |

🧱 Das Yocto-Projekt

📌 Definition:

- Sammlung von Werkzeugen, Vorlagen und Methoden

- Ziel: Erzeugung angepasster Embedded-Linux-Distributionen

- Initiator: Linux Foundation (seit 2010)

📦 Hauptkomponenten:

- Poky: Referenzdistribution (besteht aus BitBake, OpenEmbedded Core etc.)

- BitBake: Build-Engine (interpretiert Rezepte

.bb) - Layers: Sammlungen von Rezepten & Konfigurationen

📁 Verzeichnisstruktur (vereinfacht):

poky/

├── bitbake/ # Build-Engine

├── meta/ # OpenEmbedded Core Layer

├── meta-yocto/ # Yocto-spezifische Erweiterungen

├── meta-yocto-bsp/ # Board Support Packages (BSPs)

📐 Layer hinzufügen:

-

Konfiguration über:

bblayers.conf: Aktivierte Layerlocal.conf: Zielarchitektur, Build-Optionen, Anwendungen

🧪 Beispiel: Raspberry Pi

- Layer

meta-raspberrypieinfügen - Applikationen via eigener Layer z. B.

meta-student,meta-mc2einbinden

🗓 Semesterplan FS25 (Auszug)

| Woche | Thema | Labor |

|---|---|---|

| 1 | Embedded Linux & Yocto | Lab1: BitBake & Layerstruktur |

| 2 | Embedded Linux System | Lab2: Softwareentwicklung |

| ... | ... | ... |

Wenn du möchtest, kann ich dir diese Zusammenfassung auch als Markdown-Datei exportieren.

📦 Embedded Linux System

🪑 Ziel

Ein minimales Linux-System für eingebettete Hardware verstehen, erstellen und analysieren.

🔢 Grundlegende Linux-Kommandos

| Kommando | Funktion |

|---|---|

ls, cd, pwd | Navigation im Dateisystem |

cp, mv, rm | Dateioperationen |

grep, find | Suchen nach Inhalten und Dateien |

chmod, chown, chgrp | Rechteverwaltung |

df -h, du -skh | Speicherplatz anzeigen |

tar, gzip | Archivieren & Komprimieren |

mount, umount | Einhängen von Dateisystemen |

📀 Linux-Dateisystem

-

Wurzelverzeichnis:

/ -

Wichtige Verzeichnisse:

/bin,/sbin,/lib: essentielle Programme und Bibliotheken/etc: Konfigurationsdateien/dev: Gerätedateien/proc,/sys: Pseudo-Dateisysteme zur Kernelkommunikation

🚗 Zielplattformen

-

Plattformen mit und ohne MMU (Memory Management Unit)

-

✅ Anforderungen:

- mind. 8 MB RAM (besser 32 MB)

- 4 MB Flash oder Ramdisk

💻 Hardwaretypen

| Typ | Beschreibung |

|---|---|

| Component on Module | Nur CPU, RAM, Flash mit Steckkontakten |

| Evaluation Board | Voll ausgestattete Entwicklungsplattform |

| Custom Platform | Selbst entwickelte Hardware |

⚙️ Toolchain für Embedded Linux

-

Trennung zwischen Host (Entwicklung) und Target (Zielsystem)

-

Typen:

- Native Toolchain (nur für Host)

- Cross-Compiler: Kompiliert auf Host für Zielarchitektur (z. B. ARM)

Toolchain-Komponenten

- GCC (Compiler)

- Binutils (Linker, Assembler)

- C-Library (z. B. glibc, uClibc, musl)

- Debugger (gdb, gdbserver)

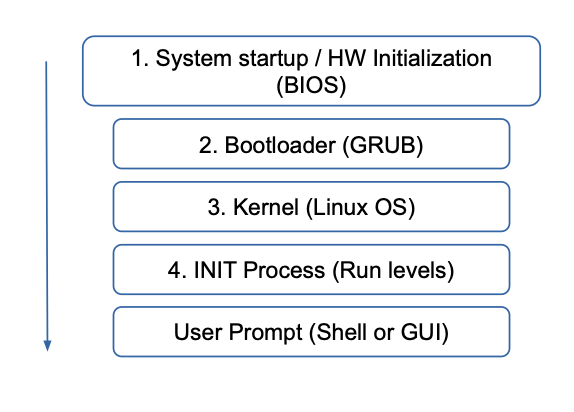

⚡ Bootloader & Startprozess

-

Typisch: U-Boot auf Embedded Systemen

-

Aufgaben:

- Initialisierung der HW

- Laden des Kernels

- Übergabe von Kernelparametern (root=...)

📆 Praktischer Ablauf

Lab1: Yocto SD-Image

- Erstellung eines kompletten Images mit eigener Applikation

- Befehl:

bitbake core-image-minimal - Ergebnis: bootfähiges System auf SD-Karte

Lab2-12: NFS-basiertes System

- Kernel & U-Boot auf SD-Karte, Rest über Netzwerk (NFS RootFS)

- Entwicklung & Debugging über SSH, GDB, Serial Console

🚤 Root-Benutzer & sudo

- Root darf alles, Standardbenutzer nicht

sudoermöglicht Ausführung privilegierter Kommandos als normaler Benutzer

🚪 Startprozess

- Erster Prozess:

/sbin/init - Verwaltet Runlevel (z. B. 0 = Shutdown, 3 = Multi-User)

- Tools:

shutdown,reboot,halt

Dies bildet die Grundlage für alle weiteren Themen wie GPIO, Kernelmodule, Scheduling und Realtime.

🔌 Linux GPIO (General Purpose Input/Output)

🚀 Ziel

Zugriff auf die GPIO-Pins unter Linux, sowohl aus Userspace als auch im Kernelmodul, verstehen und umsetzen.

🔧 Methoden des GPIO-Zugriffs

1. Pseudo-Dateisystem (/sys/class/gpio)

- Nutzerfreundlich & portabel

- Benötigt GPIO-Treiber im Kernel

Typische Befehle:

echo 340 > /sys/class/gpio/export

echo out > /sys/class/gpio/gpio340/direction

echo 1 > /sys/class/gpio/gpio340/value

echo 340 > /sys/class/gpio/unexport

2. Speicher-Mapping (Memory Map)

- Direktzugriff auf Register

- Benötigt Root-Rechte und Kenntnis der physischen Adressen

- Schnell, aber nicht portabel

Beispiel-Code:

#define GPIO_BASE_ADDR 0xfe200000

#define GPIO_SET0 0x1c

#define GPIO_CLR0 0x28

void *virtual_gpio_base;

uint32_t *gpio_reg = (uint32_t *)(virtual_gpio_base + GPIO_SET0);

*gpio_reg = (0x1 << gpio);

🗋 Register des BCM2711 (Raspberry Pi 4)

| Register | Funktion |

|---|---|

| GPFSEL0-5 | Pin-Funktionsauswahl (In/Out) |

| GPSET0-1 | GPIO auf HIGH setzen |

| GPCLR0-1 | GPIO auf LOW setzen |

| GPLEV0-1 | Pegel lesen (Input-Zustand) |

Beispiel: GPFSEL für GPIO-Richtung setzen

#define FSELX_OFFSET(pin) ((pin % 10) * 3)

*gpio_reg &= ~(0x7 << FSELX_OFFSET(gpio)); // Clear Bits

*gpio_reg |= (1 << FSELX_OFFSET(gpio)); // Set Output

🧰 Device Tree

- Deklaration der GPIO-Adressen und Kompatibilität

soc {

gpio@7e200000 {

compatible = "brcm,bcm2711-gpio";

reg = <0x7e200000 0xb4>; // legacy addr + size

};

};

⚖️ mmap-Zugriff in C

int m_mfd = open("/dev/mem", O_RDWR);

virtual_gpio_base = mmap(NULL, 4096, PROT_READ|PROT_WRITE,

MAP_SHARED, m_mfd, GPIO_BASE_ADDR);

close(m_mfd);

🔺 Legacy vs. ARM View Adressen

| Typ | Adresse |

|---|---|

| Legacy (32-bit) | 0x7e200000 |

| ARM View (35-bit) | 0xfe200000 |

🔔 Praxis

- LED an GPIO12 einschalten:

echo 12 > /sys/class/gpio/export

echo out > /sys/class/gpio/gpio12/direction

echo 1 > /sys/class/gpio/gpio12/value

- Button an GPIO22 auslesen:

echo 22 > /sys/class/gpio/export

echo in > /sys/class/gpio/gpio22/direction

cat /sys/class/gpio/gpio22/value

Diese GPIO-Kenntnisse bilden die Grundlage für Kernelmodule, Interruptsteuerung und weitere eingebettete Hardwareinteraktionen.

🧬 Linux Kernel

🏗 Architektur

📦 Kerneltypen

| Typ | Beschreibung |

|---|---|

| Monolithisch | Alles in einem Kernelimage, inkl. Treiber |

| Modular | Monolithisch mit ladbaren Modulen (*.ko) zur Laufzeit |

Linux ist modular und monolithisch – es erlaubt dynamisches Nachladen von Modulen, behält aber die monolithische Struktur.

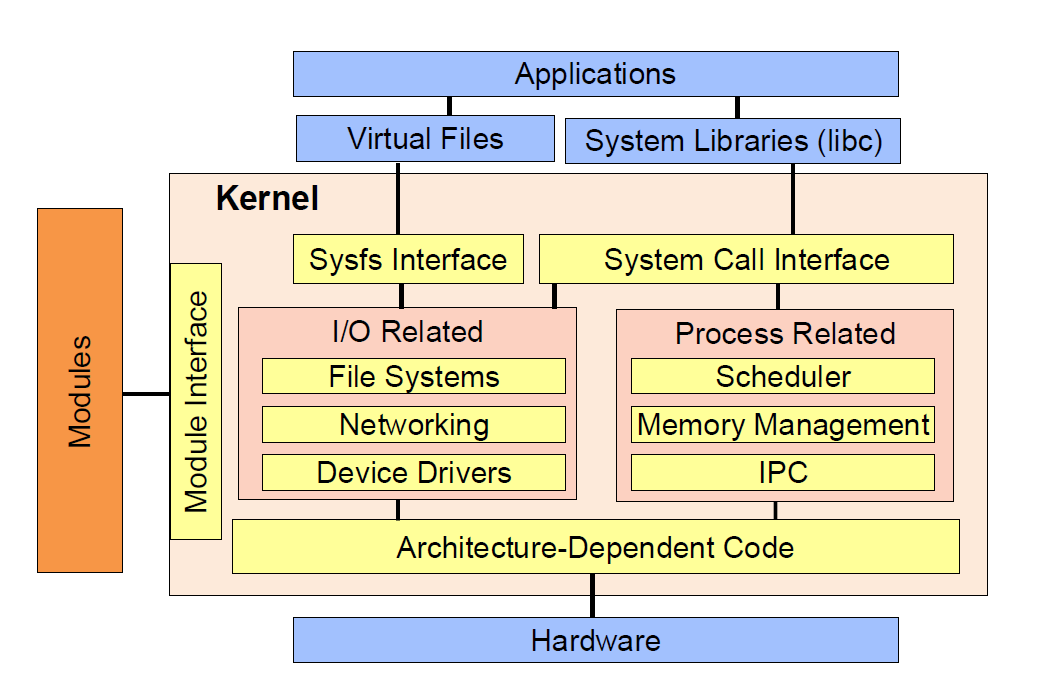

🧱 Architektur-Übersicht

Anwendungen

└─ Systembibliotheken (libc)

└─ System Call Interface (SYSCALL)

└─ Kernelspace:

├─ Prozessverwaltung

├─ Speicherverwaltung (MMU)

├─ Gerätetreiber

├─ Dateisysteme

└─ Netzwerkschnittstellen

🕳 System Calls

- Ermöglichen Übergang von Userspace in Kernelspace

- Beispiel:

read(),write(),open(),ioctl()

🗃 Kernel-Sourcen

- Bezugsquelle: https://www.kernel.org

- Verzeichnisstruktur:

/usr/src/linux

├── arch/ # Architektur-spezifisch (z. B. arm, x86)

├── drivers/ # Gerätetreiber

├── fs/ # Dateisysteme

├── include/ # Headerdateien

├── kernel/ # Kernelkern: Scheduler, Signals

└── net/ # Netzwerkstack

⚙️ Konfiguration & Kompilierung

Konfigurationstools:

make menuconfig(Textoberfläche)make xconfig(GUI)

Konfigurationsdateien:

.config: Ergebnis der Konfiguration- Mit Yocto:

bitbake -c menuconfig virtual/kernel

Kernel bauen:

make ARCH=arm CROSS_COMPILE=arm-linux-gnueabi- zImage

Module installieren:

make INSTALL_MOD_PATH=/pfad/ modules_install

📦 Kernelmodule

- Dynamisch ladbare Erweiterungen (*.ko)

- Einbindung in Kernel zur Laufzeit mit

insmod,modprobe

Minimalbeispiel:

#include <linux/module.h>

#include <linux/init.h>

static int __init hello_init(void) {

pr_info("Hello Kernel\n");

return 0;

}

static void __exit hello_exit(void) {

pr_info("Bye Kernel\n");

}

module_init(hello_init);

module_exit(hello_exit);

MODULE_LICENSE("GPL");

🧪 Kernel starten & Debugging

-

Erster Prozess:

/sbin/init -

Runlevel steuern Startverhalten

-

Tools:

dmesg– Kernelmeldungenlsmod,modinfo,insmod,rmmod– Modulinformationen

Diese Grundlagen bereiten auf die Entwicklung eigener Kernelmodule, Platform-Driver und Device-Tree-Integration vor.

Absolutely — here’s a detailed explanation of scheduling on Linux, especially as it applies to embedded systems, covering both technical background and practical aspects.

🧠 Detailed Guide: Scheduling on Linux (with Focus on Embedded Systems)

1. The Role of the Scheduler

The Linux scheduler decides which task runs next on a CPU. It's critical for managing multitasking and ensuring system responsiveness, fairness, and (in embedded/real-time systems) deterministic behavior.

2. Linux Scheduling Classes

2.1. CFS (Completely Fair Scheduler) – Default Scheduler

- Goal: Fair CPU time distribution based on task weights (influenced by the nice value).

- Implementation: Uses a red-black tree where the leftmost node (task with the least "virtual runtime") gets scheduled next.

- Latency Target: Tries to ensure all tasks get CPU time within a configurable window (

sched_latency_ns).

✅ Pros: General-purpose, efficient for desktops and servers. ❌ Cons: Not deterministic – not suited for hard real-time tasks.

2.2. Real-Time Scheduling: SCHED_FIFO and SCHED_RR

🛠 SCHED_FIFO

- First-in, first-out.

- Tasks run until they block or voluntarily yield.

- No time-slicing between tasks of the same priority.

🔁 SCHED_RR

- Round-robin version of FIFO.

- Tasks get a time quantum and are rotated if others have the same priority.

🎯 Both are POSIX-compliant and useful in real-time embedded apps (e.g., sensor polling, control loops).

2.3. SCHED_DEADLINE

-

Based on Earliest Deadline First (EDF) and Constant Bandwidth Server (CBS).

-

Each task specifies:

- Runtime: how much CPU time it needs

- Period: how often it runs

- Deadline: when it must finish

🛠 Useful for hard real-time requirements in control systems or media processing pipelines.

2.4. SCHED_IDLE

- Used for background/idle tasks that should only run when the CPU is otherwise idle.

- Lowest scheduling priority.

3. Priorities and Policy Management

3.1. Nice Values (CFS Only)

- Range: -20 (highest priority) to +19 (lowest priority).

- Used to weight CFS tasks – not real-time priorities.

3.2. Real-Time Priorities

- Range: 1 to 99.

- Higher value = higher priority.

- Real-time policies (FIFO, RR, Deadline) preempt non-RT and lower-priority RT tasks.

4. Real-Time Linux with PREEMPT-RT

In embedded systems, real-time behavior (guaranteeing a task runs within a deadline) is often critical.

🔧 What is PREEMPT-RT?

A set of kernel patches that turn Linux into a real-time operating system (RTOS).

🧩 Key Features:

- Preemptible kernel: Most kernel code can be interrupted.

- Threaded IRQs: Hardware interrupts handled by kernel threads, which can be scheduled like normal tasks.

- Priority inheritance: Avoids priority inversion by temporarily raising the priority of tasks holding locks.

- Real-time mutexes (rtmutex): Replace spinlocks.

🛠 Suitable for:

- Industrial controllers

- Medical devices

- Audio processing

- Robotics

5. Embedded System-Specific Considerations

5.1. Resource Constraints

- Embedded systems often have limited CPU, RAM, and power.

- Schedulers must be lightweight and deterministic.

5.2. Deterministic Timing

- Latency (response time) and jitter (variance) must be predictable.

- Non-real-time Linux (e.g., CFS) is often too variable.

5.3. Power Management

- Use SCHED_IDLE, CPU governors, and sleep states carefully.

- Misconfigured power settings can introduce latency spikes.

5.4. Interrupt Handling

- IRQs can be configured as threads in PREEMPT-RT.

- Allows priority-based scheduling of interrupt handlers.

6. Tools for Managing and Debugging Scheduling

| Tool | Use Case |

|---|---|

chrt | Set/view real-time priorities |

taskset | Bind tasks to specific CPUs |

top, htop | Monitor running tasks, CPU usage, policies |

cyclictest | Measure latency and jitter |

ftrace | Trace scheduler events |

latencytop | Identify sources of high latency |

perf | Performance analysis (including scheduling) |

tuna | GUI for real-time tuning (isolating CPUs, setting affinities) |

7. Best Practices in Embedded Linux Scheduling

- Use PREEMPT-RT kernel for real-time applications.

- Reserve CPUs for real-time tasks (CPU shielding or isolcpus).

- Use SCHED_FIFO/RR for latency-sensitive tasks.

- Minimize system noise: disable unneeded services, isolate IRQs, tune power management.

- Profile and test with

cyclictest,ftrace, orperfbefore deployment.

8. Typical Real-Time Embedded Use Cases

| Application Area | Scheduling Use |

|---|---|

| Motor Control | SCHED_FIFO for exact cycle timing |

| Audio/Video Processing | SCHED_DEADLINE or SCHED_RR |

| Sensor Data Acquisition | Real-time threads with low latency |

| Industrial Control | Kernel with PREEMPT-RT, IRQ threading |

| Robotics (ROS 2) | Real-time scheduling of control nodes |

Would you like this formatted into a PDF handout, a presentation, or perhaps a cheatsheet? Let me know your use case (e.g., study, teaching, development), and I can tailor it further.

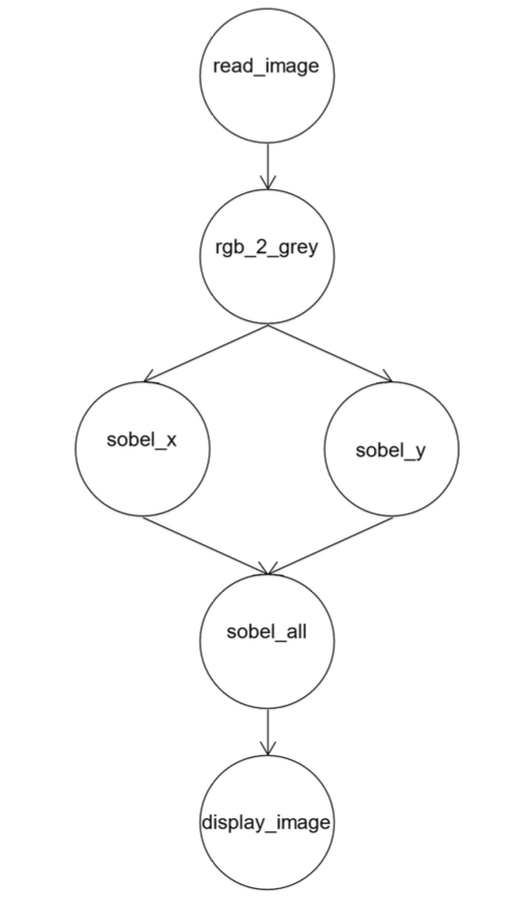

👁️🗨️ Computer Vision mit OpenCV

🎯 Ziel

Grundlagen der Bildverarbeitung mit OpenCV verstehen und anwenden, insbesondere im Kontext von Embedded Linux und Python.

📦 Was ist OpenCV?

- Open Source Computer Vision Library

- Seit 1999 (Intel), heute plattformübergreifend

- Programmiersprachen: C++, Python, Java

- Plattformen: Linux, Windows, macOS, Android, iOS

- GPU-Unterstützung mit CUDA, OpenCL

🐍 Python-Basics für OpenCV

import cv2 import numpy as np

Bild einlesen und anzeigen

img = cv2.imread('bild.jpg') cv2.imwrite('ausgabe.jpg', img)

Argumente per Kommandozeile

import sys img = cv2.imread(sys.argv[1])

🧱 Bildstruktur

- Farbige Bilder: 3D-Array (Höhe × Breite × Kanäle)

- Graustufenbilder: 2D-Array

🎨 Bildmanipulationen

Eigenschaften abfragen

h, w, c = img.shape img.dtype, img.size

Pixelzugriff

px = img[100, 100] # Zugriff auf BGR-Werte img[100, 100] = [255, 0, 0] # Setzt Pixel blau

Farbkanäle splitten/mergen

b, g, r = cv2.split(img) img = cv2.merge((b, g, r))

Kanäle nullsetzen

img[:, :, 1] = 0 # Kein Grün

📸 Video mit OpenCV

Kamera-Zugriff

cap = cv2.VideoCapture(0) ret, frame = cap.read() gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY) cv2.imwrite('grau.jpg', gray) cap.release()

🖍 Zeichenfunktionen

cv2.line(img, (0, 0), (100, 100), (255, 0, 0), 3) cv2.rectangle(img, (10, 10), (50, 50), (0, 255, 0), 2) cv2.circle(img, (60, 60), 20, (0, 0, 255), -1)

🧠 Bildverarbeitung

Farbraumkonvertierung

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

Convolution

- Anwenden von Filtern (z. B. Weichzeichnen, Kanten finden)

Beispiel: Median Blur

cv2.medianBlur(img, 5)

📚 Weitere Features

Texterkennung (OCR)

- Integration mit Tesseract

Bar-/QR-Code-Erkennung

- z. B. mit

pyzbaroder OpenCV-Funktionalität

Objekterkennung

- Haar-Cascades: Gesichtserkennung uvm.

📈 Performance

t1 = cv2.getTickCount() # Verarbeitung elapsed = (cv2.getTickCount() - t1) / cv2.getTickFrequency() print(f"Dauer: {elapsed:.4f} s")

Optimierung aktivieren

cv2.setUseOptimized(True)

OpenCV ist das zentrale Werkzeug für Bildverarbeitung im Embedded-Bereich – effizient, flexibel und plattformunabhängig einsetzbar.

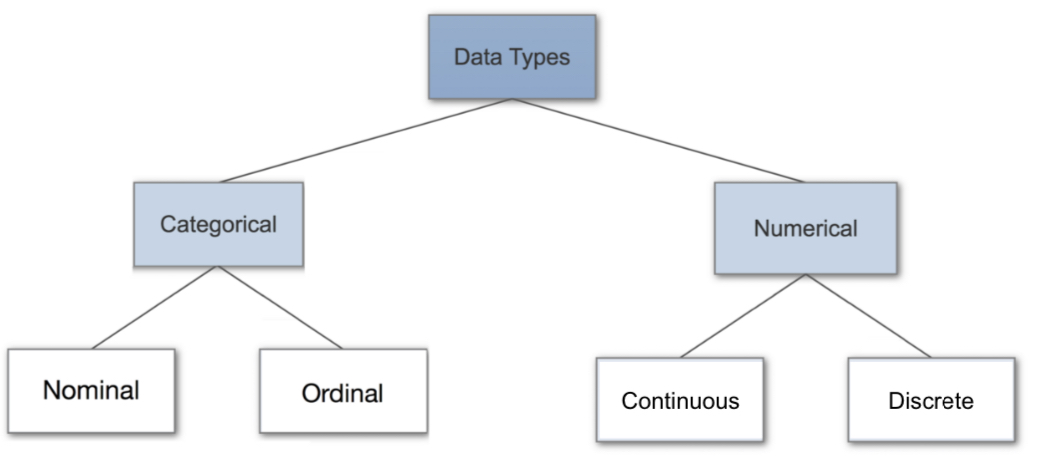

🤖 Embedded Machine Learning

🎯 Ziel

Verständnis für die Anwendung von Machine Learning (ML) auf Embedded-Systemen mit eingeschränkten Ressourcen.

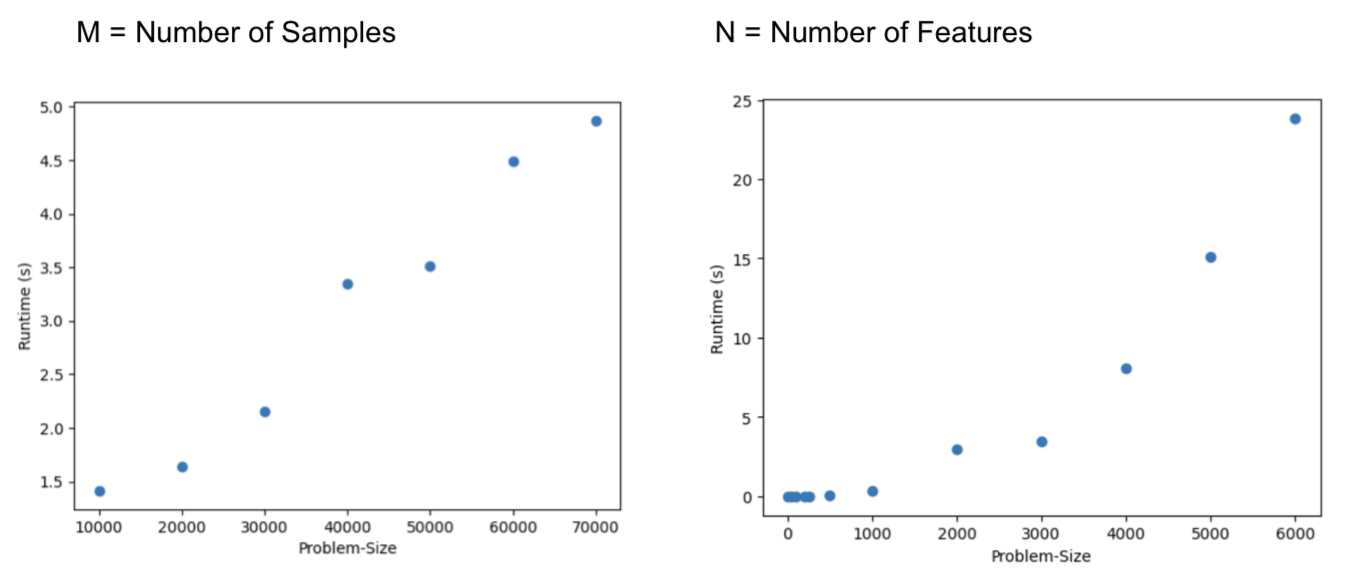

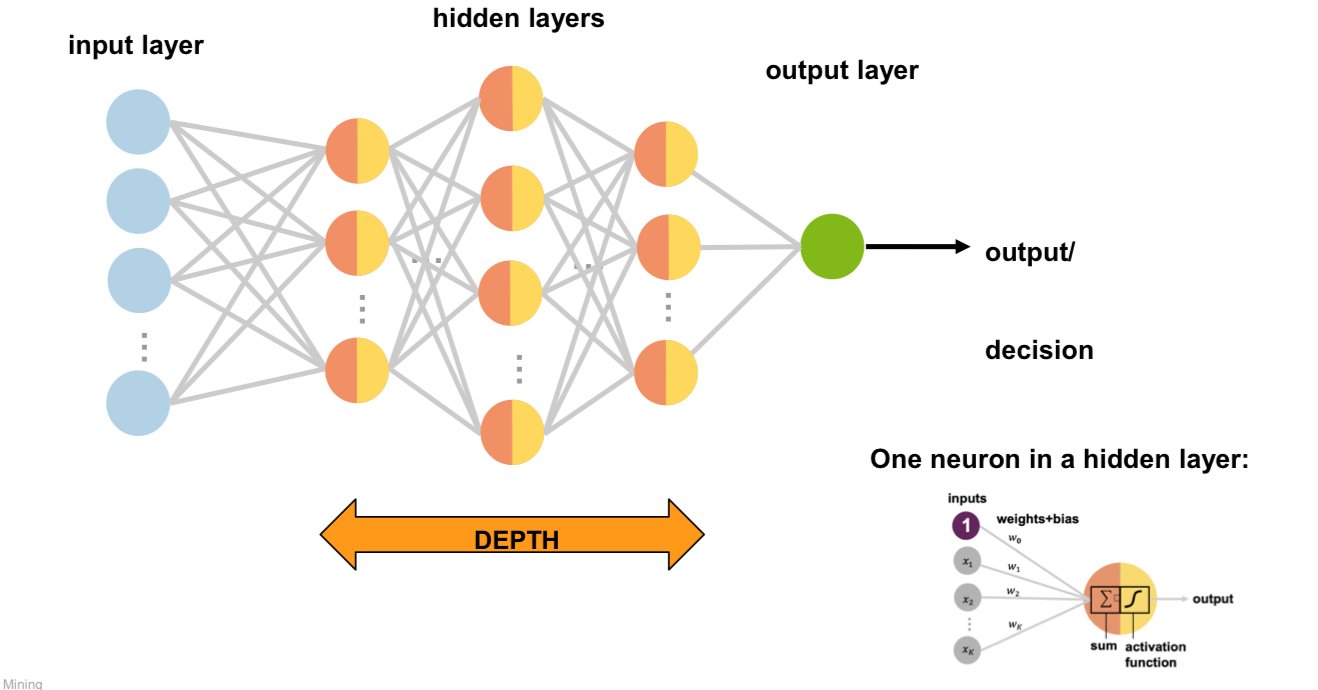

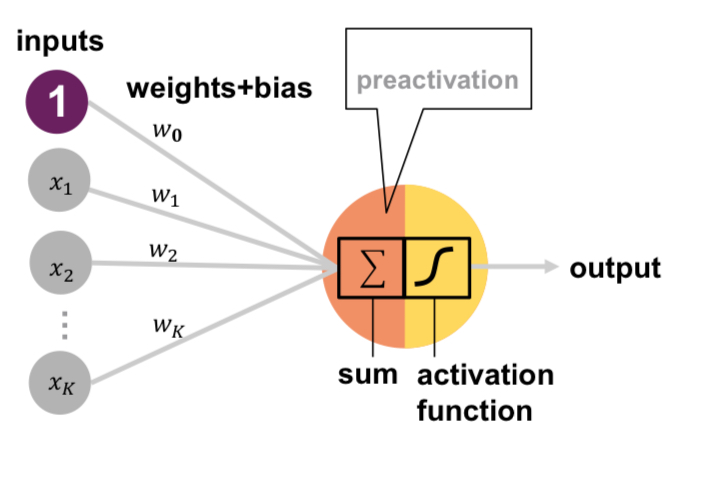

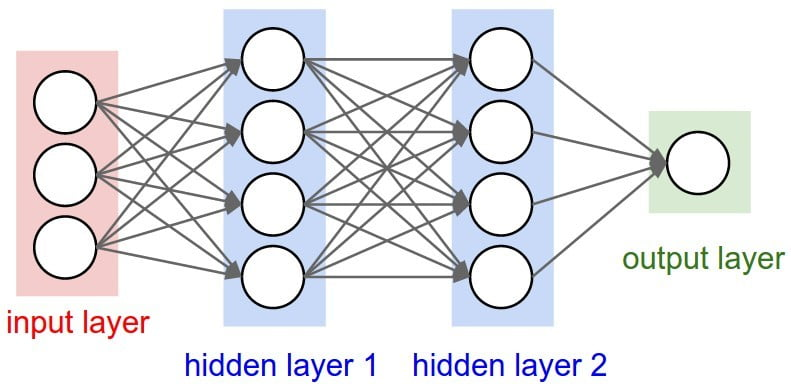

🧠 Grundlagen Neuronaler Netze

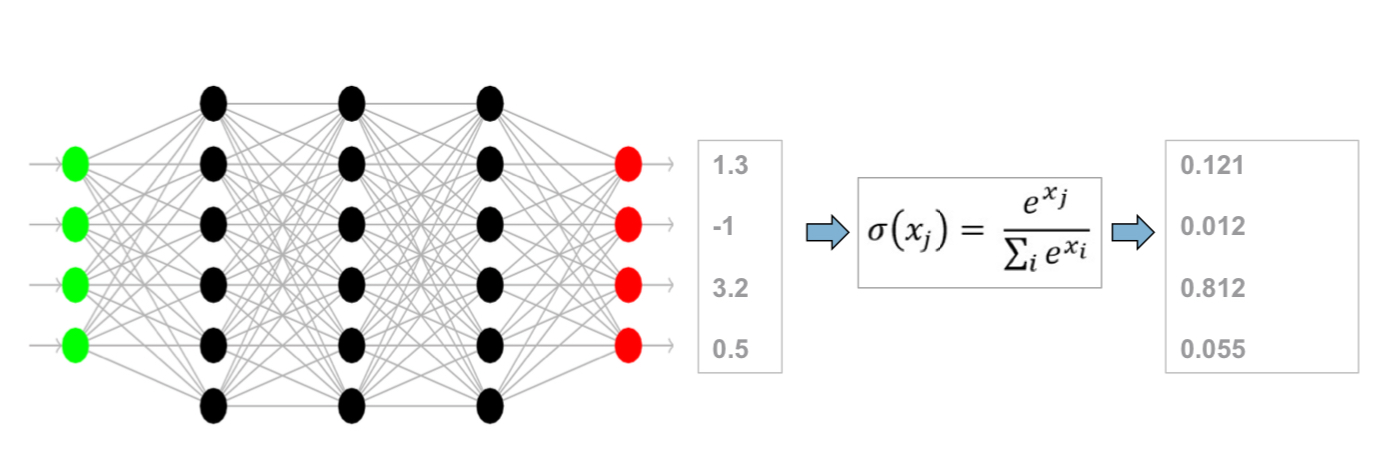

Feed Forward Netze

- Bestehen aus: Eingabeschicht, versteckten Schichten, Ausgabeschicht

- Verbindungen zwischen allen Neuronen jeder Schicht

- Können beliebige stetige Funktionen approximieren

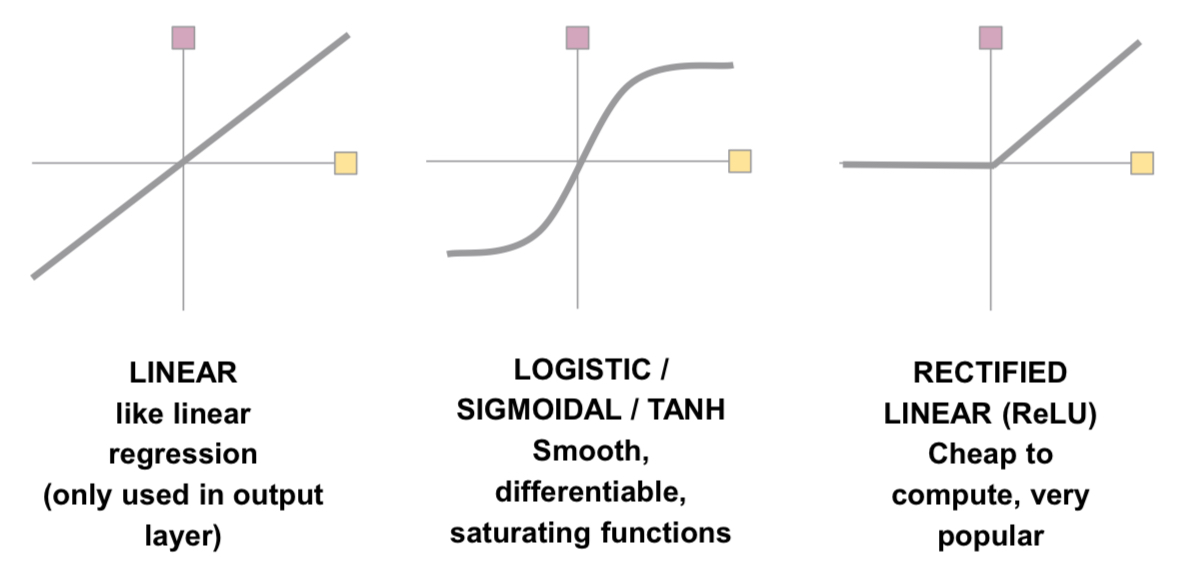

Aktivierungsfunktionen

| Funktion | Formel / Verhalten | Verwendung |

|---|---|---|

| Sigmoid | Klassisch, nicht mehr empfohlen | |

| Tanh | Besser als Sigmoid | |

| ReLU | Standard für hidden layers | |

| Leaky ReLU | Vermeidet "Dead Neurons" |

📝 Beispiel: MNIST Dataset

- Handgeschriebene Ziffern (0–9)

- 28×28 Pixel, Graustufen

- Trainingsdaten: 60'000 Bilder, Testdaten: 10'000

- In Keras integriert:

keras.datasets.mnist.load_data()

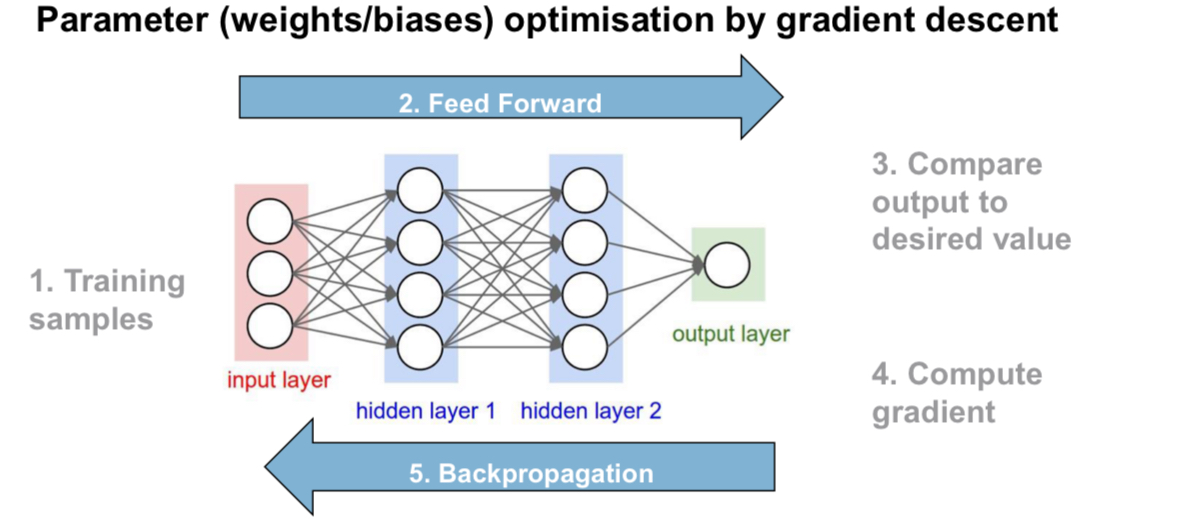

⚙️ Trainingsablauf

- Initialisierung: Gewichtung & Architektur definieren

- Forward Pass: Input → Output berechnen

- Loss berechnen: z. B. mit

categorical_crossentropy - Backpropagation: Gradienten berechnen

- Optimierung: z. B. mit

Adam,SGD,RMSprop - Wiederholung über viele Epochen

Codebeispiel mit Keras

model = keras.Sequential([ keras.Input(shape=(28, 28, 1)), layers.Flatten(), layers.Dense(16, activation="relu"), layers.Dense(16, activation="relu"), layers.Dense(10, activation="softmax"), ]) model.compile(optimizer="adam", loss="sparse_categorical_crossentropy", metrics=["accuracy"]) model.fit(x_train, y_train, batch_size=50, epochs=5, verbose=1)

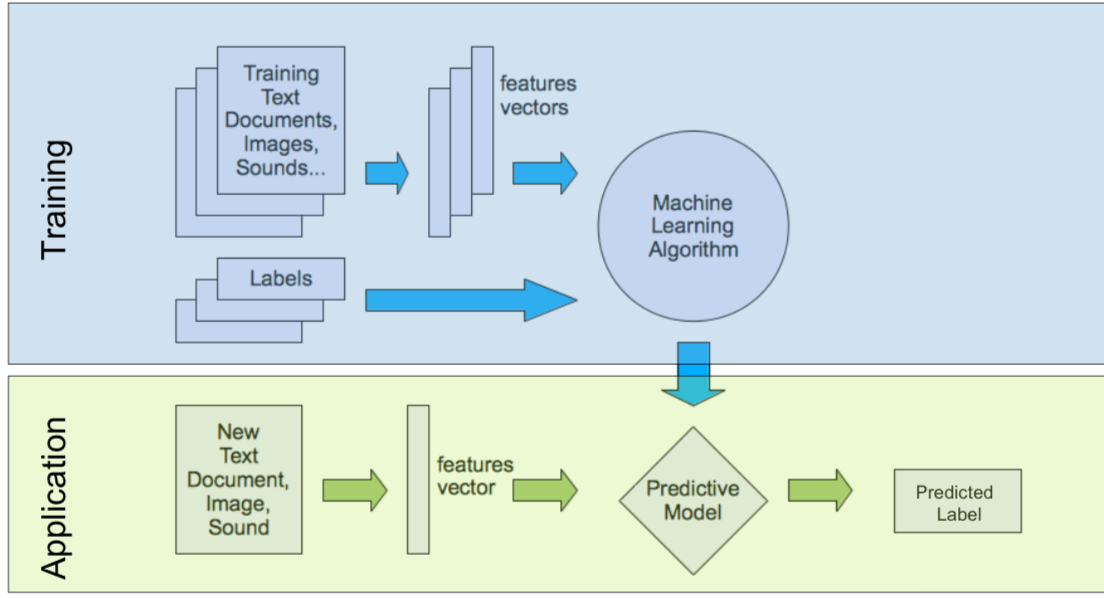

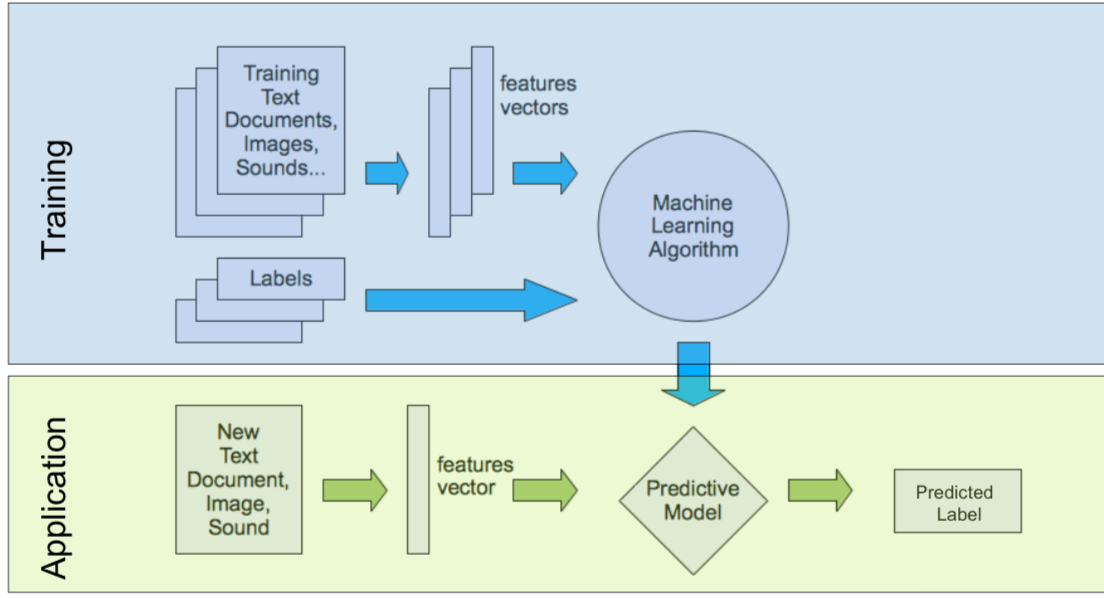

⚙️ Training vs. Inferenz

| Phase | Beschreibung |

|---|---|

| Training | Nur auf leistungsstarken Systemen |

| Inferenz | Optimiert für Embedded (z. B. Raspberry Pi, Jetson Nano) |

🧰 Frameworks

| Framework | Beschreibung |

|---|---|

| TensorFlow | Marktführer, weit verbreitet |

| Keras | High-Level API auf TensorFlow |

| PyTorch | Flexibel & beliebt bei Forschung |

| TFLite | Optimiert für Embedded Inferenz |

🖼️ Praxisszenario

- Kamera → Bild → OpenCV-Preprocessing → TensorFlow-Modell → Klassifikation

🧪 Lab Setup

- Eingabegerät: USB-Kamera

- Hardware: Raspberry Pi

- Training auf PC, Deployment auf Pi

🪄 Optimierungen für Embedded

- Quantisierung (8-bit statt 32-bit)

- Pruning (Entfernung unwichtiger Gewichte)

- Model Compression (z. B. mit TFLite Converter)

Embedded Machine Learning macht es möglich, KI in kleine Geräte zu bringen – lokal, datensparsam und reaktiv.

Analysis

Integrieren & Ableiten

De L'Hospital

Grenzwerte der form f(x)/x

Folgen

Reihen

Übersicht Potenzreihen Taylorreihen

Anderes

Ableiten

De l'Hospital

Wird verwendet um Grenzwerte der Form zu berechnen

1. Regel (Oberer Intervalstrecke)

Aus

oder

folgt

2. Regel (Untere Intevalstrecke)

Aus oder

folgt

Integrationsregeln

| Ableitung | Ausgangsfunktion | Stammfunktion |

|---|---|---|

Substitutionsregel

Wenn Produkt vonrhanden links -> rechts

Wenn kein Produkt vorhandne, rechts -> links

Partielle Integration

Wenn keine (teilweise) Ableitung vorhanden ist

Partialbruchzerlegung

-> Gleichung muss IMMER stimmen sommit gilt:

Umkehrfunktionen

Wichtige Funktionen

Übersicht von Folgen

Arithmetische Folge

Konstante Differenz zu Folgegliedern

Beispiel

5, 8, 11, 14, 17, ..., 26 (+3)

## Geometrische Folge

Beispiel

Eigenschaften von Folgen

Konvergent

Wenn die Folge einen Grenzwert besitzt.

Divergent

Wenn die Folge keinen Grenzwert besitzt.

Übersicht Reihen

Arithmetische Reihe

Folge von Partialsummen Sn einer arithmetischen Folge

Potenzreihen

Entwicklungspunkt

Taylorreihen

Eine beliebig oft differenzierbare Funktion und

Zusammenfassung

Ableiten

| Ableitung | Ausgangsfunktion | Stammfunktion |

|---|---|---|

Wichtige Beispiele

Substitutionsregel

Wenn Produkt vonrhanden links -> rechts

Wenn kein Produkt vorhandne, rechts -> links

Partielle Integration

Wenn keine (teilweise) Ableitung vorhanden ist

Grenzwerte mit De L'Hospital

Wird verwendet um Grenzwerte der Form zu berechnen

1. Regel (Oberer Intervalstrecke)

Aus oder

folgt

2. Regel (Untere Intevalstrecke)

Aus oder

folgt

Reihen

Potenzreihen

Entwicklungspunkt

Taylorreihen

Eine beliebig oft differenzierbare Funktion und

-

SQL

-

SQL Queries

Data Devinision Language

Sturktur, nicht den Inhalt

- Erzeugen, Ändern, Löschen von Datenbanken, Tabellen und Beziehungen

- SQL Befehle: CREATE, ALTER, DROP

Constraints

- CHECK

- NOT NULL

- UNIQUE

- PRIMARY KEY

- FOREIGN KEY

Unterschied Unique Key und Primary Key

Unique erlaubt NULL Werte, Primary Key nicht

Foreign Key Triggers

FOREIGN KEY

NO ACTION

Keine Aktion ausführen

NO ACTION

CASCADE

In allen Tabellen den Wert löschen

SET NULL / DEFAULT

Den Wert NULL / Standard setzen

Tabellen erstllen

LIKE

- Erzeugt eine neue Tabelle Besucher2 mit den gleichen Attributen wie Besucher

CREATE TABLE Besucher2 (LIKE Besucher)

### Tabelle einer Query erstellen

- Speichert die Resultate der Query in einer neuen Tabelle

- Übernimmt keine Constraints / Schlüssel, etc.

CREATE TABLE <tableName> AS (<query>);

Unterschied zur View

Die View zeigt die aktuellen Daten der Tabelle an, eine Tabelle mit einer Query ist ein Screenshot eines alten Standes.

INSERT INTO

- Einfügen ganzer Resultattabellen

- Query muss kompatibelm mit tableName sein.

INSERT INTO <tableName> ( <query> );

UPDATE

UPDATE <tableName>

SET <attributeName> = <attributeValue>

{, <attributeName> = <attributeValue>}

WHERE (<query>);

- Aufpassen, dass Primary Keys nicht überschrieben werden. (Duplikate)

CASCADE

DML (Data Manipulation Language)

Aggregatfuntionen ohne Gruppierung

| SQL-Keyword | Beschreibung |

|---|---|

| COUNT | Zählt die Anzahl der Element |

| MAX | Maximaler Wert der Elemente |

| MIN | Minimaler Wert der Elemente |

| SUM | Summe aller Elemente |

| AVG | Durschnitt der Werte der Elemente |

Count

COUNT(

COUNT(*) zählt alle Tupel, es gibt kein Tupel, bei dem alle Attribute gleichzeigit NULL sein können.

COUNT(DISTINCT}NAME): zählt die Anzahl verschiedener Namen

Bestellumsatz pro Kunde, unabhängig von der einzelnen Bestellung

SELECT kdNR, SUM(menge * preis) AS UMSATZ

FROM Bestellposition JOIN Kaufhistorei ON bestNr = bNr

GROUP BY kdNr;

Grösster Bestellumsatz

SELECT MAX(Umsatz) AS GroessterUmsatz

FROM (SELECT kdNR, SUM(menge * preis) AS UMSATZ

FROM Bestellposition JOIN Kaufhistorei ON bestNr = bNr

GROUP BY kdNr) AS x;

# Aggregatsfunktionen mit Gruppierung

Reihenfolge der SQL Abfragen}

- FROM

- WHERE

- GORUP BY

- HAVING

- SELECT

- ORDER BY

Having

Alle Sätze, wo alle numerischen Werte grösser als 2 sind:

HAVING COUNT(*) > 2

Datentypen

| Datentyp | Beschreibung |

|---|---|

| CHAR(n) / CHARACTER(n) | Zeichenkette, fixe Länge (nicht empfohlen) |

| CHAR VARYING(n) / VARCHAR(n) | Zeichenkette, variable Länge (Postgres TEXT) |

| INT / INTEGER | Ganzzahl |

| REAL | Flieskommazahl |

| NUMERIC (precision, scale) / DECIMAL (precision, scale) | Festkommazahl |

ddl

Erzeugen einer Datenbank

CREATE SCHEMA <dbName> [AUTHORIZATION <userName>];

Löschen der DB

DROP SCHEM <dbName> [CASCADE];

Bearbeiten einer DB

ALTER TABLE <dbName> ADD

Email varchar(255);

EBNF

| Symbol | Bedeutung |

|---|---|

| "" | Übernahme als Text (wörtlich) |

| \ | |

| () | Gruppierung |

| [] | optionalen Inhalt, der Null oder einmal vorkommt |

| {} | Beliebig Wiederholung |

| <> | Nichterminale Variablen |

| ::= | Definition / Produktregel (z.B. a::= b) |

Probleme

Auswahl im Select, wo ColumnName mit ColumnName direkt verglichen wird

SELECT *

FROM Besucher

WHERE EXISTS (SELECT 1

FROM Besucher

WHERE Vorname=Vorname AND

NOT (Name=Name));

Subqueries (in WHERE) mit EXISTS

SELECT *

FROM Besucher AS x

WHERE EXISTS (SELECT 1

FROM Besucher AS y

WHERE x.Vorname=y.Vorname AND

NOT (x.Name=y.Name));

Kreuzprodukt + Selektionsprädikat für gemeinsame Attrivute + autom. Umbenennung/Projektion von Attributen.

Views

Common Table expressions

analog wie eine abgeleitete Tabelle oder eine Sicht - ein tempöräres Resultat einer Abfrage auf das in einer Tabelle

WITH cte_name (column_list) AS

(

CTE_query_defiition

)

<query>;

WITH DSPpS AS (

SELECT Strasse, AVG(Suppenpreis) AS DurchscnittsPreis

FROM Restaurant

GROUP BY STRASSE

)

SELECT Name, Suppenpreis, Durchschnittspreis

FROM Restaurant

JOIN DSPpS

ON Restaurant.Strasse = DSPpS.Strasse;

Vorteile

-

Grosse Queries besser stukturieren

-

Abfragen besser lesbar, da die einzelnen Teilabfragen einen eigenen Namen haben,

-

Mehr oder menschlichen Denkweise

-

unterstützen rekursive Abfragen

PGSQL (Programmieren in SQL)

Grundaufbau

DECLARE

- Dklarationsblock für Variablen, Konstanten

- Der DECLARE Abschnitt ist Optional

BEGIN

- Ausführungsteil

EXCEPTION

- Ausnahmeverarbeitung

- Der EXCEPTION Abschnitt ist optional

END;

Beispiel (Hallo Welt)

CREATE OR REPLACE FUNCTION HalloWelt() RETURNS void AS

$body$

BEGIN

RAISE NOTICE 'Hallo Welt';

END;

$body$

LANGUAGE plpgsql;

-- Funktion ausführen

SELECT HalloWelt();

-- Funktion löschen

DROP FUNCTION HalloWelt();

Variablen

DECLARE

KNR INTEGER;

ProdNr INTEGER := 0; -- Initialisierung zu 0

UserID Users.UserID%TYPE; -- Typ von UserID kopieren

Zeile users%ROWTYPE; -- Ganze Zeile einer Tabelle kopieren

name RECORD; -- untypisierte Zeile

Eingebaute Funktionen

- Konfigurationsfunktionen: Geben Auskunft über den Zustand des Systems

- Datum- und Zeitfunktionen: Funktionen zur Bearbeitung von Daten und Zahlen

- Mathematische Funktionen: sum(), avg()

- Metadaten-Funktionen: has_any_column_privilege(user, table, privilege)

- Zeichenfolgefunktionen: length(string), lower(string

- Konversions- /Datenttypprüffunktionen: cast('100' as integer)

- Rangfolgefunktionen: rank()

Konstrollstrukturen

IF Boolean_expression

{ sql_statement }

[ ELSE

{sql_statement}

]

CASE

WHEN Boolean_expression THEN { sql_statement }

WHEN Boolean_expression THEN { sql_statement }

ELSE -- DEFAULT

END

LOOP

EXIT WHEN Boolean_expression;

{ sql_statement }

END LOOP

WHILE Boolean_expression

BEGIN

{ sql_statement }

END;

FOR counter in initial_value .. final_value LOOP

{ sql_statement }

END LOOP;

Cursor

- Ein Cursor erlaubt uns nicht das gesamte Ergebnis einer Query auf einmal zu verarbeiten, sondern Zeile um Zeile.

- Den jeweils aktuellen Datensatz kann man für bestimmte Operationen verwenden. So eignet sich ein Cursor dazu, eine bestimmte Aktion in gleicher Art und Weise uaf mehrere Zeilen hintereinander anzuwenden.

DECLARE cursor_name CURSOR

FOR {select statement}

[FOR UPDATE];

Verwenden des Cursors

OPEN cursor_name; -- Cursor muss vor dem verwenden geöffnet werden

FETCH cursor_name

INTO @variable1, @variable2, ...; -- Lesen der Daten in Variablen

CLOSE cursor_name; -- Cursor muss geschlossen werden

Beispiel

CREATE OR REPLACE FUNCTION Show_AleBesuchernamen()

RETURNS VOID AS $$

DECLARE

rec_Besucher record;

c_Namen FOR SELECT Name, Vorname FROM Besucher;

BEGIN

OPEN c_Namen;

LOOP

FETCH c_Namen INTO rec_Besucher;

EXIT WHEN NOT FOUND;

RAISE NOTICE 'Name % Vorname % ', rec_besucher.Name, rec_besucher.Vorname;

END LOOP;

CLOSEc_Namem;

END; $$

LANGUAGE pspgsql;

Trigger

Prinzip: ECA

- Event - Condition - Action

Auslösung

- BEFORE: vor der DML-Operation

- AFTER: nach der DML-Operation

- INSTEAD OF: Anstelle der DML-Operation

Einsatz

Sinnvoll, wenn

- Überprüfung / Funktion oft ausgefüht wird.

- SQL-Constraints nicht ausreichen

- Logik von der DB und nicht von den Anwendungsprogrammen durchgeführt weden soll.

- Lösung dadurch stark vereinfacht wird.

Probleme

- Fehlerbehandlung

- Testen, Debuggen

- Gefahr der Unübersichtlichkeit

- Ergebnis von Triggeroperationen evtl abhängig vonder Aufrufreihenfolge

- Terminierung vone geschachtelten Triggeraufrufen

Beispiel

-- Funktion für Trigger erzeugen

CREATE OR REPLACE FUNCTION log_Strasse()

RETURNS TRIGGER LANGUAGE PLPGSQL AS $$

BEGIN

IF NEW.Strasse <> OLD.Strasse THEN INSERT INTO

Adressänderung(Name, Vorname, StrasseAlt, StrasseNeu, Geändert_am)

VALUES(OLD.Name, OLD.Vorname, OLD.Strasse, NEW.Strasse, now());

END IF;

RETURN NEW;

END;

-- Trigger erzeugen

CREATE TRIGGER Strassenänderung

BEFORE UPDATE

ON Besucher

FOR EACH ROW

EXECUTE PROCEDURE log_Strasse();

Vergleich

Aufruf

| Stored procedures / Functions | Trigger |

|---|---|

| Durch Benutzer oder Anwendungsprogramm | Durch DBMS, in Abhängigkeit von Datenänderungen |

| Transaktionskontrolle | Keine Transaktionskontrolle |

Einsatzbereiche

| Stored procedures / Functions | Trigger |

|---|---|

| Kapselung von "business reules" | Konsistenzsicherung |

| Optimierung von Abfragen, Reduktion des Netzwerkverkehrs -> Batch Processing | Logging |

| Erhöhte Sicherheit benötigt | Nachführen von Tabellen |

Probleme

| Stored procedures / Functions | Trigger |

|---|---|

| Fehlerbehandlung | Kompliziert zu testen |

| Aufrufreihenfolge nicht determiniert |

Konsistenzbedingungen

- Verhindern, dass falsche Daten in die Datenbank gelangen können

Massnahmen zu Sicherstellung

- Bereichsintegrität: Der Wert eines Attributes muss in einem bestimmten Wertebereich liegen. Sichergestellt durch Datentypen / Domänen sowie NULL bzwh. NOT NULL.

- Entitätsintegrität: Der Primärschlüssel einer Tabelle mus eindeutig und immer vorhanden (NOT NULL) sein. Sichergestellt wurdch das RDBMS durch Definition einer nicht-leeren Attributmenge als Primary Key.

- Referentielle Integrität: Der Inhalt eines Fremdschlüssels muss entweder leer sein (NULL), oder genau eine Tupel, mit einem solchen Schlüsslwert, muss in der referenzierten Tabelle vorhanden sein.

Einschränkungen, Constraints

Schränken die Menge der möglichen Datenwerte ein

- UNIQUE: Nebst Primär- und Fremdschlüsseln können weitere Schlüssel definiert werden.

- CHECK: Es können Regeln definiert werden, die Aussageb über Attribute einer Tabelle (genauer eines Tupels) festlegen

CONSTRAINT ck_artikel_ekpreis_vkpreis

CHECK (ekpreis >= 0 AND vkpreis >= ekpreis);

- DEFAULT:Es können Regeln definiert werden, welche Werte als Vorgabewerte verwendet werden sollen, falls für ein Attribut kein Wert geliefert wird.

CONTSTRAINT df_auftrag_datum DEFAULT SYSDATETIME();

Komplexere Geschäftsregeln / Business Rules

- Zusammenhänge zwischen Daten verschiedener Tabellen herstellen

Java IDBC

Verbindung herstellen

import java.sql.*;

// Datenbankverbindung konfigurieren

String url = "jdbc:postgresql://localhost/test";

Properties props = new Properties();

props.setProperty("user", "fred");

props.setProperty("password", "secret");

props.setProperty("ssl", "true");

// Verbindung initialisieren

Connection conn = DriverManager.getConnection(url, props);

Query

Statement st = conn.createStatement();

ResultSet rs = st.executeQuery("SELECT * FROM myTable WHERE columnfoo ==500");

while (rs.next()) {

System.out.print("Column 1 returned");

System.out.println(rs.getString(1));

}

rs.close();

st.close();

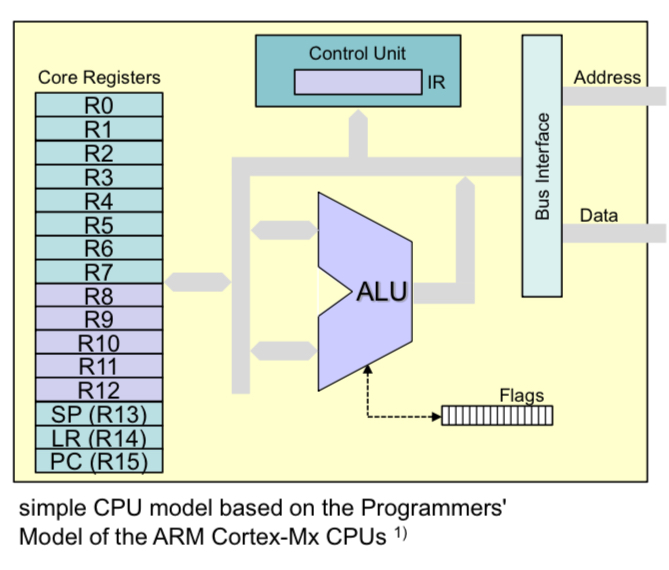

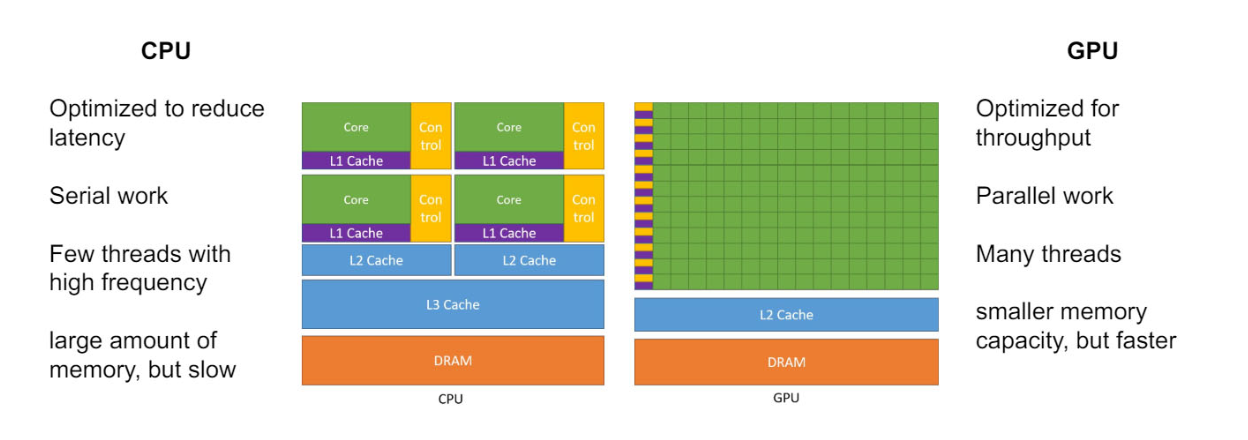

CT1 - HS23

Cortex Architektur

Die Cortex Architektur ist auch als ARM Architektur bekannt. Diese ist in den meisten Embedded Prozessoren, in letzter Zeit aber auch in Mobile, sowie Desktop (Apple Silicon) vertreten.

CPU Modell

Die CPU besteht aus einzelnen Komponenten. Diese sind in folgende:

- Core Registers

- 32 Bit ALU (Arithmetic Logic Unit)

- Flags (APSR)

- Control Unit with IR (Instruction Registers)

- Bus Interface

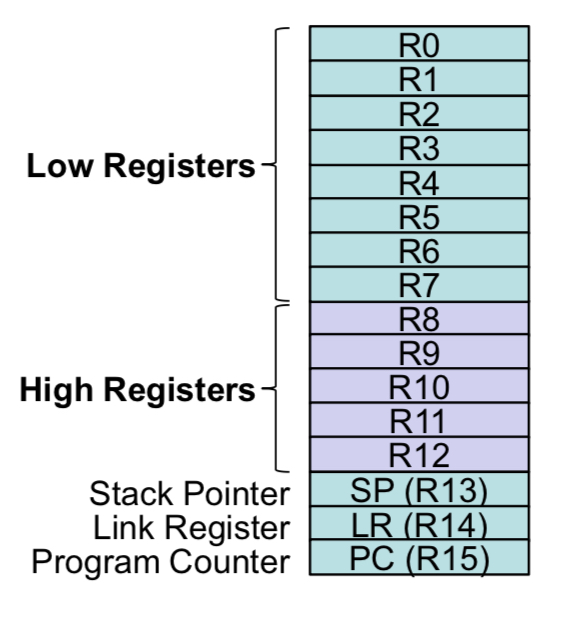

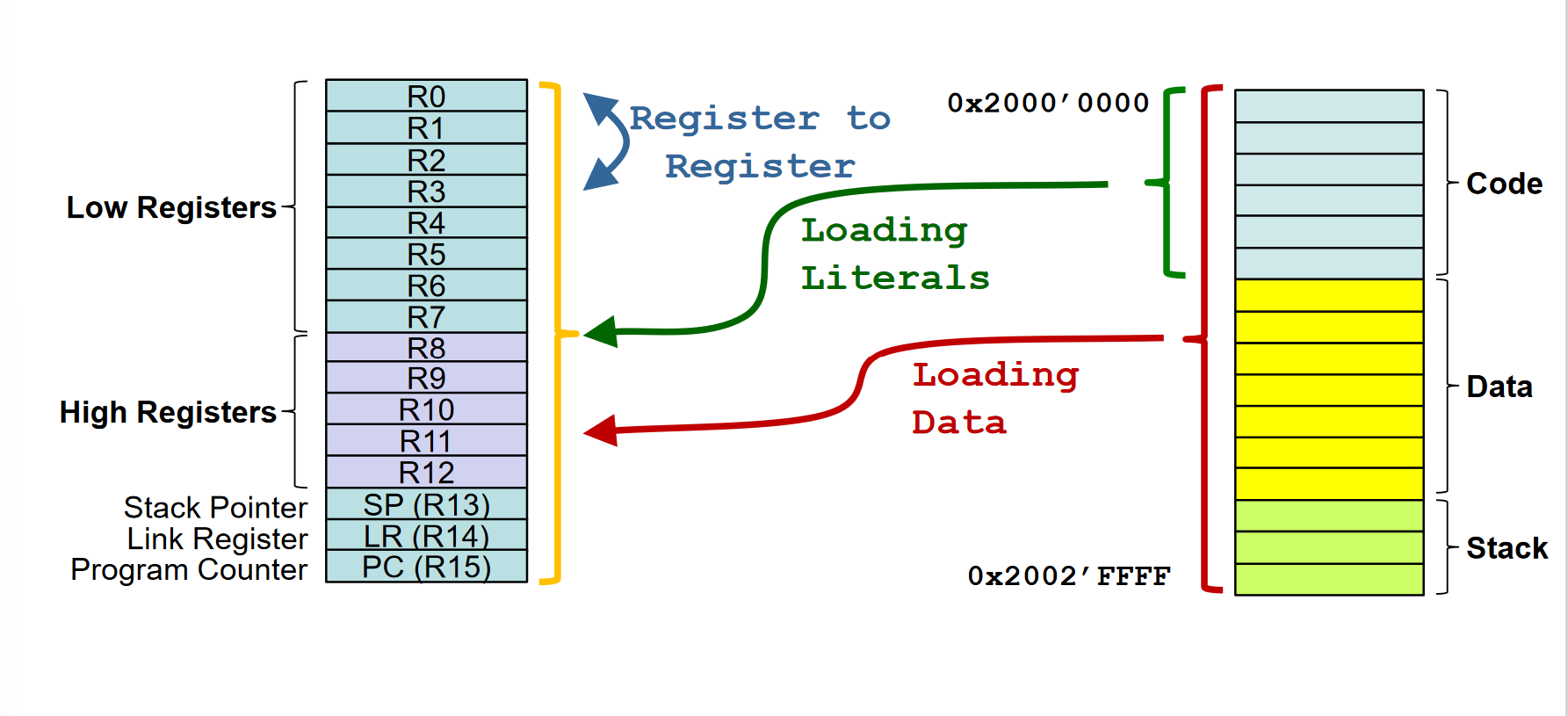

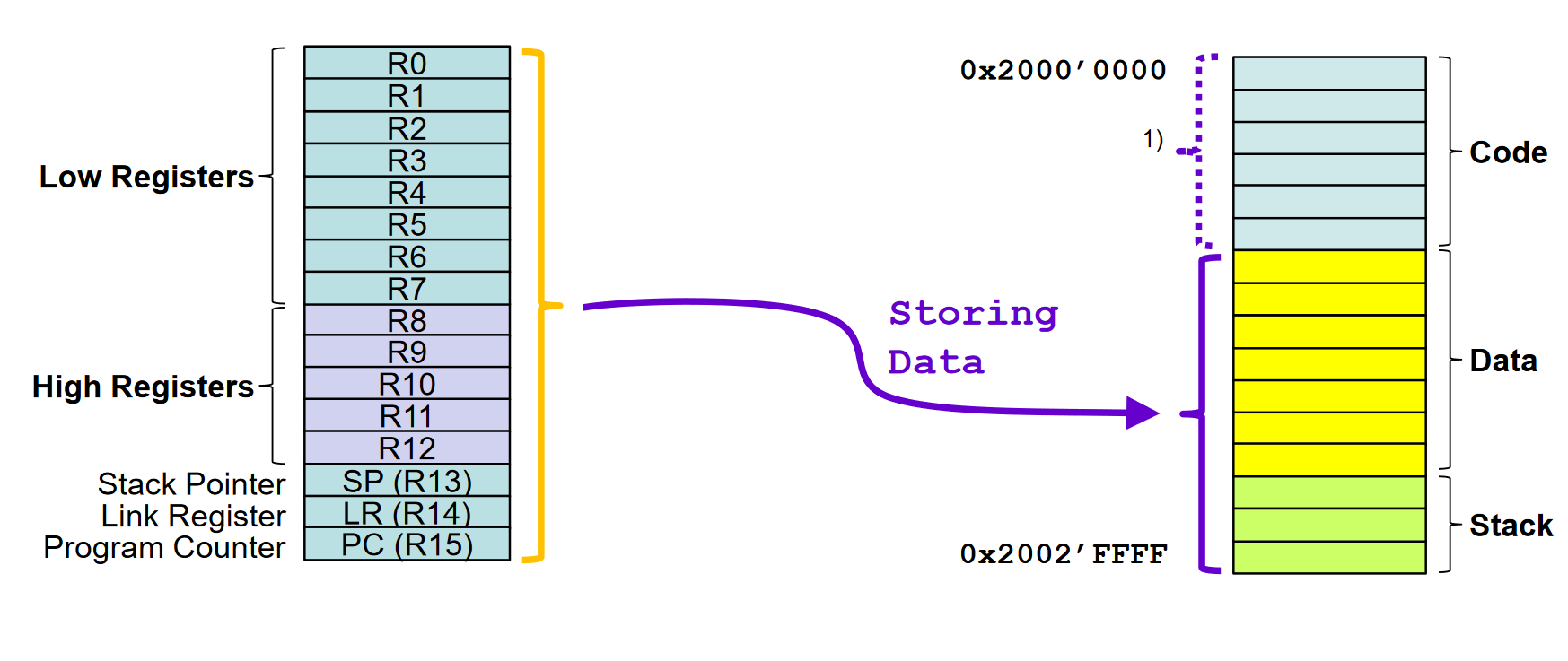

16 Core Registers

- Jedes Register ist 32 Bit breit

- 13 General Purpose Register

- Low Registers R0 - R7

- High Registers R8 - R12

- Used for temporary storage of data and addresses

- Program Counter (R15)

- Addresss der nächsten Instruktion

- Stack Pointer (R13)

- Last-In First-Out für temporäre Datenspeicherung

- Link Register (R14)

- Enthält die Adresse zu der zurückgesprungen wird, wenn eine Routine fertig ist.

In den meisten Fällen werden nur die unteren Low Registers (Byte verwendet). Würde die Standardeinheit jetzt 16 oder gar 32 Bit sein, dann müssen die High Registers zusätzlich noch gelesen werden.

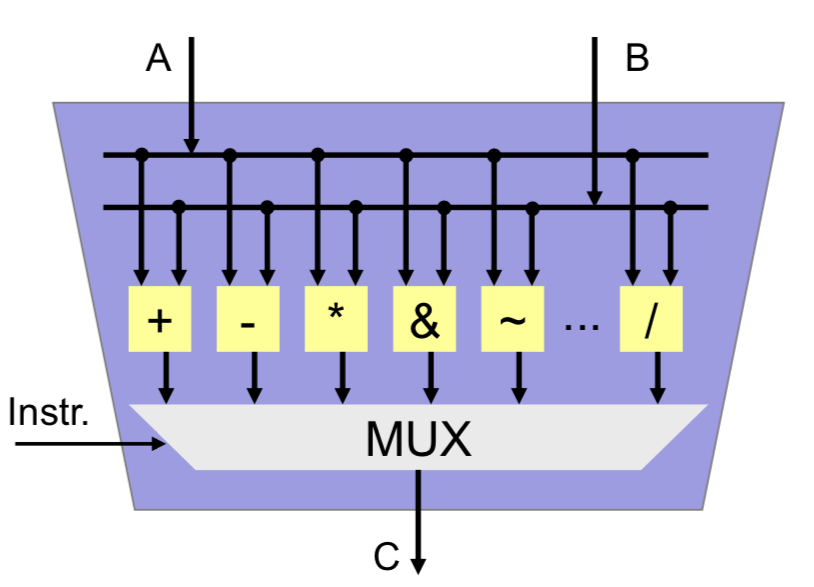

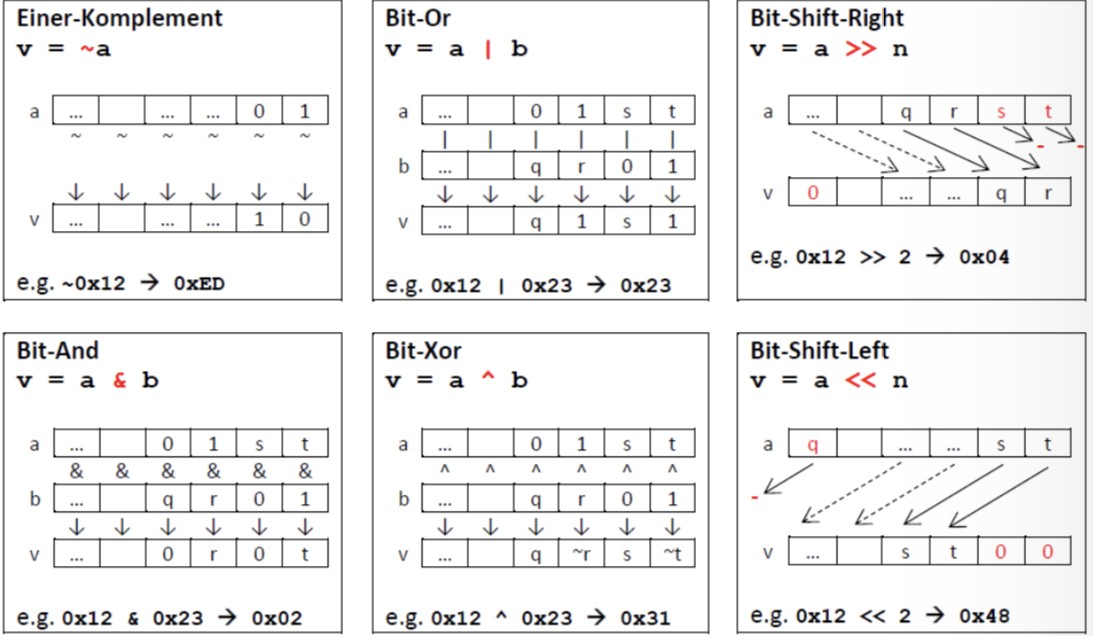

ALU (Arithmetic Logic Unit)

- 32 bit wide data processing unit

- Inputs A and B

- Results in C

- Integer Arithmetic

- Addition / Subtraction

- Multiplication / Division

- Sign extension

- logic operations

- AND

- NOT

- OR

- XOR

- shift /rotate

- left

- right

Flags (APSR)

Bits werden von der CPU anhand des Resultats der ALU gesetzt

| Wert | Bedeutung |

|---|---|

| N | Negative |

| Z | Zero |

| C | Carry |

| V | Overflow |

Control Unit

- Instruction Register (IR)

- Machine code (opcode) of instruction that is currently being executed

- Controls execution flow based on instruction on IR

- Generates control signals for all other CPU components

Bus Interface

- Interface zwischen interner CPU und externen Bus Systemen

- Beinhlatet register um addressen zu speichern

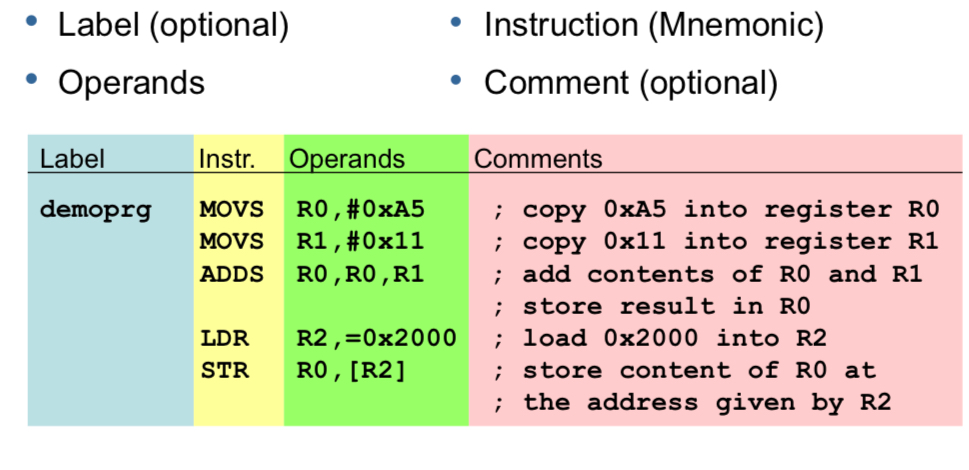

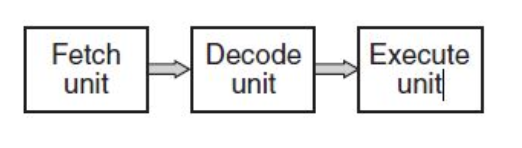

Instruction Set Architecture (ISA)

Instruction Set

- Verfügbare Anweisungen

Processing Width

- Bitbreite (8/16/32 Bit)

Register Set

- Wie viele Register gibt es?

- Wie gross sind die Register?

Addressodell

- Wie kann auf Speicher zugegriffen werden?

- Wie kann auf IO zugegriffen werden?

### Arbeitsweise

Prozessoren interpretieren binären Code als Instruktionen.

Styleguide

7 Segment Anzeige

Eine 7-Segment-Anzeige wird für Hexadezimalzeichen verwendet. Dabei wird jedes Segment der Anzeige einzeln angesteuert.

Theorie

Bei der Zahl 1 würden die Segment B und C aufleuchten. Im Register heisst dass dann die Bits 1 und 2 aktiv sind. Somit würde der Wert 0000'0110 bzwh. 0x06 sein.

Ist die Anzeige active-low (invertiert), dann muss 1111'1001 bzwh. 0xF9 geschrieben werden.

Bei 16 Zeichen ist die manuelle Umwandlung relative mühsam. Wir können das Umwandeln aber auch einfach dem Compiler überlassen. Dies hat zudem den Vorteil, dass es deutlich einfacher zu verstehen ist.

Code

Ich empfehle den Code immer so "blöd" wie möglich zu machen. Jedoch ist es auch wichtig, dass nicht einfach zufällige Zahlen irgendwo stehen (sog. Magic Numbers).

Define für jedes Segmentstück definieren

Wie bereits oben beschreiben, ist es relativ mühsam die einzelnen Zahlen zu definieren. Um dies zu vereinfachen können wir die einzelnen Bits einem define zuordnen.

Dass könnte dann z.B. so aussehen. Es ist auch möglich die decimalzahlen, bzwh. die HEX Zahlen direkt zu verwenden.

#define LED_A 1<<0

#define LED_B 1<<1

#define LED_C 1<<2

#define LED_D 1<<3

#define LED_E 1<<4

#define LED_F 1<<5

#define LED_G 1<<6

#define LED_DP 1<<7

Definieren der Zahlen

Nun ist es wessentlich einfacher diversen Zeichen darzustellen. Dazu müssen wir nur noch die verwendeten Segmente mit einem ODER verknüpfen.

#define LED_SEGMENTE_ZAHL_1 (LED_B | LED_C)

#define LED_SEGMENTE_ZAHL_2 ...

Umwandeln